Qwq 32B Preview

简介 :

QwQ-32B-Preview是一个由Qwen团队开发的实验性研究模型,旨在提高人工智能的推理能力。该模型展示了有前景的分析能力,但也存在一些重要的限制。模型在数学和编程方面表现出色,但在常识推理和细微语言理解方面还有提升空间。该模型使用了transformers架构,具有32.5B个参数,64层,以及40个注意力头(GQA)。产品背景信息显示,QwQ-32B-Preview是基于Qwen2.5-32B模型的进一步开发,具有更深层次的语言理解和生成能力。

需求人群 :

QwQ-32B-Preview模型的目标受众是研究人员和开发者,特别是那些在自然语言处理和人工智能领域寻求高性能模型的专业人士。由于其在数学和编程方面的优势,该模型特别适合需要进行复杂推理和文本生成的应用场景。

使用场景

研究人员使用QwQ-32B-Preview模型进行学术论文的自动摘要生成。

开发者利用该模型开发聊天机器人,提供更自然的语言交互体验。

教育机构使用QwQ-32B-Preview模型辅助教学,生成教学材料和解答学生问题。

产品特色

支持文本生成:QwQ-32B-Preview模型能够生成文本,适用于聊天、问答等多种场景。

多语言混合和代码切换:模型可能会在不同语言之间意外切换,影响响应清晰度。

循环推理模式:模型可能会进入循环推理模式,导致回答冗长且无结论。

安全性和伦理考量:模型需要增强的安全措施以确保可靠和安全的性能。

性能和基准测试限制:模型在数学和编程方面表现出色,但在其他领域如常识推理和语言理解方面有待提高。

全32,768个token的上下文长度:模型能够处理较长的文本输入,适用于复杂任务。

使用教程

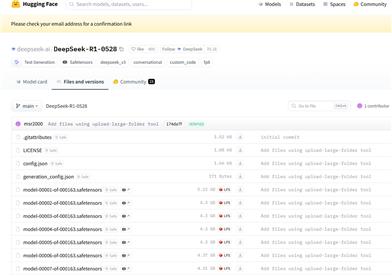

1. 访问Hugging Face网站并搜索QwQ-32B-Preview模型。

2. 根据页面提供的代码片段,导入必要的库和模块。

3. 使用AutoModelForCausalLM和AutoTokenizer从预训练模型加载模型和分词器。

4. 准备输入提示,例如“How many r in strawberry”,并将其封装成系统和用户的消息。

5. 使用tokenizer的apply_chat_template方法处理消息,并生成模型输入。

6. 将生成的输入传递给模型,并设置max_new_tokens参数以控制生成文本的长度。

7. 模型生成文本后,使用tokenizer的batch_decode方法将生成的ID转换回文本。

8. 输出最终的文本响应,可以是聊天回复或其他文本生成任务的结果。

精选AI产品推荐

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系统。它能够进行多模态推理,支持文本、图像、视频、音频和代码之间的无缝交互。Gemini在语言理解、推理、数学、编程等多个领域都超越了之前的状态,成为迄今为止最强大的AI系统之一。它有三个不同规模的版本,可满足从边缘计算到云计算的各种需求。Gemini可以广泛应用于创意设计、写作辅助、问题解答、代码生成等领域。

AI模型

11.4M

中文精选

Liblibai

LiblibAI是一个中国领先的AI创作平台,提供强大的AI创作能力,帮助创作者实现创意。平台提供海量免费AI创作模型,用户可以搜索使用模型进行图像、文字、音频等创作。平台还支持用户训练自己的AI模型。平台定位于广大创作者用户,致力于创造条件普惠,服务创意产业,让每个人都享有创作的乐趣。

AI模型

8.0M