Funaudiollm

简介 :

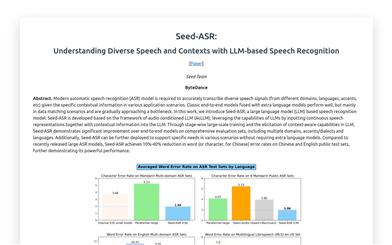

FunAudioLLM是一个旨在增强人类与大型语言模型(Large Language Models, LLMs)之间自然语音交互的框架。它包含两个创新模型:SenseVoice负责高精度多语种语音识别、情绪识别和音频事件检测;CosyVoice负责自然语音生成,支持多语种、音色和情绪控制。SenseVoice支持超过50种语言,具有极低的延迟;CosyVoice擅长多语种语音生成、零样本上下文生成、跨语言语音克隆和指令跟随能力。相关模型已在Modelscope和Huggingface上开源,并在GitHub上发布了相应的训练、推理和微调代码。

需求人群 :

FunAudioLLM的目标受众包括技术开发者、语音技术研究人员和企业用户,他们可以利用这一框架开发具有高级语音交互功能的应用,如语音翻译、情感语音聊天、交互式播客和有表现力的有声书朗读等。

使用场景

使用SenseVoice和CosyVoice集成开发情感语音聊天应用,提供温暖、友好的交互体验。

利用FunAudioLLM创建交互式播客,使听众能够与播客中的虚拟角色进行实时互动。

通过LLMs分析书籍情感并使用CosyVoice合成具有表现力的有声书,提升听众的阅读体验。

产品特色

高精度多语种语音识别:支持超过50种语言的语音识别,具有极低延迟。

情绪识别:能够识别语音中的情绪,增强交互体验。

音频事件检测:识别音频中的特定事件,如音乐、掌声、笑声等。

自然语音生成:CosyVoice模型可以生成具有自然流畅度和多语种支持的语音。

零样本上下文生成:无需额外训练即可生成特定上下文的语音。

跨语言语音克隆:能够复制不同语言的语音风格。

指令跟随能力:根据用户的指令生成相应风格的语音。

使用教程

访问FunAudioLLM的GitHub页面,了解模型的详细信息和使用条件。

根据需要选择合适的模型,如SenseVoice或CosyVoice,并获取相应的开源代码。

阅读文档,理解模型的输入输出格式以及如何配置参数以满足特定需求。

在本地环境或云平台上设置模型的训练和推理环境。

使用提供的代码进行模型训练或微调,以适应特定的应用场景。

集成模型到应用程序中,开发具有语音交互功能的产品。

测试应用程序以确保语音识别和生成的准确性和自然性。

根据反馈优化模型性能,提升用户体验。

精选AI产品推荐

GPT SoVITS

GPT-SoVITS-WebUI是一个强大的零样本语音转换和文本到语音WebUI。它具有零样本TTS、少样本TTS、跨语言支持和WebUI工具等功能。该产品支持英语、日语和中文,提供了集成工具,包括语音伴奏分离、自动训练集分割、中文ASR和文本标注,帮助初学者创建训练数据集和GPT/SoVITS模型。用户可以通过输入5秒的声音样本,即可体验即时的文本到语音转换,还可以通过仅使用1分钟的训练数据对模型进行微调,以提高语音相似度和逼真度。产品支持环境准备、Python和PyTorch版本、快速安装、手动安装、预训练模型、数据集格式、待办事项和致谢。

AI语音合成

6.9M

Clone Voice

Clone-Voice是一个带 web 界面的声音克隆工具,可使用任何人类音色,将一段文字合成为使用该音色说话的声音,或者将一个声音使用该音色转换为另一个声音。支持中、英、日、韩、法、德、意等 16 种语言,可在线从麦克风录制声音。功能包括文字到语音和声音到声音转换。优势在于简单易用且无需 N 卡 GPU,支持多种语言,录制声音灵活。产品目前免费使用。

AI语音合成

4.2M