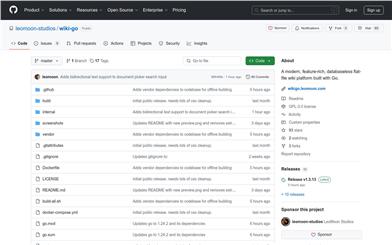

RLAMA

簡介 :

RLAMA是一個本地文檔問答工具,通過連接本地Ollama模型,為用戶提供文檔索引、查詢和交互功能。它支持多種文檔格式,確保數據完全在本地處理,保障隱私安全。該工具主要面向開發者和技術用戶,旨在提高文檔管理和知識檢索的效率,尤其適用於處理敏感文檔和私有知識庫。目前產品為開源免費版本,未來可能會有更多功能擴展。

需求人群 :

RLAMA主要面向開發者和技術用戶,尤其是那些需要處理敏感文檔、構建私有知識庫或需要高效文檔管理和查詢能力的專業人士。它也適合研究人員、企業內部知識管理系統開發者以及對本地數據安全有嚴格要求的用戶。

使用場景

企業內部文檔管理系統:利用RLAMA創建私有RAG系統,快速檢索技術文檔和項目手冊。

研究人員查詢文獻:通過RLAMA對研究論文進行索引和查詢,提高研究效率。

個人知識庫管理:將個人筆記、教程等文檔導入RLAMA,隨時進行交互式查詢。

產品特色

支持多種文檔格式(如PDF、DOCX、TXT等),滿足不同用戶需求。

本地處理所有數據,確保隱私和安全性,無數據外洩風險。

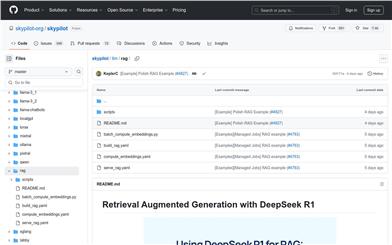

創建交互式RAG會話,方便用戶查詢文檔知識庫。

簡單易用的命令行工具,用戶可通過命令快速創建、管理和刪除RAG系統。

支持文檔索引和智能檢索,提升文檔查詢效率。

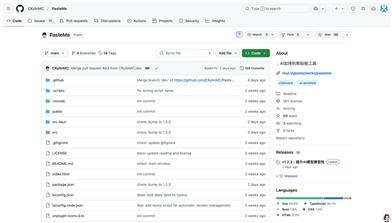

開發者友好,基於Go語言開發,易於擴展和集成。

提供API接口,方便開發者進行二次開發和集成。

使用教程

1. 安裝RLAMA:從官網下載適用於macOS、Linux或Windows的安裝包並安裝。

2. 創建RAG系統:使用命令`rlama rag [model] [rag-name] [folder-path]`,指定模型、系統名稱和文檔文件夾路徑,創建RAG系統。

3. 索引文檔:將需要查詢的文檔放入指定文件夾,RLAMA會自動索引並生成嵌入向量。

4. 啟動交互式會話:通過命令`rlama run [rag-name]`啟動交互式會話,開始查詢文檔知識庫。

5. 管理RAG系統:使用`rlama list`列出所有RAG系統,或使用`rlama delete [rag-name]`刪除不再需要的系統。

精選AI產品推薦

Magic ToDo

Magic ToDo是一個具有特殊功能的標準待辦事項清單。它可以根據你設定的辛辣程度自動生成任務的步驟,辛辣程度越高,生成的步驟越多。你可以使用表情符號來指示任務的辛辣程度。該工具還會自動為頂級任務分配一個由表情符號表示的類別。你可以使用過濾器按鈕來過濾一個或多個類別的任務。此外,每個任務還提供了編輯、刪除、添加子任務和估計等常見任務工具。你可以拖動左側的圖標來重新排序任務。該工具還提供了整個列表的其他操作,包括設備之間的同步、導出選項、撤銷和重做以及批量操作。

效率工具

1.3M

國外精選

Tinywow

TinyWow是一個提供免費在線工具的網站,包括PDF編輯、圖像處理、AI寫作、視頻處理等功能。用戶可以通過TinyWow來解決各種工作和生活中的問題,無需註冊,沒有使用限制。

效率工具

814.5K