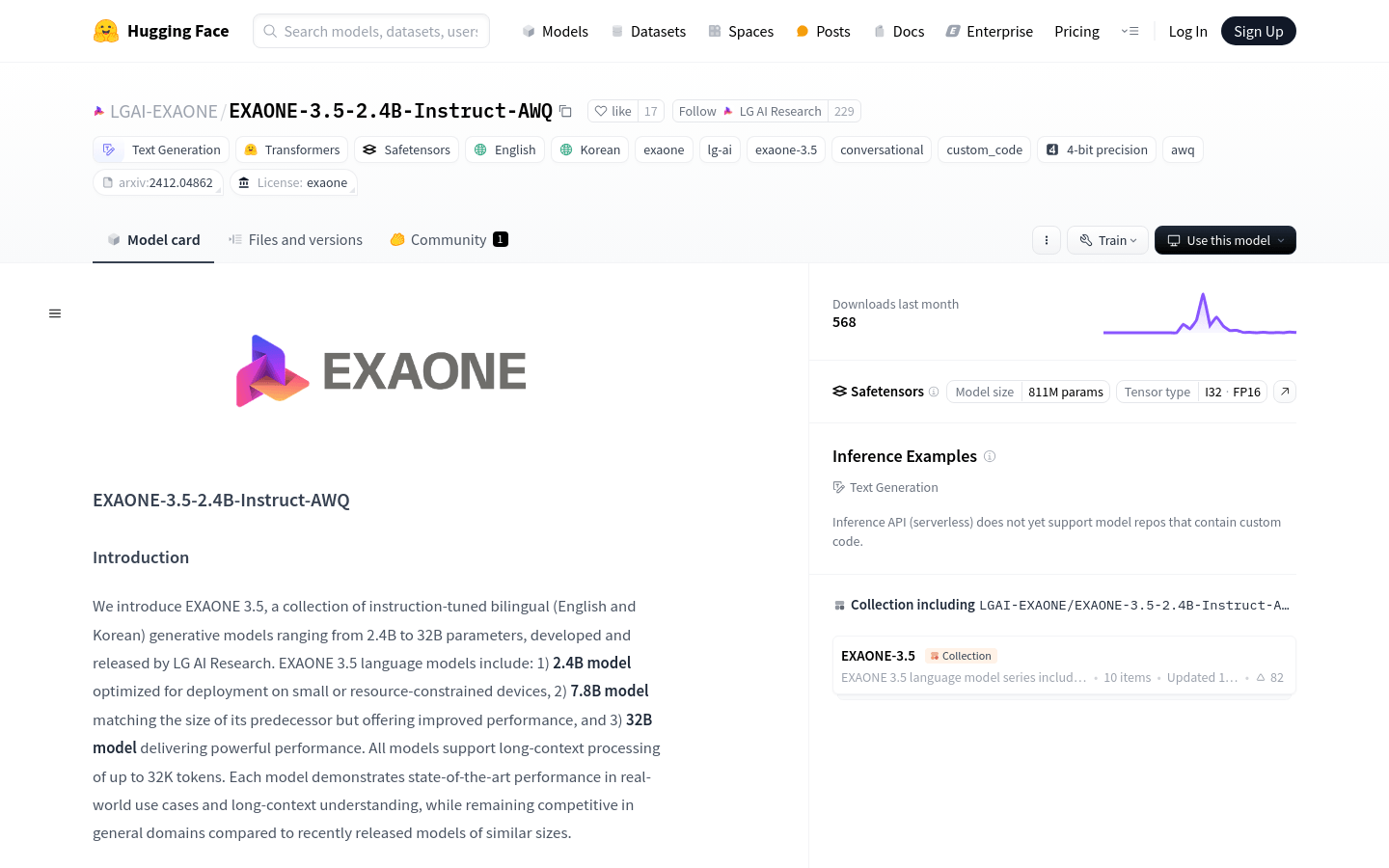

EXAONE 3.5 2.4B Instruct AWQ

簡介 :

EXAONE-3.5-2.4B-Instruct-AWQ是由LG AI Research開發的一系列雙語(英語和韓語)指令調優生成模型,參數範圍從2.4B到32B。這些模型支持長達32K令牌的長上下文處理,並且在真實世界用例和長上下文理解方面展現出最先進的性能,同時在與近期發佈的類似大小模型相比,在通用領域保持競爭力。該模型在部署到小型或資源受限設備上進行了優化,並且採用了AWQ量化技術,實現了4位群組權重量化(W4A16g128)。

需求人群 :

目標受眾為需要在資源受限設備上部署高性能語言模型的開發者和研究人員,以及需要處理長文本數據和多語言支持的NLP應用開發者。EXAONE-3.5-2.4B-Instruct-AWQ因其優化的部署能力和長上下文處理能力,特別適合需要在移動設備或邊緣計算環境中部署語言模型的場景。

使用場景

用於生成英語和韓語的對話回覆

在資源受限的移動設備上提供語言模型服務

作為長文本處理和分析的工具,用於研究和商業智能

產品特色

支持長達32K令牌的長上下文處理能力

優化的2.4B模型,適合在資源受限的設備上部署

7.8B模型提供與前代相同的規模但性能提升

32B模型提供強大的性能

支持英語和韓語兩種語言

AWQ量化技術,實現4位群組權重量化

支持多種部署框架,如TensorRT-LLM、vLLM等

使用教程

1. 安裝必要的庫,如transformers和autoawq

2. 使用AutoModelForCausalLM和AutoTokenizer加載模型和分詞器

3. 準備輸入提示,可以是英文或韓文

4. 使用tokenizer.apply_chat_template方法將消息模板化並轉換為輸入ID

5. 調用model.generate方法生成文本

6. 使用tokenizer.decode方法將生成的ID解碼為文本

7. 根據需要調整模型參數,如max_new_tokens和do_sample,以控制生成文本的長度和多樣性

精選AI產品推薦

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系統。它能夠進行多模態推理,支持文本、圖像、視頻、音頻和代碼之間的無縫交互。Gemini在語言理解、推理、數學、編程等多個領域都超越了之前的狀態,成為迄今為止最強大的AI系統之一。它有三個不同規模的版本,可滿足從邊緣計算到雲計算的各種需求。Gemini可以廣泛應用於創意設計、寫作輔助、問題解答、代碼生成等領域。

AI模型

11.4M

中文精選

Liblibai

LiblibAI是一箇中國領先的AI創作平臺,提供強大的AI創作能力,幫助創作者實現創意。平臺提供海量免費AI創作模型,用戶可以搜索使用模型進行圖像、文字、音頻等創作。平臺還支持用戶訓練自己的AI模型。平臺定位於廣大創作者用戶,致力於創造條件普惠,服務創意產業,讓每個人都享有創作的樂趣。

AI模型

8.0M