Mwp ReFT

簡介 :

ReFT是一個開源的研究項目,旨在通過深度強化學習技術對大型語言模型進行微調,以提高其在特定任務上的表現。該項目提供了詳細的代碼和數據,以便研究人員和開發者能夠復現論文中的結果。ReFT的主要優點包括能夠利用強化學習自動調整模型參數,以及通過微調提高模型在特定任務上的性能。產品背景信息顯示,ReFT基於Codellama和Galactica模型,遵循Apache2.0許可證。

需求人群 :

ReFT的目標受眾是自然語言處理領域的研究人員和開發者,特別是那些對深度學習和強化學習技術在語言模型上的應用感興趣的專業人士。該產品適合他們,因為它提供了一個框架來微調和改進大型語言模型,以適應特定的NLP任務,同時提供了豐富的實驗數據和代碼支持。

使用場景

研究人員使用ReFT在GSM8k數據集上微調Codellama模型,提高了模型的Top-1準確率。

開發者利用ReFT框架在mathqa數據集上對Galactica模型進行微調,提升了模型的Voting@100性能。

研究團隊通過ReFT在svamp數據集上對模型進行ReFT和ReFT-Rerank微調,顯著提高了模型的Rerank@100性能。

產品特色

支持SFT(Supervised Fine-Tuning):通過監督學習對模型進行微調。

支持ReFT(Reinforced Fine-Tuning):使用強化學習技術對模型進行微調。

支持Online-SL和Offline-SL:在線和離線自助學習。

提供多種預訓練模型的checkpoints:方便用戶從不同階段開始微調。

支持Top-1和Voting@100評估:提供模型性能的多種評估方式。

支持Reranking:通過重新排序技術進一步提升模型性能。

詳細的實驗指導和腳本:方便用戶快速開始實驗和微調。

使用教程

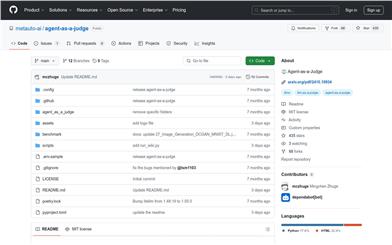

1. 訪問ReFT的GitHub頁面並克隆代碼到本地。

2. 根據README.md文件中的指南安裝所有依賴。

3. 選擇合適的預訓練模型和checkpoints開始微調。

4. 根據具體的實驗需求,運行對應的shell腳本進行模型訓練或評估。

5. 參照exps文件夾中的實驗設置,調整參數以適應不同的數據集和任務。

6. 使用提供的腳本進行模型性能的評估,包括Top-1、Voting@100和Rerank@100。

7. 如果需要,可以進一步微調模型參數或結構,以獲得更好的性能。

精選AI產品推薦

Pseudoeditor

PseudoEditor是一款免費在線偽代碼編輯器。它具有語法高亮、自動完成等功能,幫助您更輕鬆地編寫偽代碼。您還可以使用我們的偽代碼編譯器功能進行測試。無需下載,即可立即使用。

開發與工具

4.5M

Erbuilder

Softbuilder的AI-powered ER diagrams generation是一款基於人工智能技術的數據建模工具,能夠根據自然語言的數據模型描述、用戶故事或需求自動生成ER圖。通過使用OpenAI GPT,它能夠快速生成精美的ER圖,大大提高了數據建模的效率。此外,它還提供數據模型文檔、驗證、探索等功能,可滿足各種數據建模需求。Softbuilder的AI-powered ER diagrams generation適用於各類企業和組織,幫助用戶輕鬆創建和管理數據模型。

開發與工具

4.1M