Mwp ReFT

简介 :

ReFT是一个开源的研究项目,旨在通过深度强化学习技术对大型语言模型进行微调,以提高其在特定任务上的表现。该项目提供了详细的代码和数据,以便研究人员和开发者能够复现论文中的结果。ReFT的主要优点包括能够利用强化学习自动调整模型参数,以及通过微调提高模型在特定任务上的性能。产品背景信息显示,ReFT基于Codellama和Galactica模型,遵循Apache2.0许可证。

需求人群 :

ReFT的目标受众是自然语言处理领域的研究人员和开发者,特别是那些对深度学习和强化学习技术在语言模型上的应用感兴趣的专业人士。该产品适合他们,因为它提供了一个框架来微调和改进大型语言模型,以适应特定的NLP任务,同时提供了丰富的实验数据和代码支持。

使用场景

研究人员使用ReFT在GSM8k数据集上微调Codellama模型,提高了模型的Top-1准确率。

开发者利用ReFT框架在mathqa数据集上对Galactica模型进行微调,提升了模型的Voting@100性能。

研究团队通过ReFT在svamp数据集上对模型进行ReFT和ReFT-Rerank微调,显著提高了模型的Rerank@100性能。

产品特色

支持SFT(Supervised Fine-Tuning):通过监督学习对模型进行微调。

支持ReFT(Reinforced Fine-Tuning):使用强化学习技术对模型进行微调。

支持Online-SL和Offline-SL:在线和离线自助学习。

提供多种预训练模型的checkpoints:方便用户从不同阶段开始微调。

支持Top-1和Voting@100评估:提供模型性能的多种评估方式。

支持Reranking:通过重新排序技术进一步提升模型性能。

详细的实验指导和脚本:方便用户快速开始实验和微调。

使用教程

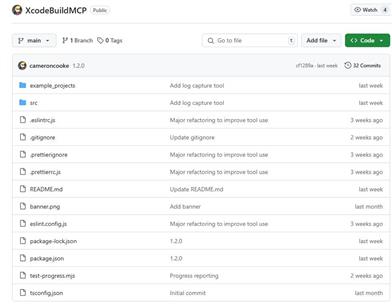

1. 访问ReFT的GitHub页面并克隆代码到本地。

2. 根据README.md文件中的指南安装所有依赖。

3. 选择合适的预训练模型和checkpoints开始微调。

4. 根据具体的实验需求,运行对应的shell脚本进行模型训练或评估。

5. 参照exps文件夹中的实验设置,调整参数以适应不同的数据集和任务。

6. 使用提供的脚本进行模型性能的评估,包括Top-1、Voting@100和Rerank@100。

7. 如果需要,可以进一步微调模型参数或结构,以获得更好的性能。

精选AI产品推荐

Pseudoeditor

PseudoEditor是一款免费在线伪代码编辑器。它具有语法高亮、自动完成等功能,帮助您更轻松地编写伪代码。您还可以使用我们的伪代码编译器功能进行测试。无需下载,即可立即使用。

开发与工具

4.5M

Erbuilder

Softbuilder的AI-powered ER diagrams generation是一款基于人工智能技术的数据建模工具,能够根据自然语言的数据模型描述、用户故事或需求自动生成ER图。通过使用OpenAI GPT,它能够快速生成精美的ER图,大大提高了数据建模的效率。此外,它还提供数据模型文档、验证、探索等功能,可满足各种数据建模需求。Softbuilder的AI-powered ER diagrams generation适用于各类企业和组织,帮助用户轻松创建和管理数据模型。

开发与工具

4.1M