Whisper Diarization

簡介 :

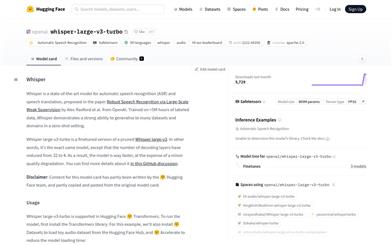

whisper-diarization是一個結合了Whisper自動語音識別(ASR)能力、聲音活動檢測(VAD)和說話人嵌入技術的開源項目。它通過提取音頻中的聲音部分來提高說話人嵌入的準確性,然後使用Whisper生成轉錄文本,並通過WhisperX校正時間戳和對齊,以減少由於時間偏移導致的分割錯誤。接著,使用MarbleNet進行VAD和分割以排除靜音,TitaNet用於提取說話人嵌入以識別每個段落的說話人,最後將結果與WhisperX生成的時間戳關聯,基於時間戳檢測每個單詞的說話人,並使用標點模型重新對齊以補償小的時間偏移。

需求人群 :

該產品適用於需要進行自動語音識別和說話人分割的開發者和研究人員,特別是在處理多說話人音頻文件時,能夠顯著提高轉錄和分割的準確性。

使用場景

研究人員使用whisper-diarization對學術會議的音頻進行自動轉錄和說話人識別。

開發者利用該模型為視頻會議軟件添加自動生成字幕和說話人標籤的功能。

內容創作者使用whisper-diarization來提高播客或視頻內容的後期製作效率。

產品特色

結合Whisper ASR進行高質量的語音轉錄

使用聲音活動檢測(VAD)技術排除靜音

利用說話人嵌入技術進行說話人識別

通過WhisperX校正和對齊時間戳

使用標點模型優化轉錄文本的對齊精度

支持批處理推理,提高處理效率

使用教程

1. 確保系統已安裝FFMPEG和Cython作為先決條件。

2. 克隆或下載whisper-diarization的代碼庫。

3. 根據需要修改`diarize.py`和`helpers.py`中的WhisperX和NeMo參數。

4. 使用命令行工具,輸入相應的參數和音頻文件名來運行模型。

5. 根據系統VRAM容量選擇使用`diarize.py`或`diarize_parallel.py`進行處理。

6. 檢查輸出結果,確保轉錄和說話人分割的準確性。

7. 如遇問題或需要改進,可在GitHub上提交issue或pull request。