Whisper Diarization

简介 :

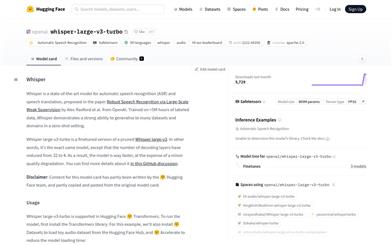

whisper-diarization是一个结合了Whisper自动语音识别(ASR)能力、声音活动检测(VAD)和说话人嵌入技术的开源项目。它通过提取音频中的声音部分来提高说话人嵌入的准确性,然后使用Whisper生成转录文本,并通过WhisperX校正时间戳和对齐,以减少由于时间偏移导致的分割错误。接着,使用MarbleNet进行VAD和分割以排除静音,TitaNet用于提取说话人嵌入以识别每个段落的说话人,最后将结果与WhisperX生成的时间戳关联,基于时间戳检测每个单词的说话人,并使用标点模型重新对齐以补偿小的时间偏移。

需求人群 :

该产品适用于需要进行自动语音识别和说话人分割的开发者和研究人员,特别是在处理多说话人音频文件时,能够显著提高转录和分割的准确性。

使用场景

研究人员使用whisper-diarization对学术会议的音频进行自动转录和说话人识别。

开发者利用该模型为视频会议软件添加自动生成字幕和说话人标签的功能。

内容创作者使用whisper-diarization来提高播客或视频内容的后期制作效率。

产品特色

结合Whisper ASR进行高质量的语音转录

使用声音活动检测(VAD)技术排除静音

利用说话人嵌入技术进行说话人识别

通过WhisperX校正和对齐时间戳

使用标点模型优化转录文本的对齐精度

支持批处理推理,提高处理效率

使用教程

1. 确保系统已安装FFMPEG和Cython作为先决条件。

2. 克隆或下载whisper-diarization的代码库。

3. 根据需要修改`diarize.py`和`helpers.py`中的WhisperX和NeMo参数。

4. 使用命令行工具,输入相应的参数和音频文件名来运行模型。

5. 根据系统VRAM容量选择使用`diarize.py`或`diarize_parallel.py`进行处理。

6. 检查输出结果,确保转录和说话人分割的准确性。

7. 如遇问题或需要改进,可在GitHub上提交issue或pull request。