Frontier Safety Framework

簡介 :

Frontier Safety Framework是Google DeepMind提出的一套協議,用於主動識別未來AI能力可能導致嚴重傷害的情況,並建立機制來檢測和減輕這些風險。該框架專注於模型層面的強大能力,如卓越的代理能力或複雜的網絡能力。它旨在補充我們的對齊研究,即訓練模型按照人類價值觀和社會目標行事,以及Google現有的AI責任和安全實踐。

需求人群 :

目標受眾為AI研究人員、開發者以及對AI安全和倫理有關注的企業和政策制定者。該框架提供了一套評估和減輕AI風險的方法論,幫助他們構建更安全、更符合人類價值觀的AI系統。

使用場景

用於評估AI模型在自動駕駛領域的潛在風險。

在藥物發現中,確保AI模型的推薦不會帶來未預見的副作用。

在經濟生產力提升中,防止AI模型的決策導致不公平或不道德的結果。

產品特色

確定模型可能具有的潛在嚴重傷害的能力。

定期評估前沿模型,檢測它們是否達到關鍵能力水平。

當模型通過預警評估時,應用減輕計劃。

基於四個領域的初步關鍵能力水平:自主性、生物安全、網絡安全和機器學習研究與開發。

為每個關鍵能力水平定製減輕措施的強度。

投資於前沿風險評估的科學,並不斷完善框架。

遵循Google的AI原則,定期審查和更新框架。

使用教程

第一步:確定模型可能具有的潛在嚴重傷害的能力。

第二步:定期對前沿模型進行評估,檢測是否達到關鍵能力水平。

第三步:開發預警評估套件,以在模型接近關鍵能力水平時發出警報。

第四步:當模型通過預警評估時,根據整體利益和風險平衡以及預期部署環境,應用減輕計劃。

第五步:根據關鍵能力水平定製減輕措施的強度。

第六步:投資於前沿風險評估的科學,並不斷完善框架。

第七步:遵循Google的AI原則,定期審查和更新框架。

精選AI產品推薦

行者AI

行者AI提供多種工具,包括AI安全、美術、音樂等,賦能行業,讓創作更簡單。其中包括內容風控、遊戲風控、解決方案、智能反灰、產雲短信、信息認證、人工審核、AI繪圖創作、AI模型訓練、二次元轉化、ICON生成、3D減面、2D轉3D、場景切換等功能。產品定位為提供專業內容與業務安全服務,賦能行業,讓藝術創作更簡單。產品定價根據不同功能點而定。

AI安全

98.8K

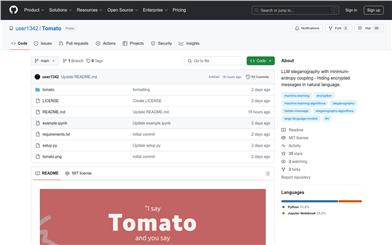

Tomato

Tomato 是一個隱寫工具的概念驗證,它利用由 ssokota 提供的最小熵耦合碼。該工具通過將隱藏信息(密文)的概率分佈與由大型語言模型(LLM)生成的封面文本的概率分佈合併,實現信息隱藏。這種耦合最小化了聯合熵,確保了隱寫文本(封面文本與嵌入信息)保留了自然語言的統計特性,使隱藏信息難以被檢測。解碼過程中,LLM 通過提供上下文感知的解釋來輔助,然後使用 MEC 反向解耦封面文本中的隱藏信息。這種方法確保隱藏信息可以無縫集成到文本中,並且可以安全、準確地在以後檢索,風險最小。

AI安全

58.5K