Frontier Safety Framework

紹介 :

Frontier Safety Frameworkは、Google DeepMindが提案する、将来的なAI能力が深刻な被害をもたらす可能性のある状況を積極的に特定し、それらのリスクを検知?軽減するためのメカニズムを構築するためのプロトコルです。このフレームワークは、優れたエージェント能力や複雑なネットワーク能力など、モデルレベルの強力な能力に焦点を当てています。これは、人間の価値観と社会目標に従ってモデルを訓練するアライメント研究、およびGoogleの既存のAI責任と安全に関する実践を補完することを目的としています。

ターゲットユーザー :

AI研究者、開発者、そしてAIの安全性と倫理に関心を持つ企業や政策立案者を対象としています。このフレームワークは、より安全で、人間の価値観に沿ったAIシステムを構築するための、AIリスクの評価と軽減の方法論を提供します。

使用シナリオ

自動運転分野におけるAIモデルの潜在的なリスクを評価するために使用する。

創薬において、AIモデルの推奨事項が予期せぬ副作用をもたらさないようにする。

経済生産性の向上において、AIモデルの意思決定が不公平または非倫理的な結果をもたらさないようにする。

製品特徴

モデルが持つ可能性のある潜在的な深刻な被害をもたらす能力を特定する。

最先端のモデルを定期的に評価し、重要な能力レベルに達しているかどうかを検出する。

モデルが早期警戒評価をパスした場合、軽減計画を適用する。

自律性、生物安全性、サイバーセキュリティ、機械学習研究開発の4つの分野に基づいた、初期の重要な能力レベルを設定する。

重要な能力レベルごとに軽減策の強度をカスタマイズする。

最先端のリスク評価の科学に投資し、フレームワークを継続的に改善する。

GoogleのAI原則に従い、フレームワークを定期的に見直し、更新する。

使用チュートリアル

ステップ1:モデルが持つ可能性のある潜在的な深刻な被害をもたらす能力を特定する。

ステップ2:最先端のモデルを定期的に評価し、重要な能力レベルに達しているかどうかを検出する。

ステップ3:モデルが重要な能力レベルに近づいた際に警告を発する早期警戒評価キットを開発する。

ステップ4:モデルが早期警戒評価をパスした場合、全体的な利益とリスクのバランス、および予想される展開環境に基づいて、軽減計画を適用する。

ステップ5:重要な能力レベルに応じて軽減策の強度をカスタマイズする。

ステップ6:最先端のリスク評価の科学に投資し、フレームワークを継続的に改善する。

ステップ7:GoogleのAI原則に従い、フレームワークを定期的に見直し、更新する。

おすすめAI製品

行者AI

行者AIは、AIセキュリティ、美術、音楽など多様なツールを提供し、業界の活性化と創作の簡素化を実現します。具体的には、コンテンツリスク管理、ゲームリスク管理、ソリューション提供、高度な不正検知、クラウドSMS、情報認証、人的審査、AIによるイラスト制作、AIモデル学習、二次元変換、アイコン生成、3Dポリゴン削減、2Dから3D変換、シーン切り替えなどの機能を提供しています。専門的なコンテンツと業務セキュリティサービスを提供し、業界を支援し、芸術創作をより簡単にすることを目的としています。価格は機能によって異なります。

AI安全

88.6K

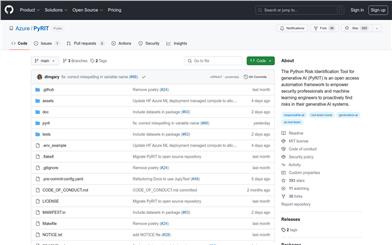

Pyrit

PyRITはAzureが開発したPythonベースのリスク識別ツールであり、セキュリティ専門家や機械学習エンジニアが、生成AIシステムにおけるリスクを積極的に発見することを支援します。このツールはAIレッドチームのタスクを自動化し、運用担当者はより複雑で時間のかかるタスクに集中できるようになり、同時にセキュリティとプライバシーの脅威を特定できます。

AI安全

56.0K