Frontier Safety Framework

简介 :

Frontier Safety Framework是Google DeepMind提出的一套协议,用于主动识别未来AI能力可能导致严重伤害的情况,并建立机制来检测和减轻这些风险。该框架专注于模型层面的强大能力,如卓越的代理能力或复杂的网络能力。它旨在补充我们的对齐研究,即训练模型按照人类价值观和社会目标行事,以及Google现有的AI责任和安全实践。

需求人群 :

目标受众为AI研究人员、开发者以及对AI安全和伦理有关注的企业和政策制定者。该框架提供了一套评估和减轻AI风险的方法论,帮助他们构建更安全、更符合人类价值观的AI系统。

使用场景

用于评估AI模型在自动驾驶领域的潜在风险。

在药物发现中,确保AI模型的推荐不会带来未预见的副作用。

在经济生产力提升中,防止AI模型的决策导致不公平或不道德的结果。

产品特色

确定模型可能具有的潜在严重伤害的能力。

定期评估前沿模型,检测它们是否达到关键能力水平。

当模型通过预警评估时,应用减轻计划。

基于四个领域的初步关键能力水平:自主性、生物安全、网络安全和机器学习研究与开发。

为每个关键能力水平定制减轻措施的强度。

投资于前沿风险评估的科学,并不断完善框架。

遵循Google的AI原则,定期审查和更新框架。

使用教程

第一步:确定模型可能具有的潜在严重伤害的能力。

第二步:定期对前沿模型进行评估,检测是否达到关键能力水平。

第三步:开发预警评估套件,以在模型接近关键能力水平时发出警报。

第四步:当模型通过预警评估时,根据整体利益和风险平衡以及预期部署环境,应用减轻计划。

第五步:根据关键能力水平定制减轻措施的强度。

第六步:投资于前沿风险评估的科学,并不断完善框架。

第七步:遵循Google的AI原则,定期审查和更新框架。

精选AI产品推荐

行者AI

行者AI提供多种工具,包括AI安全、美术、音乐等,赋能行业,让创作更简单。其中包括内容风控、游戏风控、解决方案、智能反灰、产云短信、信息认证、人工审核、AI绘图创作、AI模型训练、二次元转化、ICON生成、3D减面、2D转3D、场景切换等功能。产品定位为提供专业内容与业务安全服务,赋能行业,让艺术创作更简单。产品定价根据不同功能点而定。

AI安全

101.8K

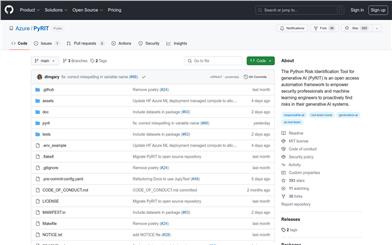

Pyrit

PyRIT是由Azure开发的Python风险识别工具,旨在帮助安全专业人员和机器学习工程师主动发现其生成AI系统中的风险。该工具自动化了AI红队任务,使操作者能够专注于更复杂和耗时的任务,同时能够识别安全和隐私危害。

AI安全

61.0K