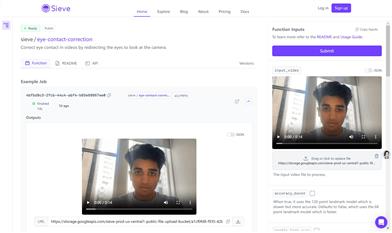

Videoretalking

簡介 :

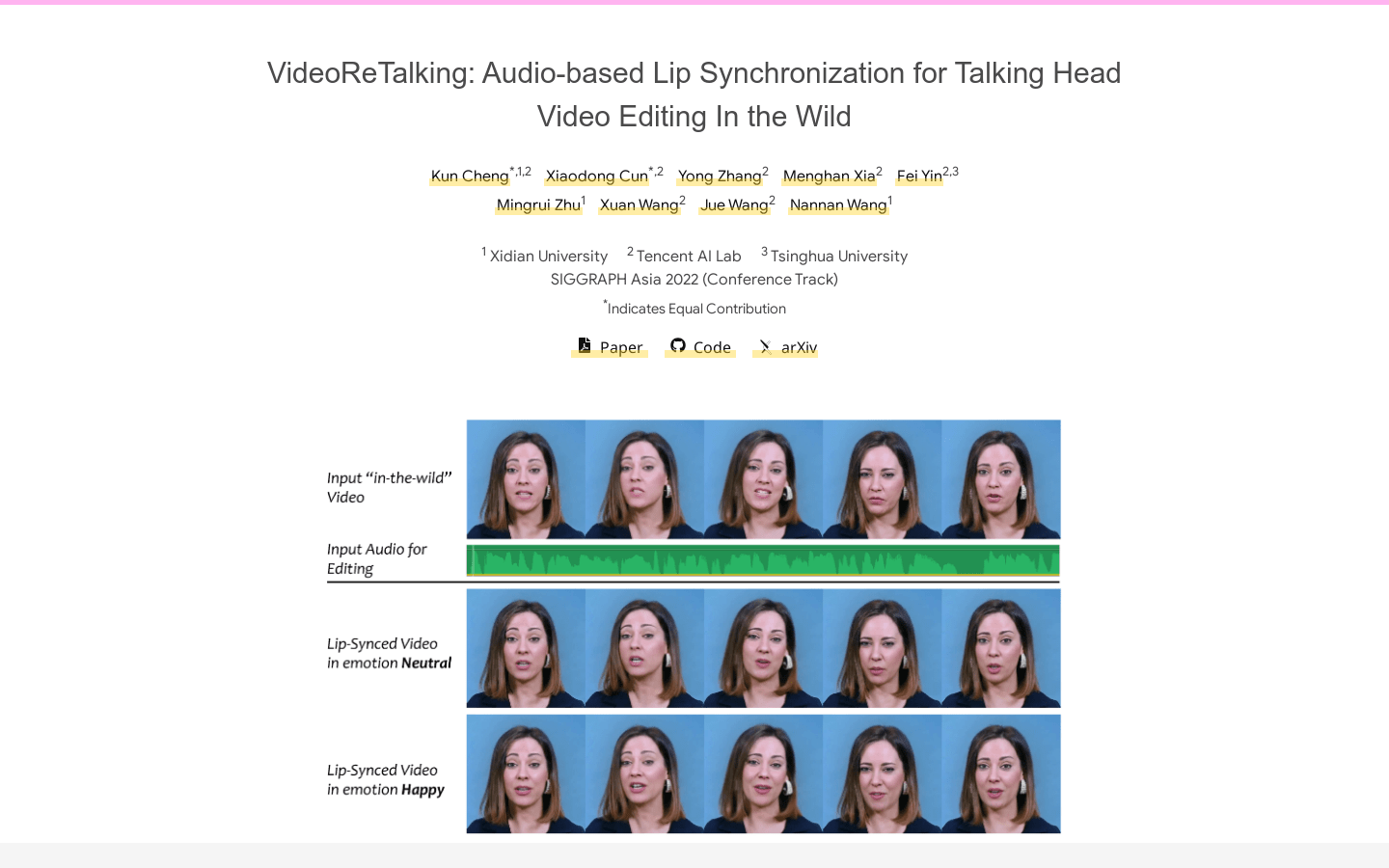

VideoReTalking是一個新的系統,可以根據輸入的音頻編輯真實世界的說話頭部視頻的面部,產生高質量的唇形同步輸出視頻,即使情感不同。該系統將此目標分解為三個連續的任務:(1)使用表情編輯網絡生成帶有規範表情的面部視頻;(2)音頻驅動的唇形同步;(3)用於提高照片逼真度的面部增強。給定一個說話頭部視頻,我們首先使用表情編輯網絡根據相同的表情模板修改每個幀的表情,從而得到具有規範表情的視頻。然後將該視頻與給定的音頻一起輸入到唇形同步網絡中,生成唇形同步視頻。最後,我們通過一個身份感知的面部增強網絡和後處理來提高合成面部的照片逼真度。我們對所有三個步驟使用基於學習的方法,所有模塊都可以在順序管道中處理,無需任何用戶干預。

需求人群 :

適用於需要音頻驅動的唇形同步的視頻編輯場景,可以用於電影、電視劇、廣告等領域。

使用場景

電影製作人使用VideoReTalking來編輯電影中的角色對白,實現高質量唇形同步。

廣告公司使用VideoReTalking來製作廣告,使演員的口型與音頻完美匹配。

電視劇製作人使用VideoReTalking來編輯電視劇中的角色對白,實現高質量唇形同步。

產品特色

音頻驅動的唇形同步

面部增強

表情編輯

高質量唇形同步視頻生成

無需用戶干預

精選AI產品推薦

Sora

Sora是一個基於大規模訓練的文本控制視頻生成擴散模型。它能夠生成長達1分鐘的高清視頻,涵蓋廣泛的視覺數據類型和分辨率。Sora通過在視頻和圖像的壓縮潛在空間中訓練,將其分解為時空位置補丁,實現了可擴展的視頻生成。Sora還展現出一些模擬物理世界和數字世界的能力,如三維一致性和交互,揭示了繼續擴大視頻生成模型規模來發展高能力模擬器的前景。

AI視頻生成

17.2M

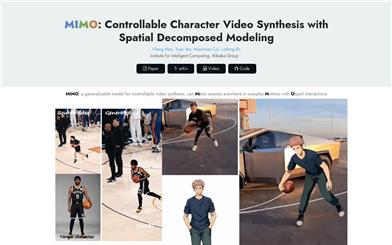

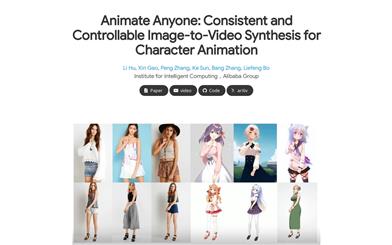

Animate Anyone

Animate Anyone旨在通過驅動信號從靜態圖像生成角色視頻。我們利用擴散模型的力量,提出了一個專為角色動畫量身定製的新框架。為了保持參考圖像中複雜外觀特徵的一致性,我們設計了ReferenceNet來通過空間注意力合併詳細特徵。為了確保可控性和連續性,我們引入了一個高效的姿勢指導器來指導角色的動作,並採用了一種有效的時間建模方法,以確保視頻幀之間的平滑跨幀過渡。通過擴展訓練數據,我們的方法可以為任意角色製作動畫,與其他圖像到視頻方法相比,在角色動畫方面取得了出色的結果。此外,我們在時尚視頻和人類舞蹈合成的基準上評估了我們的方法,取得了最先進的結果。

AI視頻生成

11.8M