Comfyui GGUF

紹介 :

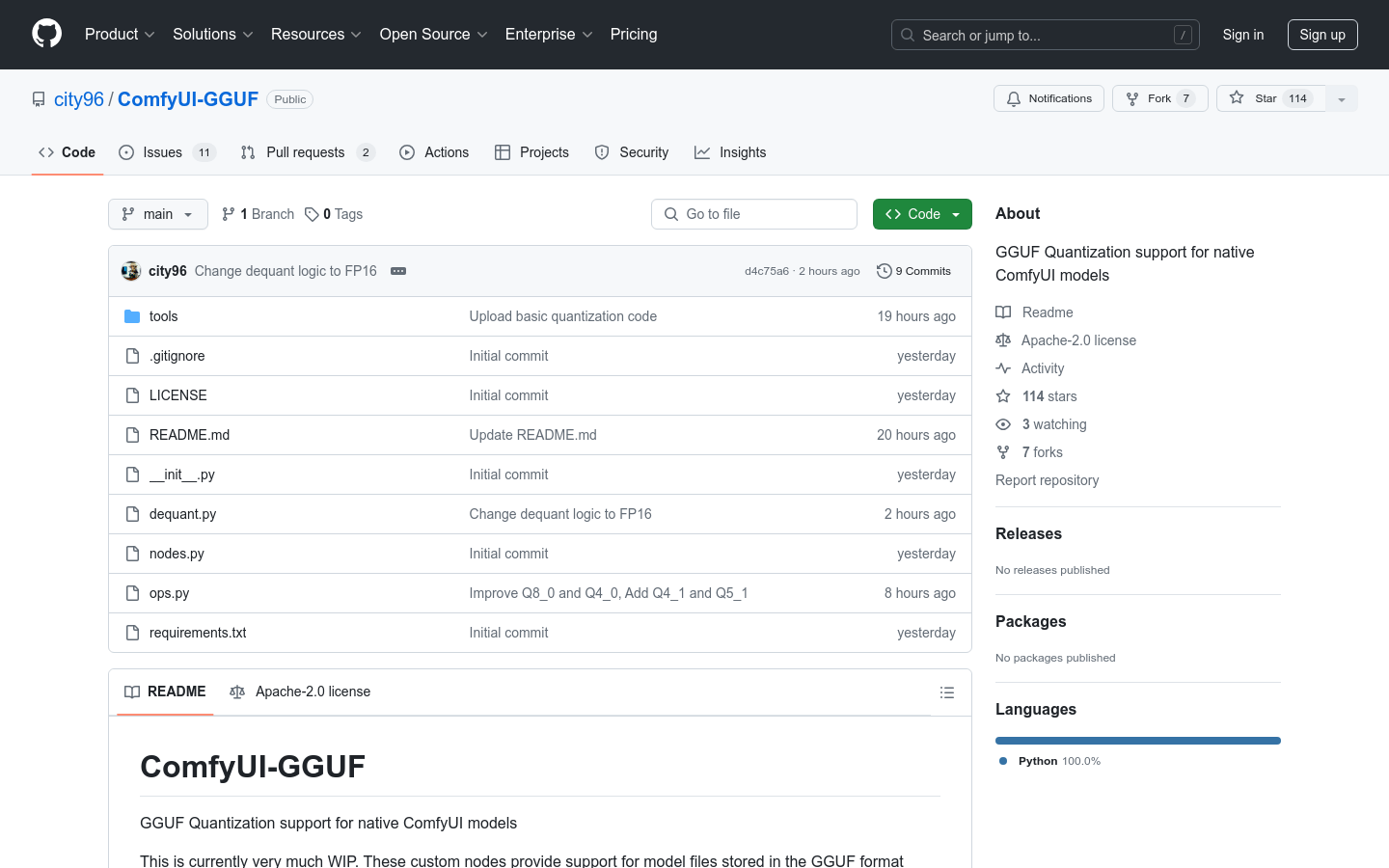

ComfyUI-GGUFは、ComfyUIネイティブモデルにGGUF量子化サポートを提供するプロジェクトです。llama.cppによって普及したGGUF形式でモデルファイルを保存することを可能にします。一般的なUNETモデル(conv2d)は量子化に適していませんが、fluxのようなtransformer/DiTモデルは量子化の影響を受けにくいようです。これにより、低スペックGPUでも、重みあたりビットレートを低くして実行できるようになります。

ターゲットユーザー :

主な対象ユーザーは、ComfyUIを使用してモデルのトレーニングとデプロイを行う開発者と研究者です。リソースが制限された環境でモデルのパフォーマンスを最適化する必要があり、ComfyUI-GGUFは量子化技術によってその目標達成を支援します。

使用シナリオ

開発者はComfyUI-GGUFを使用して、低スペックGPU上でfluxモデルをデプロイし、リソースを最適化しました。

研究者はGGUF量子化技術を利用して、エッジデバイス上でのモデルのパフォーマンスを向上させました。

教育機関は深層学習の授業で、ComfyUI-GGUFを事例として使用し、モデル最適化の技術を教授しました。

製品特徴

GGUF形式のモデルファイルの量子化をサポート

fluxなどのtransformer/DiTモデルに対応

低スペックGPUでの実行を可能にし、リソース使用量を最適化

モデル量子化をサポートするカスタムノードを提供

重みが量子化されるため、LoRA/Controlnetなどのサポートは含まれていません

インストールと使用方法に関するガイドを提供

使用チュートリアル

1. ComfyUIのバージョンがカスタム操作をサポートしていることを確認します。

2. gitを使用してComfyUI-GGUFリポジトリをクローンします。

3. 推論に必要な依存関係をインストールします(pip install --upgrade gguf)。

4. .ggufモデルファイルをComfyUI/models/unetフォルダに配置します。

5. bootlegカテゴリにあるGGUF Unetローダーを使用します。

6. 必要に応じてモデルパラメータと設定を調整し、モデルのトレーニングまたは推論を実行します。

おすすめAI製品

Deepmind Gemini

Geminiは、Google DeepMindが開発した次世代人工知能システムです。テキスト、画像、ビデオ、音声、コード間のシームレスな相互作用をサポートし、マルチモーダル推論を実行できます。言語理解、推論、数学、プログラミングなど、複数の分野において従来のシステムを凌駕し、現在までに開発された最も強力なAIシステムの一つとなっています。エッジコンピューティングからクラウドコンピューティングまで、様々なニーズに対応できる3つの異なる規模のバージョンがあります。Geminiは、クリエイティブデザイン、ライティングアシスタント、質問応答、コード生成など、幅広い分野で活用できます。

AIモデル

11.4M

中国語精選

剪映dreamina

剪映DreaminaはTikTok(抖音)が提供するAIGCツールです。テキストを入力すると、AIが自動的にクリエイティブな画像を生成します。画像サイズやアスペクト比、テンプレートの種類も調整可能です。将来的には、TikTokの画像投稿やショート動画のコンテンツ制作にも活用され、TikTokのAIによるコンテンツ制作の充実を図ります。

AI画像生成

9.0M