中国語精選

Qwen2.5 VL

Qwen2.5-VLは、Qwenチームが発表した最新の主力ビジョン言語モデルであり、ビジョン言語モデル分野における重要な進歩です。一般的な物体の認識だけでなく、画像内の文字、グラフ、アイコンなどの複雑な内容の分析も可能で、長尺動画の理解やイベントの特定にも対応しています。複数のベンチマークテストで優れた性能を示しており、特に文書理解やビジュアルエージェントタスクにおいて顕著な優位性を持ち、強力なビジュアル理解と推論能力を備えています。主な利点としては、効率的なマルチモーダル理解、強力な長尺動画処理能力、柔軟なツール呼び出し能力があり、様々なアプリケーションシナリオに適しています。

AIモデル

88.9K

Tarsier

Tarsierは、バイトダンスの研究チームが開発した、一連の大規模ビデオ言語モデルです。高品質なビデオ説明の生成と、強力な動画理解能力を備えています。二段階のトレーニング戦略(マルチタスク事前学習と多粒度指示微調整)により、ビデオ説明の精度と詳細度が大幅に向上しました。主な利点としては、高精度なビデオ説明能力、複雑なビデオコンテンツの理解能力、そして複数の動画理解ベンチマークテストでSOTA(State-of-the-Art)の結果を達成している点が挙げられます。Tarsierは、既存のビデオ言語モデルにおける詳細と正確性の不足を改善することを目的として開発されました。大規模で高品質なデータによるトレーニングと革新的なトレーニング手法により、ビデオ説明分野において新たな高みに達しています。現時点では価格設定は公開されていませんが、主に学術研究と商業用途を対象としており、高品質な動画コンテンツの理解と生成が必要な場面に適しています。

映像制作

70.4K

Videollama3

VideoLLaMA3は、DAMO-NLP-SGチームが開発した最先端のマルチモーダル基盤モデルであり、画像と動画の理解に特化しています。Qwen2.5アーキテクチャをベースに、SigLipなどの高度なビジュアルエンコーダーと強力な自然言語生成能力を組み合わせることで、複雑な視覚言語タスクを処理できます。主な利点として、効率的な時空間モデリング能力、強力なマルチモーダル融合能力、大規模データに対する最適化されたトレーニングなどが挙げられます。動画の深い理解が必要なアプリケーションシナリオ、例えば動画コンテンツ分析やビジュアルクエスチョン?アンサーリングなどに適しており、幅広い研究および商業的な応用可能性を秘めています。

映像制作

48.0K

Omagent.com

OmAgentは、スマートデバイスなど向けのマルチモーダルネイティブエージェントフレームワークです。分割統治アルゴリズムを用いて複雑なタスクを効率的に解決し、長尺動画を前処理して人間と同等の精度で質疑応答を行うことができます。また、ユーザーのリクエストと任意の天候条件に基づいて、パーソナライズされた服装提案なども提供します。現時点では公式ウェブサイトに価格が明示されていませんが、機能から見て、効率的なタスク処理とスマートなインタラクションを必要とする開発者や企業などのユーザー層を主なターゲットにしていると考えられます。

スマートデバイス

47.2K

Videoprompt.org

videoprompt.orgは、AI動画生成プロンプトに特化したウェブサイトです。動画コンテンツの生成、編集、理解のための様々な命令セットを提供しています。厳選された高品質のプロンプト集、コミュニティ主導のアプローチ、実用的な側面への注力により、ユーザーはAIモデルによる動画処理の可能性を最大限に引き出し、動画制作ワークフローの効率化と一貫した高品質な成果を実現できます。

映像制作

54.6K

Apollo LMMs

Apolloは、動画理解に特化した先進的な大規模マルチモーダルモデル群です。動画-LMMsの設計空間を体系的に探求することで、性能を左右する主要因を明らかにし、モデル性能の最適化に関する実践的な知見を提供します。Apolloは「スケーリングの一貫性(Scaling Consistency)」を発見することにより、小規模モデルとデータセットにおける設計上の意思決定を、より大規模なモデルへ確実に転移させることを可能にし、計算コストの大幅な削減を実現しました。Apolloの主な利点としては、効率的な設計上の意思決定、最適化されたトレーニング計画とデータ混合、そして効率的な評価のための新たなベンチマークであるApolloBenchがあります。

映像制作

47.7K

Qwen2 VL 7B

Qwen2-VL-7BはQwen-VLモデルの最新版であり、約1年間の革新的な成果を表しています。このモデルは、MathVista、DocVQA、RealWorldQA、MTVQAなど、ビジョン理解ベンチマークテストにおいて最先端の性能を達成しました。20分を超える動画を理解し、動画に基づいた質疑応答、対話、コンテンツ作成などを高品質でサポートします。さらに、Qwen2-VLは多言語をサポートしており、英語と中国語に加え、多くのヨーロッパ言語、日本語、韓国語、アラビア語、ベトナム語などを含みます。モデルアーキテクチャの更新には、Naive Dynamic ResolutionとMultimodal Rotary Position Embedding (M-ROPE)が含まれ、マルチモーダル処理能力が強化されています。

AIモデル

49.4K

Ppllava

PPLLaVAは、高効率な動画大規模言語モデルです。細粒度ビジュアルプロンプトアライメント、ユーザー指示による畳み込みスタイルプーリングを用いたビジュアルトークンの圧縮、CLIPコンテキスト拡張を組み合わせることで実現しています。VideoMME、MVBench、VideoChatGPT Bench、VideoQA Benchなどのデータセットにおいて最先端の結果を達成し、ビジュアルトークンを1024個のみ使用することで、スループットを8倍に向上させています。

映像制作

47.7K

Longvu

LongVUは、革新的な長尺動画言語理解モデルです。時空間適応圧縮機構を通じて動画の標識数を削減しながら、長尺動画における視覚的なディテールを保持します。この技術の重要性は、大量の動画フレームを処理でき、限られたコンテキスト長の範囲内で視覚情報の損失を最小限に抑え、長尺動画の内容理解と分析能力を大幅に向上させる点にあります。LongVUは、複数の動画理解ベンチマークテストにおいて既存の手法を上回り、特に1時間の長さの動画を理解するタスクにおいて顕著な成果を上げています。さらに、LongVUは、最先端の動画理解性能を維持しながら、より小型のモデルサイズにも効率的に拡張できます。

モデルトレーニングとデプロイメント

51.1K

Video CCAM

Video-CCAMは、テンセントQQマルチメディア研究チームが開発した、柔軟性に優れた一連の動画多言語モデル(Video-MLLM)です。動画とテキストの理解能力の向上を目指し、特に短編動画と長編動画の分析に適しています。因果クロスアテンションマスク(Causal Cross-Attention Masks)を用いてこの目標を達成しています。Video-CCAMは複数のベンチマークテストで優れた性能を示しており、特にMVBench、VideoVista、MLVUにおいて顕著です。モデルのソースコードは、展開プロセスを簡素化するために書き直されています。

AI動画生成

50.5K

Goldfish

Goldfishは、任意の長さの動画を理解するために設計された手法です。効率的な検索メカニズムにより、まず指示に関連する上位k個の動画片段を収集し、必要な応答を提供します。この設計により、Goldfishは任意の長さの動画シーケンスを効果的に処理でき、映画やテレビドラマなどのシナリオに適しています。検索プロセスを促進するために、動画片段の詳細な説明を生成するMiniGPT4-Videoを開発しました。Goldfishは、長尺動画のベンチマークテストで41.78%の精度を達成し、従来の方法を14.94%上回りました。さらに、MiniGPT4-Videoは短尺動画の理解においても優れた性能を発揮し、MSVD、MSRVTT、TGIF、TVQAの短尺動画ベンチマークテストにおいて、それぞれ既存の最先端手法を3.23%、2.03%、16.5%、23.59%上回りました。これらの結果は、Goldfishモデルが長尺動画と短尺動画の理解の両方において顕著な改善を示していることを示しています。

AI動画検索

56.0K

Sharegpt4video

ShareGPT4Videoシリーズは、緻密で正確な字幕を通じて、大規模なビデオ言語モデル(LVLMs)による動画の理解と、テキストから動画へのモデル(T2VMs)による動画生成を促進することを目的としています。このシリーズには、1)4万件のGPT-4V注釈付きの緻密な動画字幕であるShareGPT4Video(綿密なデータフィルタリングとアノテーション戦略によって開発)、2)480万件の高品質な美学動画に注釈を付けた、効率的で強力な任意の動画字幕モデルであるShareCaptioner-Video、3)3つの高度な動画ベンチマークテストで最高性能を達成した、シンプルながらも優れたLVLMであるShareGPT4Video-8Bが含まれています。

AI動画生成

72.9K

高品質新製品

Lvbench

LVBenchは、数時間の長尺動画の理解能力において、マルチモーダル大規模言語モデルの能力向上を目的とした、長尺動画理解のための専用ベンチマークです。これは、長期的な意思決定、詳細な映画評論や議論、現場のスポーツ実況解説など、現実世界の様々な応用において極めて重要です。

AIモデル

50.8K

Videollama 2

VideoLLaMA 2は、動画理解タスク向けに最適化された大規模言語モデルです。高度な時空間モデリングと音声理解能力により、動画コンテンツの解析と理解を向上させます。このモデルは、複数選択肢動画質問応答や動画字幕生成などのタスクにおいて卓越した性能を示します。

AI動画解析

78.7K

VILA

VILAは、大規模なインターリーブされた画像テキストデータで事前トレーニングされた、事前学習済みのビジョン言語モデル(VLM)です。これにより、動画の理解と複数の画像の理解が可能になります。VILAは、AWQ 4bit量子化とTinyChatフレームワークにより、エッジデバイスへの展開が可能です。主な利点としては、1) 性能向上に不可欠なインターリーブされた画像テキストデータ、2) コンテキスト学習を促進する、大規模言語モデル(LLM)をインターリーブされた画像テキスト事前トレーニング中に固定しないこと、3) VLMと純粋なテキストの性能を大幅に向上させるテキスト指示データのリミックス、4) 動画フレーム数の拡張を可能にするトークン圧縮、などが挙げられます。VILAは、動画推論、コンテキスト学習、ビジュアル思考連鎖、より優れた世界知識など、魅力的な能力を示します。

AIモデル

84.5K

Video Mamba Suite

Video Mamba Suiteは、動画理解のための新しい状態空間モデルスイートであり、動画モデリングにおけるMambaの可能性を探求および評価することを目的としています。このスイートには14個のモデル/モジュールが含まれており、12個の動画理解タスクを網羅し、動画および動画?言語タスクにおける高い効率性と優れた性能を実証しています。

AI動画生成

67.1K

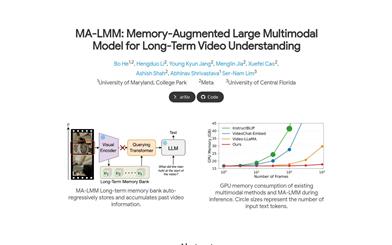

MA LMM

MA-LMMは、大規模言語モデルを基盤とした巨大規模マルチモーダルモデルであり、主に長期動画理解を目的として設計されています。オンラインで動画を処理し、過去の動画情報をメモリに保存することで、言語モデルのコンテキスト長制限やGPUメモリ制限を超えることなく、過去の動画内容を参照して長期的な分析を行うことができます。MA-LMMは既存のマルチモーダル言語モデルにシームレスに統合でき、長期動画理解、動画質疑応答、動画字幕生成などのタスクにおいて最先端の性能を達成しています。

AI動画生成

77.3K

Minigpt4 Video

MiniGPT4-Videoは、時系列の視覚データとテキストデータを処理できる、動画理解のために設計されたマルチモーダル大規模言語モデルです。動画のタイトルや宣伝文句を作成でき、動画に関する質問応答にも対応しています。MiniGPT-v2をベースに、視覚主幹EVA-CLIPを組み合わせ、大規模な動画テキスト事前学習と動画質疑応答ファインチューニングを含む複数段階のトレーニングを経て開発されました。MSVD、MSRVTT、TGIF、TVQAベンチマークにおいて顕著な性能向上を実現しています。価格は未定です。

AI動画生成

98.0K

Videoprism

VideoPrismは汎用的な動画エンコーディングモデルであり、分類、物体検出、検索、字幕生成、質疑応答など、様々な動画理解タスクにおいて最先端の性能を実現します。その革新的な点は、3600万本の高品質な動画?テキストペアと、5億8200万本のノイズを含むテキスト付き動画クリップを含む、非常に大規模かつ多様なデータセットを用いて事前学習されている点にあります。事前学習には二段階戦略を採用しており、まずコントラスト学習を用いて動画とテキストをマッチングさせ、次にマスクされた動画ブロックを予測することで、異なる教師信号を最大限に活用しています。単一のVideoPrismモデルを直接下流タスクに適用でき、30個の動画理解ベンチマークにおいて最先端の性能を達成しています。

AI動画生成

87.2K

おすすめAI製品

海外精選

Jules AI

Jules は、自動で煩雑なコーディングタスクを処理し、あなたに核心的なコーディングに時間をかけることを可能にする異步コーディングエージェントです。その主な強みは GitHub との統合で、Pull Request(PR) を自動化し、テストを実行し、クラウド仮想マシン上でコードを検証することで、開発効率を大幅に向上させています。Jules はさまざまな開発者に適しており、特に忙しいチームには効果的にプロジェクトとコードの品質を管理する支援を行います。

開発プログラミング

44.7K

Nocode

NoCode はプログラミング経験を必要としないプラットフォームで、ユーザーが自然言語でアイデアを表現し、迅速にアプリケーションを生成することが可能です。これにより、開発の障壁を下げ、より多くの人が自身のアイデアを実現できるようになります。このプラットフォームはリアルタイムプレビュー機能とワンクリックデプロイ機能を提供しており、技術的な知識がないユーザーにも非常に使いやすい設計となっています。

開発プラットフォーム

42.8K

Listenhub

ListenHub は軽量級の AI ポッドキャストジェネレーターであり、中国語と英語に対応しています。最先端の AI 技術を使用し、ユーザーが興味を持つポッドキャストコンテンツを迅速に生成できます。その主な利点には、自然な会話と超高品質な音声効果が含まれており、いつでもどこでも高品質な聴覚体験を楽しむことができます。ListenHub はコンテンツ生成速度を改善するだけでなく、モバイルデバイスにも対応しており、さまざまな場面で使いやすいです。情報取得の高効率なツールとして位置づけられており、幅広いリスナーのニーズに応えています。

AI

41.4K

中国語精選

腾讯混元画像 2.0

腾讯混元画像 2.0 は腾讯が最新に発表したAI画像生成モデルで、生成スピードと画質が大幅に向上しました。超高圧縮倍率のエンコード?デコーダーと新しい拡散アーキテクチャを採用しており、画像生成速度はミリ秒級まで到達し、従来の時間のかかる生成を回避することが可能です。また、強化学習アルゴリズムと人間の美的知識の統合により、画像のリアリズムと詳細表現力を向上させ、デザイナー、クリエーターなどの専門ユーザーに適しています。

画像生成

41.7K

Openmemory MCP

OpenMemoryはオープンソースの個人向けメモリレイヤーで、大規模言語モデル(LLM)に私密でポータブルなメモリ管理を提供します。ユーザーはデータに対する完全な制御権を持ち、AIアプリケーションを作成する際も安全性を保つことができます。このプロジェクトはDocker、Python、Node.jsをサポートしており、開発者が個別化されたAI体験を行うのに適しています。また、個人情報を漏らすことなくAIを利用したいユーザーにお勧めします。

オープンソース

43.1K

Fastvlm

FastVLM は、視覚言語モデル向けに設計された効果的な視覚符号化モデルです。イノベーティブな FastViTHD ミックスドビジュアル符号化エンジンを使用することで、高解像度画像の符号化時間と出力されるトークンの数を削減し、モデルのスループットと精度を向上させました。FastVLM の主な位置付けは、開発者が強力な視覚言語処理機能を得られるように支援し、特に迅速なレスポンスが必要なモバイルデバイス上で優れたパフォーマンスを発揮します。

画像処理

40.6K

海外精選

ピカ

ピカは、ユーザーが自身の創造的なアイデアをアップロードすると、AIがそれに基づいた動画を自動生成する動画制作プラットフォームです。主な機能は、多様なアイデアからの動画生成、プロフェッショナルな動画効果、シンプルで使いやすい操作性です。無料トライアル方式を採用しており、クリエイターや動画愛好家をターゲットとしています。

映像制作

17.6M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M