VILA

紹介 :

VILAは、大規模なインターリーブされた画像テキストデータで事前トレーニングされた、事前学習済みのビジョン言語モデル(VLM)です。これにより、動画の理解と複数の画像の理解が可能になります。VILAは、AWQ 4bit量子化とTinyChatフレームワークにより、エッジデバイスへの展開が可能です。主な利点としては、1) 性能向上に不可欠なインターリーブされた画像テキストデータ、2) コンテキスト学習を促進する、大規模言語モデル(LLM)をインターリーブされた画像テキスト事前トレーニング中に固定しないこと、3) VLMと純粋なテキストの性能を大幅に向上させるテキスト指示データのリミックス、4) 動画フレーム数の拡張を可能にするトークン圧縮、などが挙げられます。VILAは、動画推論、コンテキスト学習、ビジュアル思考連鎖、より優れた世界知識など、魅力的な能力を示します。

ターゲットユーザー :

["研究者と開発者:VILAを使用して、動画理解と複数の画像の理解に関する研究やアプリケーション開発を行うことができます。","企業ユーザー:セキュリティ監視、コンテンツレコメンドなど、動画コンテンツの分析と理解が必要なビジネスシーンで、VILAは強力な技術サポートを提供します。","教育分野:VILAは、ビジョン言語モデルの動作原理と適用事例を学生がより深く理解するための教材として利用できます。"]

使用シナリオ

VILAを使用して動画コンテンツの自動アノテーションと分析を行う。

教育プラットフォームにVILAを統合し、画像と動画のインテリジェントな解釈機能を提供する。

VILAをスマートセキュリティシステムに適用し、リアルタイムの動画監視と異常行動検知を行う。

製品特徴

動画理解機能:VILA-1.5バージョンでは動画理解機能を提供します。

多様なモデルサイズ:3B/8B/13B/40Bの4種類のモデルサイズを提供します。

効率的な展開:AWQ量子化された4bit VILA-1.5モデルは、様々なNVIDIA GPUで効率的に展開できます。

コンテキスト学習:インターリーブされた画像テキスト事前トレーニング中にLLMを固定しないことで、コンテキスト学習を促進します。

トークン圧縮:トークン圧縮技術により動画フレーム数を拡張し、モデルの性能を向上させます。

オープンソースコード:トレーニングコード、評価コード、データセット、モデルチェックポイントを含むすべてのものがオープンソースです。

性能向上:テキスト指示データのリミックスなどの特定の技術的手法により、VLMと純粋なテキストの性能を大幅に向上させます。

使用チュートリアル

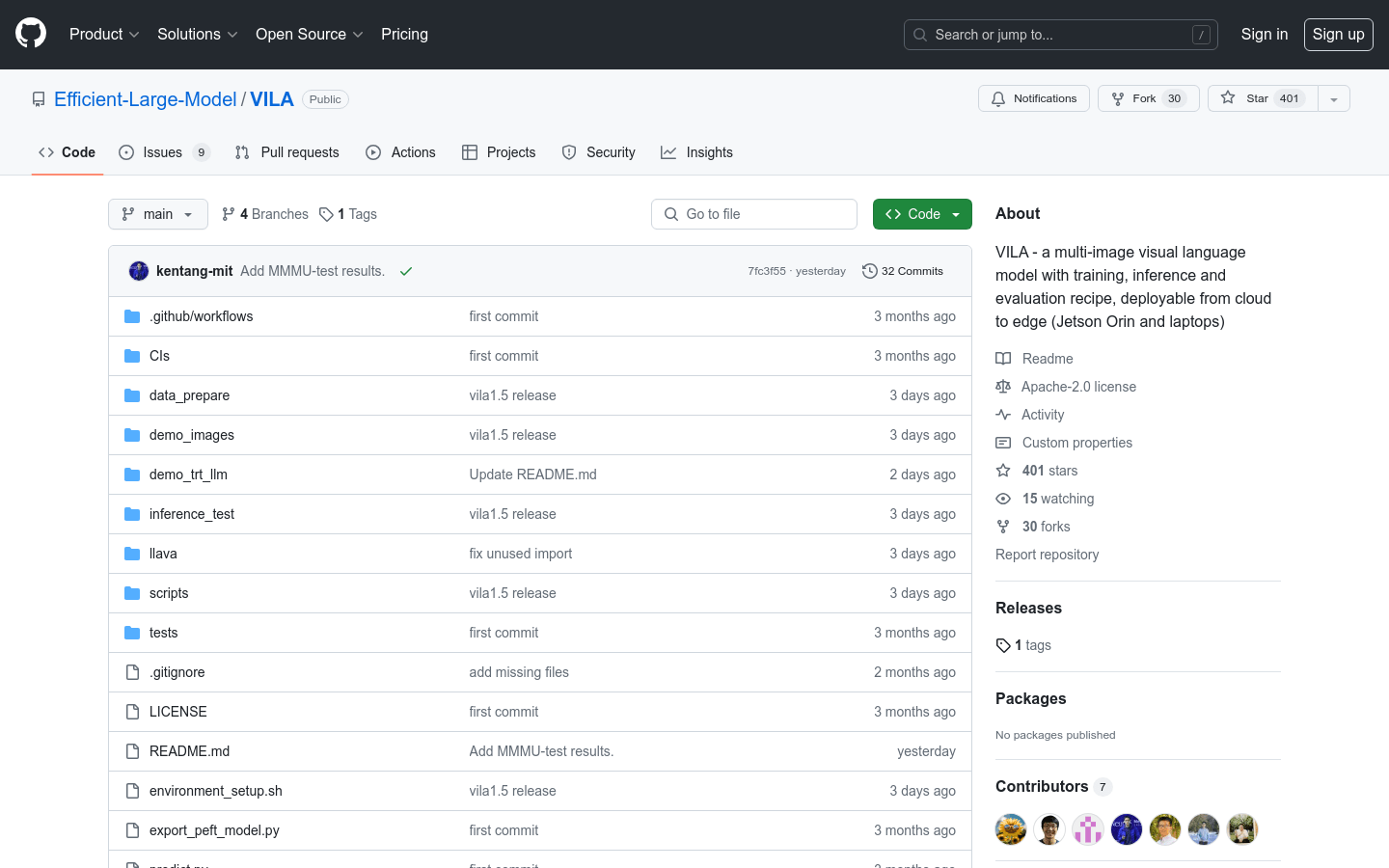

手順1:VILAのGitHubリポジトリページにアクセスしてプロジェクトコードを取得します。

手順2:リポジトリのガイドに従って、必要な環境と依存関係をインストールします。

手順3:VILAの事前学習済みモデルをダウンロードして設定します。

手順4:提供されているトレーニングスクリプトを使用して、VILAを特定のアプリケーションシナリオに合わせてさらにトレーニングまたはファインチューニングします。

手順5:推論スクリプトを使用して、新しい画像または動画データの処理を行い、モデルの出力を取得します。

手順6:アプリケーションのニーズに合わせて、モデルの出力を最終的な製品またはサービスに統合します。

おすすめAI製品

Deepmind Gemini

Geminiは、Google DeepMindが開発した次世代人工知能システムです。テキスト、画像、ビデオ、音声、コード間のシームレスな相互作用をサポートし、マルチモーダル推論を実行できます。言語理解、推論、数学、プログラミングなど、複数の分野において従来のシステムを凌駕し、現在までに開発された最も強力なAIシステムの一つとなっています。エッジコンピューティングからクラウドコンピューティングまで、様々なニーズに対応できる3つの異なる規模のバージョンがあります。Geminiは、クリエイティブデザイン、ライティングアシスタント、質問応答、コード生成など、幅広い分野で活用できます。

AIモデル

11.4M

中国語精選

剪映dreamina

剪映DreaminaはTikTok(抖音)が提供するAIGCツールです。テキストを入力すると、AIが自動的にクリエイティブな画像を生成します。画像サイズやアスペクト比、テンプレートの種類も調整可能です。将来的には、TikTokの画像投稿やショート動画のコンテンツ制作にも活用され、TikTokのAIによるコンテンツ制作の充実を図ります。

AI画像生成

9.0M