海外精選

Aya Vision

Aya Visionは、Cohere For AIチームが開発した、多言語?多モーダルタスクに特化した先進的なビジュアルモデルであり、23言語をサポートしています。合成アノテーション、多言語データ拡張、多モーダルモデル融合などの革新的なアルゴリズムにより、視覚およびテキストタスクのパフォーマンスを大幅に向上させています。主な利点としては、効率性(計算リソースが限られた状況でも優れたパフォーマンスを発揮する)と幅広い多言語サポートがあります。Aya Visionのリリースは、多言語?多モーダル研究の最先端の発展を促進し、世界中の研究コミュニティに技術サポートを提供することを目的としています。

AIモデル

47.5K

Vidorag

ViDoRAGは、アリババ自然言語処理チームが開発した、視覚的に豊富なドキュメントの複雑な推論タスクを処理するために設計された、新しいタイプの多モーダル検索強化生成フレームワークです。このフレームワークは、動的イテレーティブ推論エージェントとガウス混合モデル(GMM)駆動の多モーダル検索戦略を通じて、生成モデルの堅牢性と精度を大幅に向上させます。ViDoRAGの主な利点には、視覚情報とテキスト情報の効率的な処理、多段階推論のサポート、高い拡張性などがあります。このフレームワークは、大規模なドキュメントから情報を検索および生成する必要があるシナリオ(インテリジェントな質問応答、ドキュメント分析、コンテンツ作成など)に適しています。オープンソース特性と柔軟なモジュール式設計により、多モーダル生成分野における研究者や開発者にとって重要なツールとなります。

AIモデル

42.2K

Migician

Migicianは、清華大学自然言語処理研究室が開発した多モーダル大規模言語モデルであり、複数の画像の配置タスクに特化しています。革新的なトレーニングフレームワークと大規模データセットMGrounding-630kを導入することで、複数の画像シーンにおける精密配置能力を大幅に向上させました。既存の多モーダル大規模言語モデルを凌駕するだけでなく、70Bというより大規模なモデルをも性能で上回っています。Migicianの主な利点は、複雑な複数の画像タスクを処理し、自由形式の配置指示を提供できることであり、複数の画像の理解分野において重要な応用可能性を秘めています。このモデルは現在、Hugging Faceでオープンソースとして公開されており、研究者や開発者が利用できます。

AIモデル

44.2K

Magma

Magmaは、Microsoft Researchチームが開発した多モーダル基礎モデルです。視覚、言語、動作を組み合わせることで、複雑なタスクの計画と実行を目指しています。大規模な視覚言語データによって事前学習されており、言語理解、空間認識、動作計画能力を備え、UIナビゲーションやロボット操作などのタスクで優れた性能を発揮します。このモデルは、多モーダルAIエージェントタスクに強力な基礎フレームワークを提供し、幅広い応用が期待されます。

AI

45.5K

Creatilayout

CreatiLayoutは、双子型多モーダル拡散トランスフォーマー(Siamese Multimodal Diffusion Transformer)を用いて、高品質かつ細粒度で制御可能な画像生成を実現する革新的なレイアウトから画像生成技術です。この技術は、色、テクスチャ、形状、数量、テキストなど、複雑な属性を正確にレンダリングでき、正確なレイアウトと画像生成が必要なアプリケーションシナリオに適しています。主な利点としては、効率的なレイアウト誘導統合、強力な画像生成能力、大規模データセットのサポートなどが挙げられます。CreatiLayoutは、復旦大学とByteDance社が共同で開発し、クリエイティブデザイン分野における画像生成技術の推進を目指しています。

AI設計ツール

56.9K

Diffsensei

DiffSenseiは、多モーダル大規模言語モデル(LLM)と拡散モデルを組み合わせた、カスタマイズ可能な漫画生成モデルです。ユーザーが提供するテキストプロンプトとキャラクター画像に基づき、制御可能な白黒漫画パネルを生成し、柔軟なキャラクター適応性を備えています。この技術の重要性は、自然言語処理と画像生成を組み合わせることで、漫画制作とパーソナライズされたコンテンツ生成に新たな可能性を提供することにあります。DiffSenseiモデルは、高品質な画像生成、多様な応用シナリオ、そしてリソースの効率的な利用で注目されています。現在、GitHubで公開されており、無料でダウンロードして使用できますが、使用には一定の計算リソースが必要となる可能性があります。

AI設計ツール

90.3K

Ditctrl

DiTCtrlは、多モーダル拡散トランスフォーマー(MM-DiT)アーキテクチャに基づく動画生成モデルです。追加の訓練なしで、複数の連続したプロンプトを持つ一貫性のあるシーン動画を生成することに重点を置いています。MM-DiTの注意機構を分析することにより、異なるプロンプト間での正確な意味的制御と注意の共有を実現し、滑らかな遷移と一貫したオブジェクトの動きを持つ動画を生成します。DiTCtrlの主な利点としては、訓練不要、複数プロンプト動画生成タスクに対応可能、そして映画のような遷移効果を示せることが挙げられます。さらに、DiTCtrlは、複数プロンプト動画生成のパフォーマンスを評価するために、新しいベンチマークMPVBenchを提供します。

映像制作

48.6K

Gemini多モーダルライブ+webrtc

Gemini多モーダルライブ+WebRTCは、シンプルな音声AIアプリケーションの構築方法を示すサンプルプロジェクトです。Gemini多モーダルライブAPIとWebRTC技術を使用しています。主な利点として、低遅延、高い堅牢性、コア機能の実装容易性、そして様々なプラットフォームと言語のSDKとの互換性があります。これはオープンソースプロジェクトであり、WebRTC技術によってリアルタイムメディア接続のパフォーマンス向上と開発プロセスの簡素化を目指しています。

開発とツール

48.6K

POINTS Yi 1.5 9B Chat

POINTS-Yi-1.5-9B-Chatは、最新の視覚言語モデル技術と微信AIが開発した新技術を統合した視覚言語モデルです。事前学習データセットのフィルタリングやModel Soup技術などにおいて顕著なイノベーションがあり、事前学習データセットのサイズを大幅に削減し、モデルのパフォーマンスを向上させます。複数のベンチマークテストで優れた性能を発揮しており、視覚言語モデル分野における重要な進歩です。

AIモデル

48.0K

Internvl2 5 78B

InternVL 2.5は、InternVL 2.0をベースに、大幅なトレーニングとテスト戦略の強化、データ品質の向上により進化した、最先端の多モーダル大規模言語モデル(MLLM)シリーズです。このモデルシリーズは、画像認識や多モーダル能力において最適化されており、画像、テキスト間変換など様々な機能をサポートし、視覚情報と言語情報を処理する必要がある複雑なタスクに適しています。

AIモデル

54.1K

Aria Base 64K

Aria-Base-64KはAriaシリーズの基本モデルの一つであり、研究目的と継続的なトレーニングのために設計されています。このモデルは、長文テキストの事前学習段階を経て生成され、330億トークン(多モーダル210億、言語120億、69%が長文テキスト)のトレーニングを受けています。長尺動画質問応答データセットまたは長尺文書質問応答データセットの継続的な事前学習または微調整に適しており、リソースが限られた場合でも、短い指示による微調整データセットを用いて後続のトレーニングを行い、長文テキスト質問応答シーンに移行させることができます。このモデルは最大250枚の高解像度画像または最大500枚の中解像度画像を理解し、言語および多モーダルシーンにおいて強力な基本性能を維持します。

AIモデル

43.1K

Seyft AI

Seyft AIは、テキスト、画像、動画における有害なコンテンツや不適切なコンテンツをリアルタイムでフィルタリングし、コンプライアンスを確保し、様々な言語や文化的背景に合わせたパーソナライズされたソリューションを提供するリアルタイム多モーダルコンテンツ審査プラットフォームです。主な利点としては、リアルタイム審査、多言語対応、AIによる画像?動画審査の自動化、そして容易なAPI統合が挙げられます。Seyft AIは、企業がデジタル空間のクリーンさと安全性を維持することを支援することを目的としており、コンテンツ審査が必要となるあらゆるアプリケーションシナリオに適しています。

AI内容検査

52.2K

MM1.5

MM1.5は、テキストリッチな画像理解、視覚的参照解決とグラウンディング、およびマルチイメージ推論能力を強化することを目的とした、多モーダル大規模言語モデル(MLLM)シリーズです。MM1アーキテクチャをベースとし、データ中心のモデルトレーニング手法を採用し、モデルトレーニングライフサイクル全体における様々なデータ混合の影響を体系的に探求しました。MM1.5モデルは、10億から300億パラメーターのモデルを含み、密なモデルと混合専門家(MoE)モデルの両方を備えています。広範な実証研究とアブレーションスタディを通じて、詳細なトレーニングプロセスと意思決定に関する知見を提供し、将来のMLLM開発研究のための貴重な指針となります。

AIモデル

47.7K

Aria

Ariaは、強力な多モーダル、言語、コーディングタスクの性能を備えた、多モーダルネイティブ混合専門家モデルです。ビデオとドキュメントの理解において優れた性能を示し、最大64Kの長さの多モーダル入力をサポートし、256フレームのビデオを10秒以内で記述できます。Ariaモデルのパラメータ数は25.3Bで、単一のA100(80GB)GPU上でbfloat16精度を使用してロードできます。Ariaの開発背景は、特にビデオとドキュメント処理において、多モーダルデータの理解に対するニーズを満たすことです。これはオープンソースモデルであり、多モーダル人工知能の発展を促進することを目的としています。

AIモデル

51.9K

Show O

Show-oは、画像キャプション、Visual Question Answering(VQA)、テキストから画像への生成、テキストによる修復と拡張、および混合モーダル生成を処理できる、多モーダル理解と生成のための単一トランスフォーマーモデルです。シンガポール国立大学Show Labとバイトダンス(ByteDance)が共同で開発され、最新の深層学習技術を採用しており、多様なモーダルデータの理解と生成が可能で、人工知能分野における大きな進歩です。

AIモデル

52.4K

Medtrinity 25M

MedTrinity-25Mは大規模な多モーダルデータセットであり、多様な粒度の医学注釈を含んでいます。複数の著者によって共同開発され、医学画像およびテキスト処理分野の研究促進を目指しています。データセットの構築には、データ抽出、多粒度テキスト記述の生成などのステップが含まれており、様々な医学画像解析タスク(VQA、病理画像解析など)をサポートしています。

AI医療健康

78.1K

Minicpm V 2.6

MiniCPM-V 2.6は、8億パラメーターを持つ多モーダル大規模言語モデルです。単一画像理解、複数画像理解、動画理解など、複数の分野で優れた性能を発揮します。OpenCompassを始めとする複数の一般的なベンチマークテストにおいて平均65.2点の高得点を達成し、広く使用されている商用モデルを上回っています。強力なOCR機能も備え、多言語に対応し、iPadなどの端末デバイス上でのリアルタイム動画理解も実現できる高い効率性を誇ります。

AIモデル

52.2K

Gemini Pro

Gemini ProはDeepMindが開発した高性能な多モーダルAIモデルで、幅広いタスクに対応できるよう設計されています。最大200万トークンの長いコンテキストウィンドウを備え、大規模な文書、コード、音声、動画などを処理できます。コード生成、数学問題解決、多言語翻訳など、複数のベンチマークテストで優れた性能を示しています。

AIモデル

64.9K

SEED Story

SEED-Storyは、大規模言語モデル(MLLM)に基づく多モーダル長編ストーリー生成モデルです。ユーザーが提供した画像とテキストに基づき、豊かで一貫性のある叙述テキストと、スタイルが統一された画像を生成できます。これは、クリエイティブライティングとビジュアルアート分野におけるAIの最先端技術であり、高品質な多モーダルストーリーコンテンツを生成する能力を備え、クリエイティブ産業に新たな可能性を提供します。

AI創作物語

59.6K

高品質新製品

Tencent EMMA

EMMAは、最先端のテキストから画像への拡散モデルであるELLAを基盤とした、新しい画像生成モデルです。多様なモーダルプロンプトを受け入れ、革新的な多モーダル特徴接続器設計により、テキストと補足モーダル情報を効果的に統合します。本モデルは、元のT2I拡散モデルのすべてのパラメータを固定し、追加レイヤーのみを調整することで、事前学習済みのT2I拡散モデルが秘密裏に多様なモーダルプロンプトを受け入れるという興味深い特性を明らかにしました。EMMAは、様々な既存のフレームワークに容易に適応でき、パーソナライズされたコンテキスト認識画像や動画を生成するための柔軟で効率的なツールです。

AI画像生成

74.2K

Video MME

Video-MMEは、多モーダル大規模言語モデル(MLLMs)のビデオ分析における性能評価に特化したベンチマークテストです。MLLMsによる連続的な視覚データの処理能力に関する既存評価方法の空白を埋め、研究者にとって質が高く包括的な評価プラットフォームを提供します。本ベンチマークテストは、様々な長さのビデオを網羅し、MLLMsの中核能力を評価します。

AI動画分析

68.2K

Cogvlm2

CogVLM2は、清華大学チームによって開発された第二世代の多モーダル事前学習対話モデルです。複数のベンチマークテストで顕著な改善を示しており、8Kのコンテンツ長と1344×1344の高解像度画像に対応しています。CogVLM2シリーズモデルは、中国語と英語に対応したオープンソース版を提供しており、一部の非オープンソースモデルに匹敵する性能を備えています。

AIモデル

64.9K

Mousi

MouSiは、現在の巨大視覚言語モデル(VLMs)が直面する課題を解決することを目的とした、多モーダル視覚言語モデルです。個々の視覚エンコーダの能力を統合専門家技術によって協調させ、画像テキストマッチング、OCR、画像セグメンテーションなどを含みます。本モデルは、異なる視覚専門家からの出力を統合的に処理するための融合ネットワークを導入し、画像エンコーダと事前学習済みLLMs間のギャップを埋めます。さらに、MouSiは位置エンコーディングの無駄と長さの制限の問題を効果的に解決するための様々な位置エンコーディングスキームを検討しています。実験結果によると、複数の専門家を持つVLMsは、単独の視覚エンコーダよりも優れた性能を示し、統合する専門家が増えるにつれて顕著な性能向上を実現します。

AIモデル

54.6K

Univg

UniVGは、テキストと画像を含む複数のモーダルに対応可能な、統一的な多モーダル動画生成システムです。多条件交差アテンションとバイアス付きガウスノイズを導入することで、高自由度と低自由度の動画生成を実現しました。公開ベンチマークであるMSR-VTTにおいて、Fréchet Video Distance(FVD)を最低限に抑え、現行のオープンソース手法を人間評価において凌駕し、現行のクローズドソース手法であるGen2にも匹敵する性能を示しました。

AI動画生成

685.0K

Instruct Imagen

Instruct-Imagenは、多モーダル指示を取り入れることで、異種画像生成タスクの処理を可能にし、未知のタスクにおいても汎化を実現する多モーダル画像生成モデルです。テキスト、エッジ、スタイル、テーマなど、様々なモーダルを自然言語を用いて統合し、多様な生成意図を標準化します。事前学習済みのテキストから画像への拡散モデルに対して、2段階フレームワークによる微調整を行い、検索強化学習と多様な画像生成タスクによる微調整を採用することで、様々な画像生成データセットにおける人的評価において、領域内における既存のタスク特化型モデルと同等以上の性能を示し、未知でより複雑なタスクへの汎化能力の高さを示唆する結果が得られました。

AI画像生成

70.9K

Tinygpt V

TinyGPT-Vは、小型のバックボーンネットワークを用いて実現した、高効率な多モーダル大規模言語モデルです。強力な言語理解と生成能力を備え、様々な自然言語処理タスクに適用可能です。TinyGPT-VはPhi-2を事前学習モデルとして採用しており、優れた性能と効率性を誇ります。

AIモデル

60.7K

Docllm

DocLLMは、企業文書内のテキストと空間レイアウトを処理し、既存の大規模言語モデルを上回る性能を提供することを目的とした、多モーダル文書理解モデルを提供するプラットフォームです。軽量な拡張を採用し、高価な画像エンコーダーを回避し、空間レイアウト構造の取り込みに境界ボックス情報に焦点を当てています。従来のTransformerにおける注意機構を分解することにより、テキストと空間モーダリティ間のクロスアライメントを捉えます。さらに、視覚文書で頻繁に見られる不規則なレイアウトと異種コンテンツに対処するために、テキストパラグラフの補完を学習する事前学習目標を設計しました。このソリューションは、14個のタスクにおける16個のデータセットにおいて、既存の大規模言語モデルを上回り、5個の以前未見のデータセットにおいても良好な汎化能力を示します。

AIモデル

111.2K

Imagebind

ImageBindは、明示的な教師データなしで、6種類の感覚モーダルデータ(画像?動画、音声、テキスト、深度、熱画像、慣性計測ユニット(IMU))を同時にバインドできる新しいAIモデルです。これらのモーダル間の関係性を認識することで(画像と動画、音声、テキスト、深度、熱画像、慣性計測ユニット(IMU))、AIの発展を促進し、機械が様々な形式の情報をより適切に分析することを可能にします。デモを通して、ImageBindの画像、音声、テキストモーダルにおける能力をご覧ください。

AIモデル

48.0K

Magicavatar

MagicAvatarは、テキスト、ビデオ、音声など様々な入力モードをモーション信号に変換することで、アバターの生成/アニメーションを行う多モーダルフレームワークです。シンプルなテキストプロンプトからアバターを作成したり、与えられたソースビデオに基づいて、指定された動きに従ったアバターを作成したりできます。さらに、特定のテーマのアバターをアニメーション化することも可能です。MagicAvatarの強みは、複数の入力モードを組み合わせることで、高品質のアバターとアニメーションを生成できる点にあります。

AI顔画像生成

61.8K

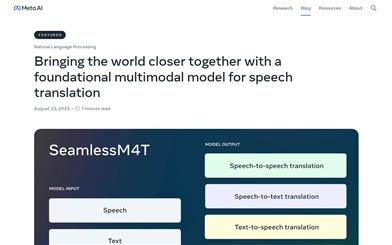

Seamlessm4t

SeamlessM4Tは、多モーダルモデルに基づく音声翻訳製品であり、約100言語の自動音声認識、音声翻訳、テキスト翻訳、音声合成などをサポートしています。本製品は、新たな多タスクUnitYモデルアーキテクチャを採用し、翻訳テキストと音声の直接生成を実現しています。SeamlessM4Tの自己教師あり音声エンコーダーw2v-BERT 2.0は、数百万時間にも及ぶ多言語音声の分析を通じて、音声における構造と意味の理解を学習しています。また、SONAR、SpeechLASERなどの多言語音声?テキストデータセットや、fairseq2などのシーケンスモデリングツールキットも提供しています。SeamlessM4Tの公開は、AI技術による音声翻訳における大きな進歩を示しています。

AI翻訳

56.6K

おすすめAI製品

海外精選

Jules AI

Jules は、自動で煩雑なコーディングタスクを処理し、あなたに核心的なコーディングに時間をかけることを可能にする異步コーディングエージェントです。その主な強みは GitHub との統合で、Pull Request(PR) を自動化し、テストを実行し、クラウド仮想マシン上でコードを検証することで、開発効率を大幅に向上させています。Jules はさまざまな開発者に適しており、特に忙しいチームには効果的にプロジェクトとコードの品質を管理する支援を行います。

開発プログラミング

39.7K

Nocode

NoCode はプログラミング経験を必要としないプラットフォームで、ユーザーが自然言語でアイデアを表現し、迅速にアプリケーションを生成することが可能です。これにより、開発の障壁を下げ、より多くの人が自身のアイデアを実現できるようになります。このプラットフォームはリアルタイムプレビュー機能とワンクリックデプロイ機能を提供しており、技術的な知識がないユーザーにも非常に使いやすい設計となっています。

開発プラットフォーム

39.2K

Listenhub

ListenHub は軽量級の AI ポッドキャストジェネレーターであり、中国語と英語に対応しています。最先端の AI 技術を使用し、ユーザーが興味を持つポッドキャストコンテンツを迅速に生成できます。その主な利点には、自然な会話と超高品質な音声効果が含まれており、いつでもどこでも高品質な聴覚体験を楽しむことができます。ListenHub はコンテンツ生成速度を改善するだけでなく、モバイルデバイスにも対応しており、さまざまな場面で使いやすいです。情報取得の高効率なツールとして位置づけられており、幅広いリスナーのニーズに応えています。

AI

38.1K

中国語精選

腾讯混元画像 2.0

腾讯混元画像 2.0 は腾讯が最新に発表したAI画像生成モデルで、生成スピードと画質が大幅に向上しました。超高圧縮倍率のエンコード?デコーダーと新しい拡散アーキテクチャを採用しており、画像生成速度はミリ秒級まで到達し、従来の時間のかかる生成を回避することが可能です。また、強化学習アルゴリズムと人間の美的知識の統合により、画像のリアリズムと詳細表現力を向上させ、デザイナー、クリエーターなどの専門ユーザーに適しています。

画像生成

38.6K

Openmemory MCP

OpenMemoryはオープンソースの個人向けメモリレイヤーで、大規模言語モデル(LLM)に私密でポータブルなメモリ管理を提供します。ユーザーはデータに対する完全な制御権を持ち、AIアプリケーションを作成する際も安全性を保つことができます。このプロジェクトはDocker、Python、Node.jsをサポートしており、開発者が個別化されたAI体験を行うのに適しています。また、個人情報を漏らすことなくAIを利用したいユーザーにお勧めします。

オープンソース

39.5K

Fastvlm

FastVLM は、視覚言語モデル向けに設計された効果的な視覚符号化モデルです。イノベーティブな FastViTHD ミックスドビジュアル符号化エンジンを使用することで、高解像度画像の符号化時間と出力されるトークンの数を削減し、モデルのスループットと精度を向上させました。FastVLM の主な位置付けは、開発者が強力な視覚言語処理機能を得られるように支援し、特に迅速なレスポンスが必要なモバイルデバイス上で優れたパフォーマンスを発揮します。

画像処理

38.4K

海外精選

ピカ

ピカは、ユーザーが自身の創造的なアイデアをアップロードすると、AIがそれに基づいた動画を自動生成する動画制作プラットフォームです。主な機能は、多様なアイデアからの動画生成、プロフェッショナルな動画効果、シンプルで使いやすい操作性です。無料トライアル方式を採用しており、クリエイターや動画愛好家をターゲットとしています。

映像制作

17.6M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M