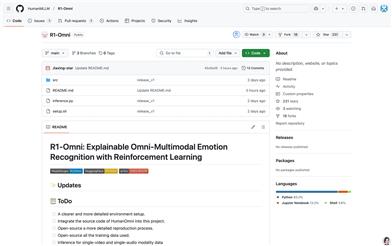

R1 Omni

紹介 :

R1-Omniは、強化学習によってモデルの推論能力と汎化能力を向上させた、革新的なマルチモーダル感情認識モデルです。HumanOmni-0.5Bを基に開発され、感情認識タスクに特化しており、視覚および音声モーダル情報から感情分析を行うことができます。主な利点としては、強力な推論能力、感情認識性能の顕著な向上、および分布外データにおける優れたパフォーマンスが挙げられます。感情分析、スマートカスタマーサービスなどの分野でマルチモーダルな理解が必要なシナリオに適用でき、重要な研究および応用価値を有しています。

ターゲットユーザー :

このモデルは、特にマルチモーダル感情認識タスクを扱う必要がある研究者や開発者、チームにとって有用です。感情認識システムの迅速な構築と最適化、モデルの性能と解釈性の向上に役立ちます。また、教育分野においても、学生や研究者がマルチモーダルタスクにおける強化学習の応用をより深く理解するのに役立ちます。

使用シナリオ

スマートカスタマーサービスシステムにおいて、顧客の音声とビデオから感情を分析し、より正確なサービスを提供する。

メンタルヘルスアプリケーションにおいて、ユーザーの感情表現を分析し、感情の疏導に関するアドバイスを提供する。

ビデオコンテンツの審査において、ビデオ内のネガティブな感情を自動検出し、手動審査を支援する。

製品特徴

強化学習を組み合わせることで感情認識の推論能力を向上させる

全モーダル入力(ビデオ、オーディオ)による感情分析をサポートする

詳細な推論プロセスを提供し、モデルの解釈性を高める

分布外データで優れたパフォーマンスを示し、強力な汎化能力を備える

WhisperやSiglipなど、さまざまな事前学習済みモデルの統合をサポートする

開発者が再現および拡張しやすいように、詳細なトレーニングと推論コードを提供する

DFEWやMAFWなど、さまざまな感情データセットのトレーニングと検証をサポートする

モデルの詳細な性能指標と可視化結果を提供する

使用チュートリアル

1. PyTorchやマルチモーダルモデル(Whisper、Siglipなど)を含む関連する依存関係をダウンロードしてインストールします。

2. R1-Omniコードリポジトリをクローンし、READMEファイルの説明に従って環境を設定します。

3. 事前学習済みモデル(HumanOmni-0.5B、R1-Omniなど)をダウンロードし、パスを設定します。

4. inference.pyファイルを使用して、単一ビデオまたはマルチモーダル入力の感情推論を実行します。

5. 必要に応じて、モデル設定ファイル(config.json)を調整して、異なる入力データに対応させます。

6. トレーニングコード(train.pyなど)を使用して、モデルの微調整またはカスタムトレーニングを行います。

7. 可視化ツール(wandbなど)を使用して、モデルのトレーニングと推論の結果を確認します。

8. 実際のニーズに合わせて、モデルをスマートカスタマーサービスやビデオ分析システムなどの具体的なアプリケーションシナリオに統合します。