Flashmla

紹介 :

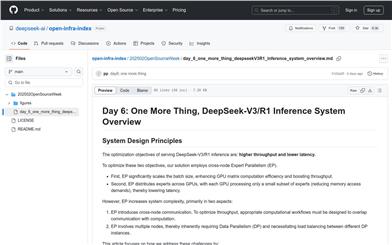

FlashMLAは、可変長シーケンスサービス向けに設計された、Hopper GPU向けに最適化された高効率なMLAデコードカーネルです。CUDA 12.3以降に対応し、PyTorch 2.0以降をサポートしています。FlashMLAの主な利点は、高効率なメモリアクセスと計算性能であり、H800 SXM5上で最大3000 GB/sのメモリ帯域幅と580 TFLOPSの計算性能を実現します。大規模並列計算と高効率なメモリ管理を必要とする深層学習タスク、特に自然言語処理やコンピュータビジョン分野において重要な役割を果たします。FlashMLAの開発はFlashAttention 2&3とCutlassプロジェクトから着想を得ており、研究者や開発者にとって高効率な計算ツールを提供することを目的としています。

ターゲットユーザー :

FlashMLAは、高効率な計算とメモリ管理を必要とする深層学習の研究者や開発者にとって有用です。特に自然言語処理やコンピュータビジョン分野において効果を発揮します。モデルの推論速度と効率を大幅に向上させ、大規模データや複雑な計算タスクを処理する必要がある場面に適しています。

使用シナリオ

自然言語処理タスクにおいて、FlashMLAはTransformerモデルの推論速度を大幅に向上させることができます。

コンピュータビジョンタスクにおいて、FlashMLAは畳み込みニューラルネットワークのメモリアクセス効率を最適化できます。

大規模なレコメンデーションシステムにおいて、FlashMLAはユーザー行動予測モデルの計算を高速化できます。

製品特徴

BF16データ形式をサポートし、計算効率と精度を向上させます。

ページングkvcache(ブロックサイズ64)を提供し、メモリ管理を最適化します。

Hopper GPUアーキテクチャに準拠し、ハードウェアアクセラレーション機能を最大限に活用します。

CUDA 12.3以降をサポートし、最新技術との互換性を確保します。

PyTorch 2.0と統合されているため、既存の深層学習プロジェクトで簡単に使用できます。

使用チュートリアル

1. FlashMLAのインストール:`python setup.py install`を実行してインストールします。

2. ベンチマークテストの実行:`python tests/test_flash_mla.py`を実行して性能をテストします。

3. FlashMLAモジュールのインポート:コードで`flash_mla`モジュールをインポートします。

4. メタデータの取得:`get_mla_metadata`関数を呼び出して、スケジューリングメタデータを取得します。

5. デコードカーネルの使用:`flash_mla_with_kvcache`関数を呼び出して、高効率なデコードを実行します。

おすすめAI製品

Pseudoeditor

PseudoEditorは無料で使用できるオンライン擬似コードエディタです。構文の強調表示や自動補完などの機能を備えており、擬似コードの作成を容易にします。さらに、内蔵の擬似コードコンパイラ機能でテストすることも可能です。ダウンロード不要ですぐにご利用いただけます。

開発とツール

3.8M

Coze

Cozeは、次世代AIチャットボット構築プラットフォームです。AIチャットボットアプリケーションの迅速な作成、デバッグ、最適化が可能です。コーディング不要で、チャットボットを簡単に作成し、様々なプラットフォームに公開できます。豊富なプラグインも提供しており、データとの連携、アイデアをボットスキルへの変換、長期記憶の装備、会話の開始など、ボットの機能を拡張できます。

開発とツール

3.7M