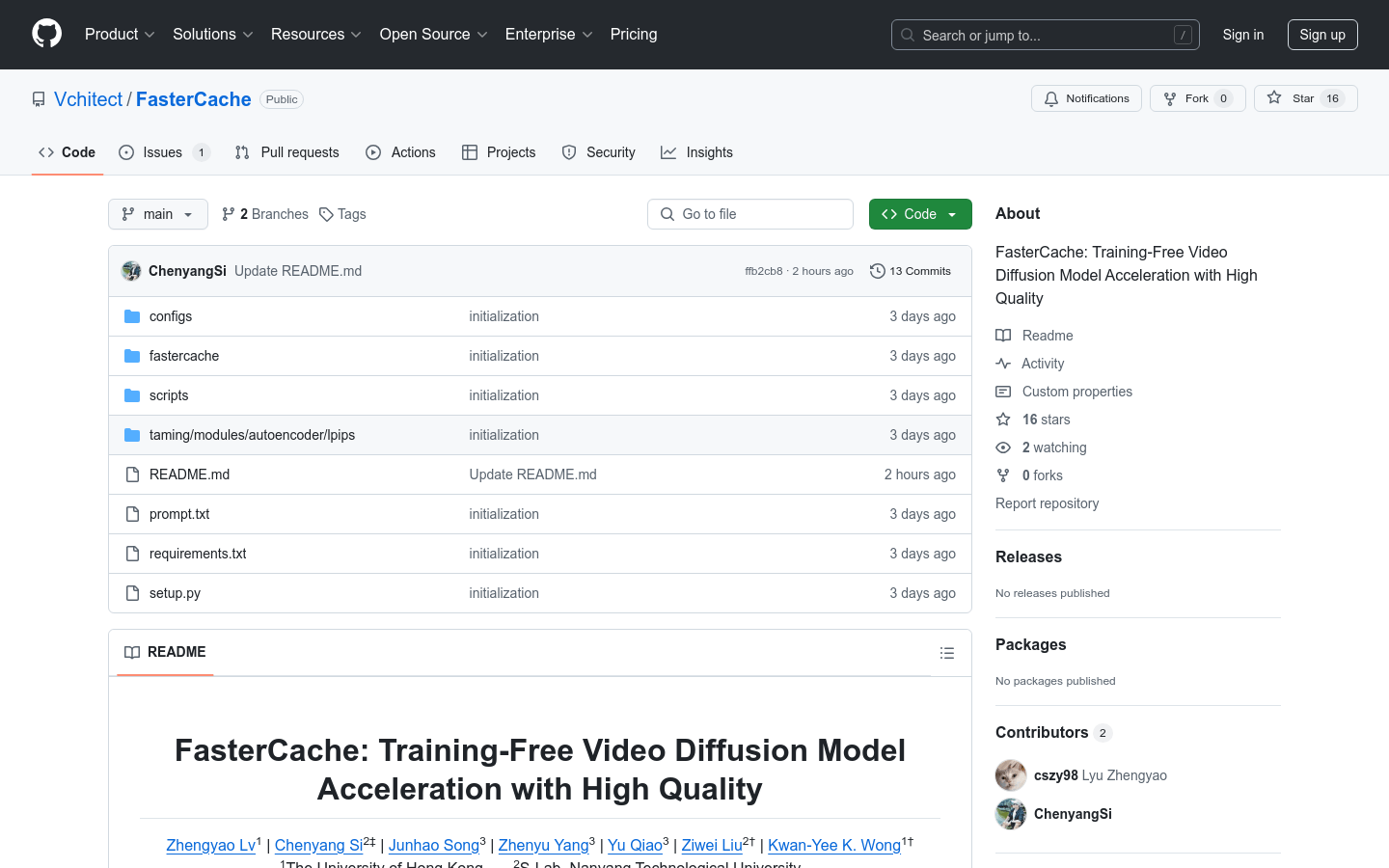

Fastercache

紹介 :

FasterCacheは、トレーニング不要の革新的な手法で、動画拡散モデルの推論過程を高速化し、高品質な動画コンテンツを生成することを目的としています。この技術の重要性は、動画生成の効率を大幅に向上させながら、コンテンツの品質を維持または向上させる点にあります。これは、迅速な動画生成が求められる業界にとって非常に価値のあるものです。FasterCacheは、香港大学、南洋理工大学、上海人工知能研究所の研究者によって共同開発されました。プロジェクトページでは、より多くの視覚的な結果と詳細情報をご覧いただけます。現在、無料で提供されており、主に動画コンテンツ生成、AI研究開発の分野を対象としています。

ターゲットユーザー :

主な対象ユーザーは、AI分野の研究者、動画コンテンツ生成業界のプロフェッショナル、そして高品質な動画生成技術に関心のある開発者です。FasterCacheのトレーニング不要な特徴により、使用のハードルが大幅に低くなり、深層学習のバックグラウンドを持たないユーザーでも、迅速に使い始めて実際のプロジェクトに適用することができます。

使用シナリオ

研究者はFasterCacheを使用して、動画拡散モデルの推論過程を高速化し、学術研究を行っています。

動画コンテンツ制作会社はFasterCacheを利用して、高品質な宣伝動画を生成し、作業効率を向上させています。

AI開発者はFasterCacheを通じて、動画生成分野における新しいアルゴリズムや応用事例を探求しています。

製品特徴

Open-Sora、Open-Sora-Plan、Latte、CogVideoX、Vchitect 2.0など、複数の動画拡散モデルをサポートします。

高速サンプリングを実現するため、シングルGPUとマルチGPUの推論スクリプトを提供します。

トレーニング不要で、動画拡散モデルの高速化に直接適用できます。

高品質な動画コンテンツを生成し、動画生成の品質を維持または向上させます。

GitHubでソースコードを提供し、研究者や開発者が容易に使用および二次開発できるようにしています。

プロジェクトページでは、詳細な使用方法と視覚的な結果を示しています。

使用チュートリアル

1. Anaconda環境の作成:ターミナルで提供されているコマンドを実行して、fastercacheという名前のAnaconda環境を作成し、アクティブ化します。

2. プロジェクトのクローン作成:gitコマンドを使用して、FasterCacheのGitHubリポジトリをローカルにクローンします。

3. 依存関係のインストール:プロジェクトディレクトリでpipコマンドを使用して、プロジェクトの依存関係をインストールします。

4. モデルの選択:高速化したい動画拡散モデルに応じて、適切な推論スクリプトを選択します。

5. スクリプトの実行:対応する推論スクリプトをターミナルで実行し、動画コンテンツの高速生成を開始します。

6. 結果の確認:生成された動画コンテンツは、スクリプトで指定されたパスに保存されます。ユーザーは生成された品質を確認および評価できます。

おすすめAI製品

Deepseek R1 Distill Qwen 7B

DeepSeek-R1-Distill-Qwen-7Bは、Qwen-7Bを蒸留最適化し、強化学習によって最適化された推論モデルです。数学、コード、推論タスクにおいて優れた性能を発揮し、高品質な推論チェーンと解決策を生成できます。大規模な強化学習とデータ蒸留技術により、推論能力と効率性が大幅に向上しており、複雑な推論と論理分析が必要なシナリオに適しています。

モデルトレーニングとデプロイメント

138.3K

Deepseekモデル互換性チェック

DeepSeekモデル互換性チェックは、デバイスが様々な規模のDeepSeekモデルを実行できるかどうかを評価するためのツールです。デバイスのシステムメモリ、ビデオメモリなどの構成と、モデルのパラメータ数、精度ビット数などの情報を組み合わせることで、モデル実行の予測結果を提供します。このツールは、開発者や研究者がDeepSeekモデルをデプロイする際に適切なハードウェアリソースを選択する上で非常に重要であり、ハードウェア不足による実行問題を事前に回避するのに役立ちます。DeepSeekモデル自体は、自然言語処理などで広く利用されている高度な深層学習モデルであり、効率的で正確な特徴を持っています。このチェックツールを使用することで、ユーザーはDeepSeekモデルをより効果的にプロジェクト開発や研究に活用できます。

モデルトレーニングとデプロイメント

102.9K