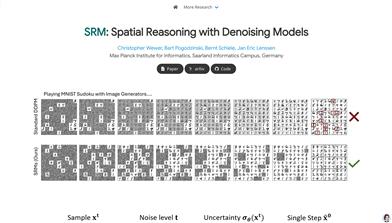

SRM

SRMは、連続変数の集合の推論タスクを処理するために使用される、ノイズ除去生成モデルに基づく空間推論フレームワークです。各未観測変数に独立したノイズレベルを割り当てることで、これらの変数の連続表現を段階的に推論します。この技術は、複雑な分布を処理する際に優れた性能を示し、生成プロセスにおける幻覚現象を効果的に削減します。SRMは、ノイズ除去ネットワークが生成順序を予測できることを初めて実証し、特定の推論タスクの精度を大幅に向上させました。このモデルはドイツのマックス?プランク情報学研究所によって開発され、空間推論と生成モデルの研究を推進することを目的としています。

モデルトレーニングとデプロイメント

42.2K

高品質新製品

EPLB

Expert Parallelism Load Balancer (EPLB)は、ディープラーニングにおけるエキスパート並列(EP)のための負荷分散アルゴリズムです。冗長エキスパート戦略とヒューリスティックなパッキングアルゴリズムにより、異なるGPU間の負荷バランスを確保し、同時にグループ制限エキスパートルーティングを利用してノード間のデータトラフィックを削減します。このアルゴリズムは大規模分散型トレーニングにおいて重要な意味を持ち、リソース利用率とトレーニング効率を向上させます。

モデルトレーニングとデプロイメント

42.0K

Tensorpool

TensorPoolは、機械学習モデルのトレーニングの簡素化に特化したクラウドGPUプラットフォームです。直感的なコマンドラインインターフェース(CLI)を提供することで、ユーザーはタスクを簡単に記述し、GPUのオーケストレーションと実行を自動的に処理できます。TensorPoolの中核技術には、インテリジェントなスポットノードリカバリ技術が含まれており、プリエンプティブインスタンスが中断された場合にジョブを即座に再開できるため、プリエンプティブインスタンスのコストメリットとオンデマンドインスタンスの信頼性を兼ね備えています。さらに、TensorPoolはリアルタイムのマルチクラウド分析を通じて最も安価なGPUオプションを選択し、ユーザーは実際の実行時間のみを支払う必要があり、アイドル状態のマシンによる追加コストを心配する必要はありません。TensorPoolの目標は、開発者がクラウドプロバイダーの設定に多くの時間を費やすことなく、機械学習エンジニアリングの速度と効率を向上させることです。個人プランとエンタープライズプランを提供しており、個人プランは毎週5ドルの無料クレジットを提供し、エンタープライズプランはより高度なサポートと機能を提供します。

モデルトレーニングとデプロイメント

44.4K

Mlgym

MLGymは、MetaのGenAIチームとUCSB NLPチームによって開発された、AI研究エージェントの訓練と評価のためのオープンソースのフレームワークとベンチマークです。多様なAI研究タスクを提供することにより、強化学習アルゴリズムの発展を促進し、研究者が現実世界の研究シナリオにおいてモデルを訓練および評価するのに役立ちます。このフレームワークは、コンピュータビジョン、自然言語処理、強化学習など、複数のタスクをサポートしており、AI研究のための標準化されたテストプラットフォームを目指しています。

モデルトレーニングとデプロイメント

44.2K

Flexheadfa

FlexHeadFAは、FlashAttentionを改良したモデルであり、高速かつメモリ効率の高い正確なアテンションメカニズムを提供することに重点を置いています。柔軟なヘッド次元の構成に対応しており、大規模言語モデルのパフォーマンスと効率を大幅に向上させることができます。主な利点としては、GPUリソースの効率的な利用、様々なヘッド次元の構成への対応、FlashAttention-2およびFlashAttention-3との互換性などが挙げられます。計算効率とメモリ最適化が必要な深層学習のシナリオ、特に長シーケンスデータの処理において優れた性能を発揮します。

モデルトレーニングとデプロイメント

44.7K

Moba

MoBA(Mixture of Block Attention)は、長文コンテキストを扱う大規模言語モデル向けに設計された革新的なアテンション機構です。コンテキストを複数のブロックに分割し、各クエリトークンが最も関連性の高いブロックに注目することで、効率的な長シーケンス処理を実現します。MoBAの主な利点は、フルアテンションとスパースアテンションをシームレスに切り替えられることで、性能と計算効率の両立を可能にしている点です。文書解析やコード生成など、長文処理が必要なタスクに適用可能であり、計算コストの大幅な削減と、高いモデル性能の維持を両立します。MoBAのオープンソース実装は、研究者や開発者に強力なツールを提供し、長文処理分野における大規模言語モデルの応用を促進します。

モデルトレーニングとデプロイメント

46.9K

KET RAG

KET-RAG(Knowledge-Enhanced Text Retrieval Augmented Generation)は、知識グラフ技術を統合した強力な検索強化型生成フレームワークです。知識グラフのスケルトンやテキストキーワード二部グラフなどの多粒度索引フレームワークを通じて、効率的な知識検索と生成を実現します。このフレームワークは、索引コストを削減しながら、検索と生成の品質を大幅に向上させ、大規模なRAGアプリケーションシナリオに適しています。KET-RAGはPythonで開発されており、柔軟な設定と拡張をサポートし、効率的な知識検索と生成を必要とする開発者や研究者向けです。

モデルトレーニングとデプロイメント

53.5K

海外精選

Olmoeアプリ

OLMoEは、Ai2が開発したオープンソースの言語モデルアプリで、研究者や開発者に、デバイス上でのAI実験のための完全にオープンなツールキットを提供することを目的としています。このアプリは、iPhoneとiPadでオフラインで動作し、ユーザーデータの完全なプライバシーを確保します。効率的なOLMoEモデルに基づいて構築されており、最適化と量子化により、モバイルデバイスでの動作時に高いパフォーマンスを維持します。このアプリのオープンソース特性は、次世代のデバイス側AIアプリケーションの研究開発において重要な基盤となります。

モデルトレーニングとデプロイメント

51.9K

Deepseekモデル互換性チェック

DeepSeekモデル互換性チェックは、デバイスが様々な規模のDeepSeekモデルを実行できるかどうかを評価するためのツールです。デバイスのシステムメモリ、ビデオメモリなどの構成と、モデルのパラメータ数、精度ビット数などの情報を組み合わせることで、モデル実行の予測結果を提供します。このツールは、開発者や研究者がDeepSeekモデルをデプロイする際に適切なハードウェアリソースを選択する上で非常に重要であり、ハードウェア不足による実行問題を事前に回避するのに役立ちます。DeepSeekモデル自体は、自然言語処理などで広く利用されている高度な深層学習モデルであり、効率的で正確な特徴を持っています。このチェックツールを使用することで、ユーザーはDeepSeekモデルをより効果的にプロジェクト開発や研究に活用できます。

モデルトレーニングとデプロイメント

101.8K

循環型事前学習モデル

本製品は大規模深層循環言語モデルのための事前学習コードライブラリであり、Pythonで開発されています。AMD GPUアーキテクチャに最適化されており、4096個のAMD GPU上で効率的に動作します。本技術の中核となるのは深層循環アーキテクチャであり、モデルの推論能力と効率を効果的に向上させます。主に、大規模な計算資源を必要とする場面における高性能自然言語処理モデルの研究開発に使用されます。このコードライブラリはApache-2.0ライセンスに基づいてオープンソース化されており、学術研究と産業応用の両方に適しています。

モデルトレーニングとデプロイメント

46.6K

Steev

SteevはAIモデルのトレーニング用に設計されたツールで、トレーニングプロセスの簡素化とモデル性能の向上を目指しています。トレーニングパラメータの自動最適化、トレーニングプロセスのリアルタイム監視、コードレビューと提案を提供することで、ユーザーはより効率的にモデルトレーニングを完了できます。Steevの主な利点は、設定不要で利用でき、モデルトレーニングの効率と品質を向上させたいエンジニアや研究者にとって最適なツールです。現在、無料トライアル中です。すべての機能を無料で体験いただけます。

モデルトレーニングとデプロイメント

45.3K

RAG FiT

RAG-FiTは、検索拡張生成(RAG)技術によって大規模言語モデル(LLM)の能力を向上させるための強力なツールです。専用のRAG強化データセットを作成することで、モデルが外部情報をより効果的に活用できるようになります。このライブラリは、データ準備からモデルのトレーニング、推論、評価までの全プロセスをサポートします。主な利点としては、モジュール化された設計、カスタマイズ可能なワークフロー、そして様々なRAG構成への対応が挙げられます。RAG-FiTはオープンソースライセンスに基づいており、研究者や開発者が迅速なプロトタイプ開発や実験を行うのに適しています。

モデルトレーニングとデプロイメント

47.7K

Llasa Training

LLaSA_trainingは、LLaMAベースの音声合成訓練プロジェクトです。訓練時間と推論時間の計算資源を最適化することで、音声合成モデルの効率と性能を向上させます。本プロジェクトは、オープンソースデータセットと内部データセットを用いて訓練を行い、様々な設定と訓練方法に対応しており、高い柔軟性と拡張性を備えています。主な利点として、効率的なデータ処理能力、強力な音声合成効果、そして複数言語のサポートが挙げられます。高性能な音声合成ソリューションを必要とする研究者や開発者にとって最適であり、スマートスピーカー、音声放送システムなどのアプリケーション開発に活用できます。

モデルトレーニングとデプロイメント

49.7K

Deepseek R1 Distill Qwen 7B

DeepSeek-R1-Distill-Qwen-7Bは、Qwen-7Bを蒸留最適化し、強化学習によって最適化された推論モデルです。数学、コード、推論タスクにおいて優れた性能を発揮し、高品質な推論チェーンと解決策を生成できます。大規模な強化学習とデータ蒸留技術により、推論能力と効率性が大幅に向上しており、複雑な推論と論理分析が必要なシナリオに適しています。

モデルトレーニングとデプロイメント

137.2K

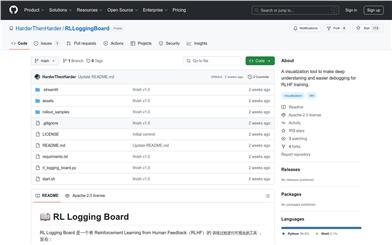

Rlloggingboard

RLLoggingBoardは、強化学習ヒューマンフィードバック(RLHF)の訓練過程の可視化に特化したツールです。詳細な指標監視を通じて、研究者や開発者が訓練過程を直感的に理解し、問題を迅速に特定し、訓練効果を最適化することを支援します。このツールは、報酬曲線、応答ソート、トークンレベルの指標など、様々な可視化モジュールをサポートしており、既存の訓練フレームワークを補助し、訓練効率と効果を向上させることを目的としています。必要な指標を保存できるあらゆる訓練フレームワークに対応し、高い柔軟性と拡張性を備えています。

モデルトレーニングとデプロイメント

45.0K

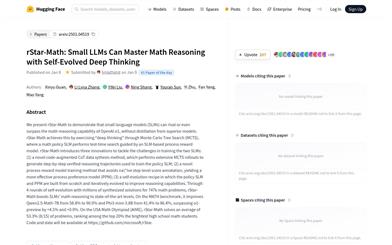

Rstar Math

rStar-Mathは、より高度なモデルに依存することなく、小型言語モデル(SLM)がOpenAIのo1モデルに匹敵、あるいはそれを上回る数学的推論能力を獲得できることを証明することを目的とした研究です。本研究は、モンテカルロ木探索(MCTS)を用いて「深層思考」を実現しており、SLMベースのプロセス報酬モデルの指導の下で、数学戦略SLMがテスト時に探索を行います。rStar-Mathは、2つのSLMのトレーニングという課題に対処するため、3つの革新的な手法を導入し、4回の自己進化と数百万の合成解を通して、SLMの数学的推論能力を最先端レベルにまで向上させました。このモデルはMATHベンチマークテストで性能を大幅に向上させ、AIMEコンテストでも優れた成績を収めました。

モデルトレーニングとデプロイメント

45.8K

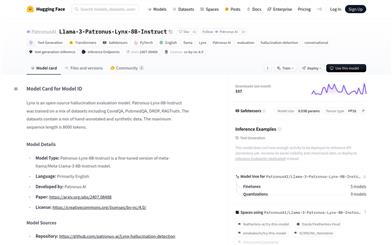

Llama 3 Patronus Lynx 8B Instruct

Llama-3-Patronus-Lynx-8B-Instructは、Patronus AIが開発したmeta-llama/Meta-Llama-3-8B-Instructモデルをファインチューニングしたバージョンです。RAG設定における幻覚検出を主な目的としています。CovidQA、PubmedQA、DROP、RAGTruthなど複数データセット(人工アノテーションデータと合成データを含む)で訓練されており、与えられた文書、質問、回答が文書内容に忠実であるか、文書外の新たな情報を含んでいないか、文書情報と矛盾していないかを評価できます。

モデルトレーニングとデプロイメント

48.3K

Llama 3 Patronus Lynx 8B Instruct V1.1

Patronus-Lynx-8B-Instruct-v1.1は、meta-llama/Meta-Llama-3.1-8B-Instructモデルを微調整したバージョンであり、RAG設定における幻覚の検出を主な目的としています。このモデルは、CovidQA、PubmedQA、DROP、RAGTruthなどの複数のデータセットを用いて訓練されており、手動アノテーションと合成データを含みます。与えられた文書、質問、回答が文書の内容に忠実であるかどうかを評価し、文書の範囲を超えた新しい情報や、文書情報と矛盾する情報を提供することはありません。

モデルトレーニングとデプロイメント

45.0K

Bespoke Labs

Bespoke Labsは、エンジニアによる正確なモデルのファインチューニングを支援するため、高品質なカスタマイズされたデータセットサービスを提供することに重点を置いています。Google DeepMindの元社員であるMaheshとUT AustinのAlexによって設立され、分野の発展に不可欠である高品質なデータの取得を改善することを目指しています。Bespoke Labsが提供するMinicheck、Evalchemy、Curatorなどのツールやプラットフォームは、データセットの作成と管理を設計されており、データの品質とモデルのパフォーマンスを向上させます。

モデルトレーニングとデプロイメント

42.5K

Openemma

OpenEMMAは、WaymoのEMMAモデルを再現したオープンソースプロジェクトです。自動運転車両のモーションプランニングのためのエンドツーエンドフレームワークを提供します。このモデルは、GPT-4やLLaVAなどの事前学習済みの視覚言語モデル(VLMs)を利用し、テキストと前方のカメラ入力を取り込むことで、車両自身の将来の経路点の正確な予測を実現し、その意思決定の根拠も提示します。OpenEMMAの目標は、研究者や開発者が自動運転研究と応用を推進するための使いやすいツールを提供することです。

モデルトレーニングとデプロイメント

47.5K

Procyon AIテキスト生成ベンチマーク

Procyon AIテキスト生成ベンチマークは、AIローカル大規模言語モデル(LLM)のパフォーマンスをテストおよび評価するために特化したベンチマークツールです。AIソフトウェアおよびハードウェア分野のリーダーと緊密に連携することで、テストがシステム内のローカルAIアクセラレーションハードウェアを最大限に活用できるようになっています。本ツールは、PCパフォーマンスの比較とコスト最適化を簡素化し、PCパフォーマンスの検証と標準化を行い、ITチームのPCライフサイクル管理を簡素化することで、迅速な意思決定を可能にし、PCパフォーマンスの向上、ハードウェアコストの削減、テスト時間の短縮を実現します。

モデルトレーニングとデプロイメント

45.0K

Langwatch

LangWatchは、大規模言語モデル(LLM)用に設計された監視、評価、最適化プラットフォームです。科学的な手法を用いてLLMの品質を測定し、最適なプロンプトとモデルを自動的に探し出し、直感的な分析ダッシュボードを提供することで、AIチームが10倍の速度で高品質な製品を提供できるよう支援します。LangWatchの主な利点としては、手動による最適化プロセスの削減、開発効率の向上、製品品質と安全性の確保、エンタープライズレベルのデータ制御とコンプライアンスのサポートなどが挙げられます。製品の背景情報として、LangWatchはStanfordのDSPyフレームワークを活用しており、数週間ではなく数分で適切なプロンプトやモデルを見つけ出し、概念実証から本番環境への移行を加速します。

モデルトレーニングとデプロイメント

44.7K

Unitree RL GYM

Unitree RL GYMは、Unitreeロボットをベースとした強化学習プラットフォームです。Unitree Go2、H1、H1_2、G1などの機種に対応しています。このプラットフォームは統合環境を提供し、研究者や開発者が強化学習アルゴリズムの、実機またはシミュレーション環境におけるロボット上での性能を訓練?テストすることを可能にします。複雑な意思決定や運動制御を必要とするアプリケーションにおいて、特にロボットの自律性とインテリジェンス技術の発展を促進する上で重要な役割を果たします。Unitree RL GYMはオープンソースで、無料で使用でき、主に研究者やロボット愛好家を対象としています。

モデルトレーニングとデプロイメント

53.3K

SPDL

SPDL(Scalable and Performant Data Loading)は、Meta Reality Labsが開発した新しいデータロードソリューションで、AIモデルのトレーニング効率を向上させることを目的としています。スレッドベースの並列処理を採用しており、従来のプロセスベースのソリューションと比較して、一般的なPythonインタープリターにおいて高いスループットを実現し、消費する計算リソースも少なくなります。SPDLはFree-Threaded Pythonと互換性があり、GILを無効にした場合、GILを有効にしたFT Python実装よりも高いスループットを実現します。SPDLの主な利点としては、高スループット、分かりやすいパフォーマンス、プリプロセス操作の非カプセル化、ドメイン固有言語(DSL)の導入がないこと、非同期ツールとのシームレスな統合、柔軟性、シンプルで直感的な操作性、および耐障害性が挙げられます。SPDLの背景情報によると、モデルの規模が大きくなるにつれてデータの計算需要も増加しますが、SPDLはGPUの利用率を最大化することでモデルのトレーニング速度を向上させます。

モデルトレーニングとデプロイメント

42.2K

Mwp ReFT

ReFTはオープンソースの研究プロジェクトであり、深層強化学習技術を用いて大規模言語モデルを微調整し、特定タスクにおける性能向上を目指しています。研究者や開発者が論文の結果を再現できるように、詳細なコードとデータを提供しています。ReFTの主な利点としては、強化学習を利用してモデルパラメータを自動調整できること、および微調整によって特定タスクにおけるモデルの性能を向上できることが挙げられます。製品背景情報として、ReFTはCodellamaとGalacticaモデルに基づいており、Apache2.0ライセンスに準拠しています。

モデルトレーニングとデプロイメント

48.6K

Star Attention

Star-AttentionはNVIDIAが提案した新しいブロックスパース注意力機構であり、Transformerベースの大型言語モデル(LLM)の長系列における推論効率を向上させることを目的としています。この技術は二段階の操作によって推論速度を大幅に向上させながら、95~100%の精度を維持します。ほとんどのTransformerベースのLLMと互換性があり、追加のトレーニングや微調整なしで直接使用でき、Flash AttentionやKVキャッシュ圧縮技術などの他の最適化手法と組み合わせて使用することで、さらに性能を向上させることができます。

モデルトレーニングとデプロイメント

45.8K

Hertz Dev

hertz-devは、Standard Intelligenceがオープンソースで提供する全二重、音声のみのトランスフォーマーベースモデルで、85億パラメーターを備えています。このモデルは拡張可能なクロスモーダル学習技術を表しており、モノラル16kHzの音声を8Hzの潜在表現に変換でき、ビットレートは1kbpsです。他のオーディオコーデックよりも優れた性能を発揮します。hertz-devの主な利点には、低遅延、高効率、研究者による微調整と構築の容易さなどがあります。製品の背景情報として、Standard Intelligenceは全人類に利益をもたらす汎用人工知能の構築を目指しており、hertz-devはその取り組みの第一歩です。

モデルトレーニングとデプロイメント

51.6K

海外精選

Maniskill

ManiSkillは、ロボットシミュレーション、無限のロボットデータ生成、および汎化ロボットAIに特化した、最先端のオープンソースプラットフォームです。HillBot.aiが主導するこのプラットフォームは、状態および/または視覚入力によるロボットの迅速なトレーニングをサポートしており、他のプラットフォームと比較して、ManiSkill/SAPIENは視覚データ収集速度を10~100倍に向上させています。GPU上でRGB-Dの並列シミュレーションとレンダリングをサポートし、最大30,000+FPSを実現します。ManiSkillは、40種類以上のスキル/タスクと2,000以上のオブジェクトを備えた事前構築済みタスクを提供し、数百万フレームのデモと密度の高い報酬関数を備えているため、ユーザーは資産の収集やタスクのデザインに時間を費やすことなく、アルゴリズム開発に専念できます。さらに、各並列環境で異なるオブジェクトとジョイントを同時にシミュレーションすることで、汎化ロボット戦略/AIのトレーニング時間を数日から数分に短縮します。ManiSkillは使いやすく、pipでインストールでき、シンプルで柔軟なGUIとすべての機能に関する包括的なドキュメントを提供します。

モデルトレーニングとデプロイメント

49.7K

SELA

SELAは、モンテカルロ木探索(MCTS)と大規模言語モデル(LLM)ベースのエージェントを組み合わせることで、自動機械学習(AutoML)を強化する革新的なシステムです。従来のAutoML手法は、多様性の低さと最適でないコードを生成することが多く、モデル選択と統合における有効性を制限していました。SELAは、パイプライン構成を木として表現することで、エージェントがソリューション空間をインテリジェントに探索し、実験からのフィードバックに基づいて戦略を反復的に改善することを可能にします。

モデルトレーニングとデプロイメント

45.0K

ROCKET 1

ROCKET-1は、オープンワールド環境における具象化された意思決定のために設計された視覚言語モデル(VLMs)です。このモデルは、視覚的?時間的コンテキストプロンプトプロトコルを通じて、VLMsとポリシーモデル間の通信を繋ぎ、過去と現在の観測からのオブジェクト分割を利用してポリシーと環境のインタラクションを導きます。ROCKET-1はこの方法により、VLMsの視覚言語推論能力を解き放ち、特に空間理解において、複雑な創造的なタスクを解決することを可能にします。Minecraftにおける実験では、この手法によりエージェントが以前は不可能だったタスクを達成できることが示され、具象化された意思決定における視覚的?時間的コンテキストプロンプトの有効性を強調しています。

モデルトレーニングとデプロイメント

46.9K

- 1

- 2

- 3

おすすめAI製品

海外精選

Jules AI

Jules は、自動で煩雑なコーディングタスクを処理し、あなたに核心的なコーディングに時間をかけることを可能にする異步コーディングエージェントです。その主な強みは GitHub との統合で、Pull Request(PR) を自動化し、テストを実行し、クラウド仮想マシン上でコードを検証することで、開発効率を大幅に向上させています。Jules はさまざまな開発者に適しており、特に忙しいチームには効果的にプロジェクトとコードの品質を管理する支援を行います。

開発プログラミング

39.2K

Nocode

NoCode はプログラミング経験を必要としないプラットフォームで、ユーザーが自然言語でアイデアを表現し、迅速にアプリケーションを生成することが可能です。これにより、開発の障壁を下げ、より多くの人が自身のアイデアを実現できるようになります。このプラットフォームはリアルタイムプレビュー機能とワンクリックデプロイ機能を提供しており、技術的な知識がないユーザーにも非常に使いやすい設計となっています。

開発プラットフォーム

38.9K

Listenhub

ListenHub は軽量級の AI ポッドキャストジェネレーターであり、中国語と英語に対応しています。最先端の AI 技術を使用し、ユーザーが興味を持つポッドキャストコンテンツを迅速に生成できます。その主な利点には、自然な会話と超高品質な音声効果が含まれており、いつでもどこでも高品質な聴覚体験を楽しむことができます。ListenHub はコンテンツ生成速度を改善するだけでなく、モバイルデバイスにも対応しており、さまざまな場面で使いやすいです。情報取得の高効率なツールとして位置づけられており、幅広いリスナーのニーズに応えています。

AI

38.1K

中国語精選

腾讯混元画像 2.0

腾讯混元画像 2.0 は腾讯が最新に発表したAI画像生成モデルで、生成スピードと画質が大幅に向上しました。超高圧縮倍率のエンコード?デコーダーと新しい拡散アーキテクチャを採用しており、画像生成速度はミリ秒級まで到達し、従来の時間のかかる生成を回避することが可能です。また、強化学習アルゴリズムと人間の美的知識の統合により、画像のリアリズムと詳細表現力を向上させ、デザイナー、クリエーターなどの専門ユーザーに適しています。

画像生成

38.1K

Openmemory MCP

OpenMemoryはオープンソースの個人向けメモリレイヤーで、大規模言語モデル(LLM)に私密でポータブルなメモリ管理を提供します。ユーザーはデータに対する完全な制御権を持ち、AIアプリケーションを作成する際も安全性を保つことができます。このプロジェクトはDocker、Python、Node.jsをサポートしており、開発者が個別化されたAI体験を行うのに適しています。また、個人情報を漏らすことなくAIを利用したいユーザーにお勧めします。

オープンソース

38.9K

Fastvlm

FastVLM は、視覚言語モデル向けに設計された効果的な視覚符号化モデルです。イノベーティブな FastViTHD ミックスドビジュアル符号化エンジンを使用することで、高解像度画像の符号化時間と出力されるトークンの数を削減し、モデルのスループットと精度を向上させました。FastVLM の主な位置付けは、開発者が強力な視覚言語処理機能を得られるように支援し、特に迅速なレスポンスが必要なモバイルデバイス上で優れたパフォーマンスを発揮します。

画像処理

38.1K

海外精選

ピカ

ピカは、ユーザーが自身の創造的なアイデアをアップロードすると、AIがそれに基づいた動画を自動生成する動画制作プラットフォームです。主な機能は、多様なアイデアからの動画生成、プロフェッショナルな動画効果、シンプルで使いやすい操作性です。無料トライアル方式を採用しており、クリエイターや動画愛好家をターゲットとしています。

映像制作

17.6M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M