Comfyui LLM パーティ

紹介 :

ComfyUI LLM パーティは、ComfyUIフロントエンドに基づいて、LLMワークフローノードの完全な集合体を開発することを目指しています。これにより、ユーザーは自身のLLMワークフローを迅速かつ簡単に構築し、既存の画像ワークフローに容易に統合できるようになります。

ターゲットユーザー :

ターゲットオーディエンスは、カスタムAIアシスタントの構築、業界ナレッジベース管理、複雑なエージェントインタラクションモデルの構築、ソーシャルアプリインターフェースへのアクセス、ストリーミング作業、学術研究、モデル適合を必要とする個人や企業です。

使用シナリオ

APIを使用してLLMを呼び出すワークフロー例

ローカルモデルを使用するワークフロー例

Ollamaを使用してローカルモデルを管理するワークフロー例

ナレッジベースRAG検索のワークフロー例

コードインタープリターの呼び出し例

製品特徴

様々なAPI呼び出しとローカル大型モデルの統合に対応

モジュール化されたツール呼び出しの実装

ロール設定とパーソナルAIアシスタントの迅速な構築に対応

業界固有の単語ベクトルRAGとGraphRAGに対応し、業界ナレッジベース管理を実現

単一エージェントプロセスから、複雑なエージェント間の放射状および環状インタラクションモデルの構築に対応

個人向けソーシャルアプリ(QQ、飛書、Discord)に必要なインターフェースに対応

ストリーミングワーカー向けの一括LLM + TTS + ComfyUIワークフローに対応

一般学生向けの最初のLLMアプリケーションの簡単な起動に対応

研究者によく使われる様々なパラメータ調整インターフェースとモデル適合に対応

使用チュートリアル

ワークフローをComfyUIにドラッグアンドドロップし、ComfyUI-Managerを使用して不足しているノードをインストールします。

APIを使用してLLMを呼び出す:start_with_LLM_api

Ollamaを使用してローカルLLMを管理する:start_with_Ollama

ローカル分散形式LLMを使用する:start_with_LLM_local

ローカルGGUF形式LLMを使用する:start_with_LLM_GGUF

ローカル分散形式VLMを使用する:start_with_VLM_local

ローカルGGUF形式VLMを使用する:start_with_VLM_GGUF

APIを使用する場合は、API LLMロードノードにbase_url(中継APIも可。/v1/で終わるようにしてください)とapi_keyを入力してください。

おすすめAI製品

中国語精選

剪映dreamina

剪映DreaminaはTikTok(抖音)が提供するAIGCツールです。テキストを入力すると、AIが自動的にクリエイティブな画像を生成します。画像サイズやアスペクト比、テンプレートの種類も調整可能です。将来的には、TikTokの画像投稿やショート動画のコンテンツ制作にも活用され、TikTokのAIによるコンテンツ制作の充実を図ります。

AI画像生成

9.0M

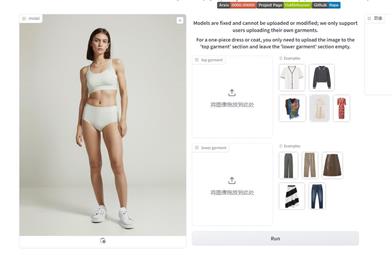

Outfit Anyone

Outfit Anyoneは、衣類を実際に試着することなく様々なファッションスタイルを試せる、超高品質のバーチャル試着製品です。2つの流れを持つ条件付き拡散モデルを採用することで、衣類の変形を柔軟に処理し、よりリアルな効果を生み出します。拡張性が高く、ポーズや体型などの要素を調整でき、アニメキャラクターから実写の人物まで幅広い画像に対応可能です。様々なシーンでの優れたパフォーマンスは、その実用性と実用化への準備が整っていることを示しています。

AI画像生成

5.2M