使用场景

使用API调用LLM的示例工作流

使用本地模型的示例工作流

使用ollama管理本地模型的示例工作流

知识库RAG搜索的示例工作流

代码解释器的调用示例

产品特色

支持多种API调用和本地大型模型集成

模块化实现工具调用

支持角色设置和快速构建个人AI助手

支持行业特定词向量RAG和GraphRAG,实现行业知识库管理

支持从单一代理流程到复杂代理间辐射和环形互动模式的构建

支持访问个人社交APP(QQ、飞书、Discord)所需的接口

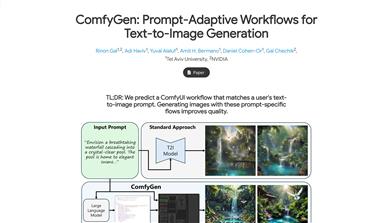

支持流媒体工作者所需的一站式LLM + TTS + ComfyUI工作流

支持普通学生所需的第一个LLM应用的简单启动

支持科研人员常用的各种参数调试接口和模型适配

使用教程

将工作流拖入ComfyUI中,然后使用ComfyUI-Manager安装缺失的节点

使用API调用LLM:start_with_LLM_api

使用ollama管理本地LLM:start_with_Ollama

使用本地分布式格式LLM:start_with_LLM_local

使用本地GGUF格式LLM:start_with_LLM_GGUF

使用本地分布式格式VLM:start_with_VLM_local

使用本地GGUF格式VLM:start_with_VLM_GGUF

如果是使用API,请在API LLM加载节点中填写你的base_url(可以是中继API,请确保以/v1/结尾)和api_key

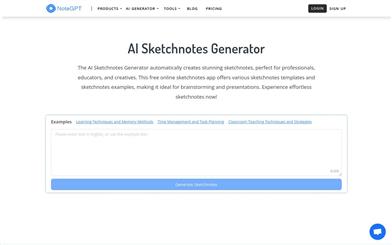

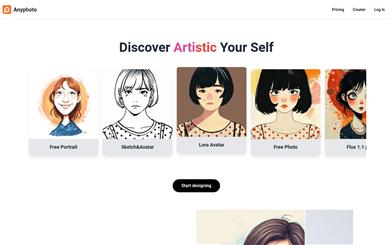

精选AI产品推荐

中文精选

剪映dreamina

剪映Dreamina是抖音旗下的AIGC工具,用户可以根据文本内容生成由AI生成的创意图,支持修整图片大小比例和模板类型。未来会用于抖音的图文或短视频的内容创作,丰富抖音在AI创造方面的内容库。

AI图像生成

9.1M

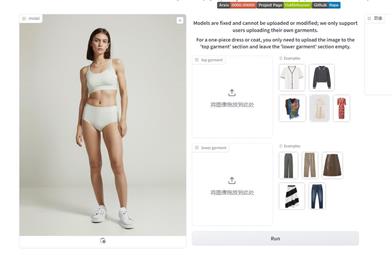

Outfit Anyone

Outfit Anyone 是一款超高质量虚拟试穿产品,使用户能够在不真实试穿衣物的情况下尝试不同的时尚款式。通过采用两个流的条件扩散模型,Outfit Anyone 能够灵活处理衣物变形,生成更逼真的效果。它具备可扩展性,可以调整姿势和身体形状等因素,适用于动漫角色到真实人物的图像。Outfit Anyone 在各种场景下的表现突出了其实用性和准备好投入实际应用的程度。

AI图像生成

5.7M