Loopyモデル

紹介 :

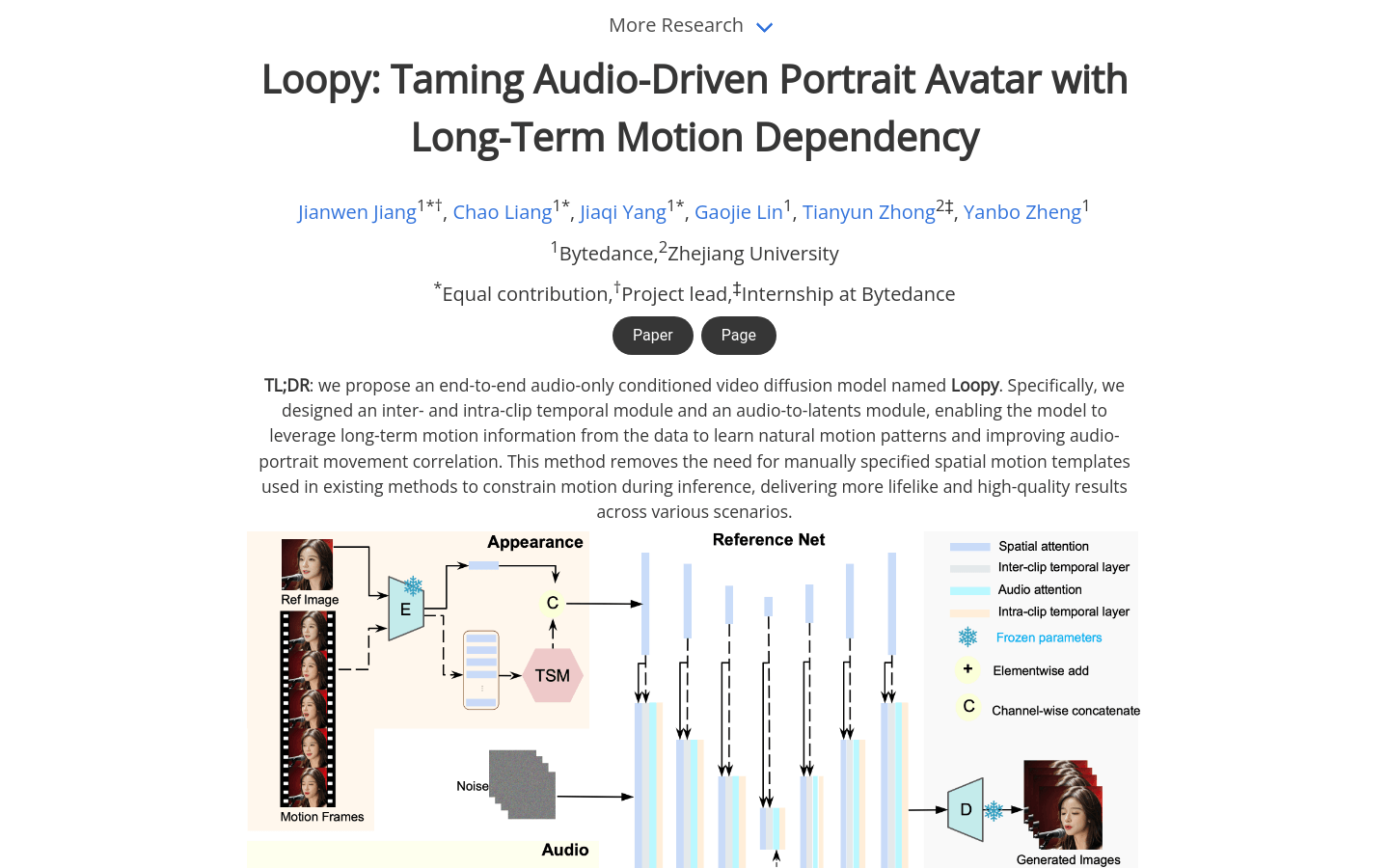

Loopyは、エンドツーエンドの音声駆動型ビデオ拡散モデルです。クロス?クリップとインクリップの時間モジュール、および音声から潜在表現へのモジュールを特別に設計することで、データ内の長期的な運動情報を利用して自然な運動パターンを学習し、音声と肖像画の動きの関連性を高めます。この手法により、既存の方法で必要とされていた空間運動テンプレートの手動指定が不要になり、様々なシーンにおいてよりリアルで高品質な結果を実現します。

ターゲットユーザー :

Loopyは、仮想現実、拡張現実、またはビデオ会議などにおいて、音声からリアルなアバターを作成する必要がある開発者や研究者にとって適しています。

使用シナリオ

ビデオ会議で、音声と同期したリアルなアバターをLoopyで生成します。

仮想現実ゲームで、Loopyを使用してキャラクターに動的に反応する表情を作成します。

ソーシャルメディアプラットフォームで、Loopyを使用して個性的な動的肖像画を生成します。

製品特徴

様々な視覚スタイルと音声スタイルに対応し、音声のみで生き生きとした動きを生成できます。

同じ参照画像に対して、異なる音声入力に基づいた動きに適応した合成結果を生成できます。

ため息、感情による眉毛や目の動き、自然な頭部の動きなど、非言語的な動作をサポートします。

速い、ゆっくりとした、またはリアルな歌唱パフォーマンスをサポートします。

側面の輪郭を含む画像を入力できます。

Loopyは、リアルな動きを生成する点において、最近の多くの手法と比較して明確な優位性を示します。

使用チュートリアル

Loopyの公式ウェブサイトまたはGitHubページにアクセスしてください。

ドキュメントを読んで、モデルの動作原理と使用条件を理解してください。

必要なコードとデータセットをダウンロードしてください。

指示に従って環境を設定し、必要なライブラリと依存関係をインストールしてください。

提供された音声ファイルと参照画像を使用してテストしてください。

パラメータを調整して、生成される動的肖像画の効果を最適化してください。

Loopyを独自のプロジェクトまたはアプリケーションに統合してください。

おすすめAI製品

Sora

Soraは、大規模データで学習されたテキスト制御型ビデオ生成拡散モデルです。1分間の高解像度ビデオ生成が可能で、幅広い視覚データの種類と解像度に対応します。ビデオと画像の圧縮潜在空間で学習することで、時空間的位置パッチに分解し、スケーラブルなビデオ生成を実現しています。また、三次元の一貫性やインタラクションなど、物理世界とデジタル世界の挙動をある程度シミュレートできる能力を示しており、高性能シミュレータの開発に向けて、ビデオ生成モデルの大規模化が有望であることを示唆しています。

AI動画生成

17.0M

Animate Anyone

Animate Anyoneは、駆動信号から静止画像を基にキャラクタビデオを生成することを目指しています。拡散モデルの力を活用し、キャラクタアニメーション用に特化した新しいフレームワークを提案します。参照画像における複雑な外観特徴の一貫性を維持するため、空間的注意機構を用いて詳細な特徴を統合するReferenceNetを設計しました。制御可能性と連続性を確保するため、キャラクタの動作をガイドする効率的なポーズガイド機構を導入し、ビデオフレーム間の滑らかなクロスフェードを実現する効果的な時間モデリング手法を採用しています。トレーニングデータの拡張により、任意のキャラクタのアニメーション作成が可能になり、他の画像からビデオへの変換手法と比較して、キャラクタアニメーションにおいて優れた結果を得ています。さらに、ファッションビデオと人間のダンス合成のベンチマークにおいて最先端の結果を達成しました。

AI動画生成

11.4M