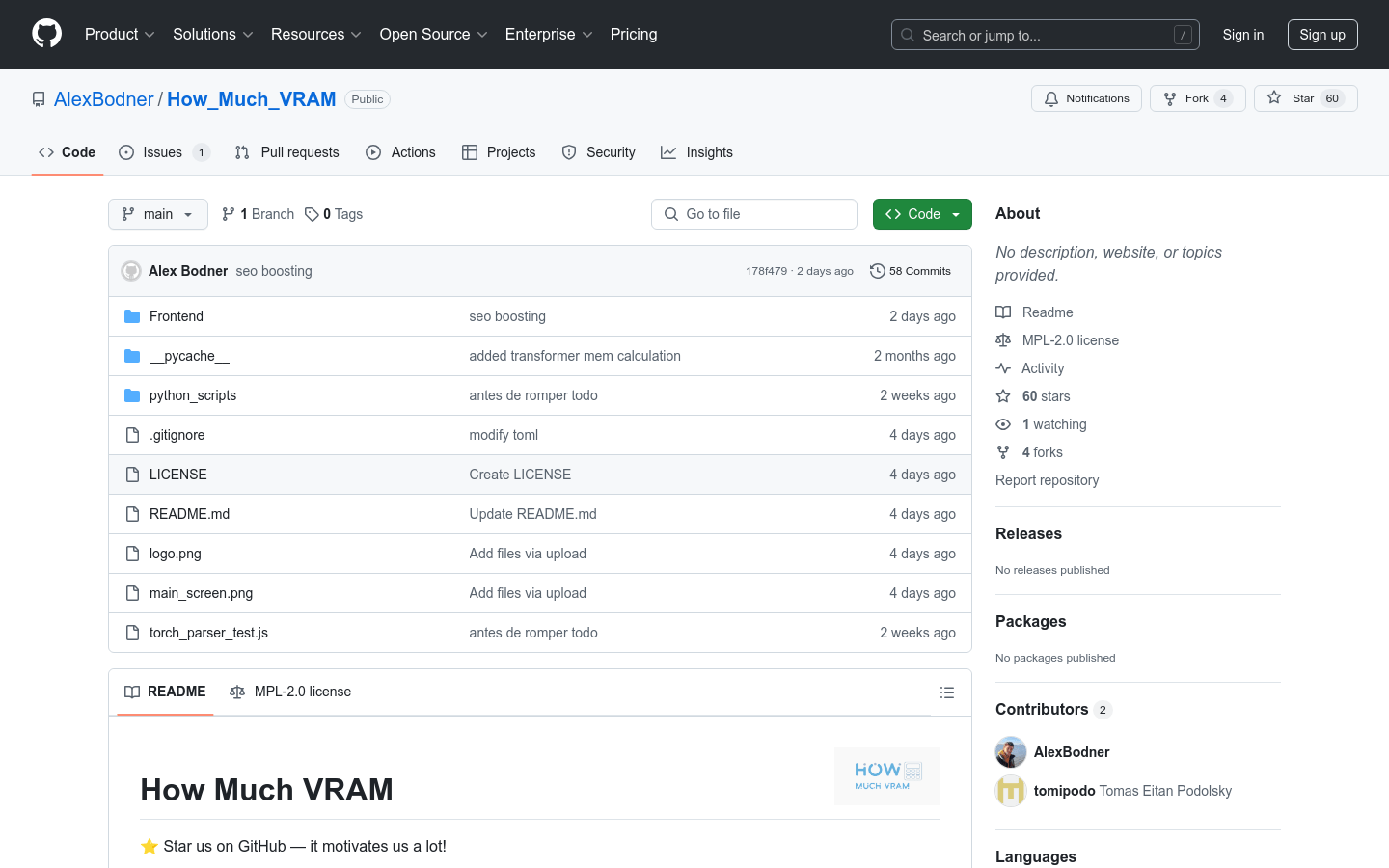

VRAM 消費量推定

紹介 :

VRAM消費量推定は、ユーザーがモデルの訓練または推論に必要なVRAM量を推定するのに役立つオープンソースプロジェクトです。このプロジェクトにより、ユーザーは様々な構成を試すことなく、必要なハードウェア構成を決定できます。深層学習モデルの訓練を行う開発者や研究者にとって非常に重要であり、ハードウェア選択における試行錯誤のコストを削減し、効率を向上させることができます。このプロジェクトはMPL-2.0ライセンスで提供され、無料で利用できます。

ターゲットユーザー :

主な対象ユーザーは、モデルのVRAM需要を正確に予測し、適切なハードウェアを選択してモデルの訓練と展開を行う必要がある、深層学習分野の研究者、開発者、学生です。

使用シナリオ

研究者はこのプロジェクトを使用して、大規模なニューラルネットワークモデルのVRAM需要を推定します。

開発者は、適切なGPUを選択してモデルの訓練を行う前に、このプロジェクトを使用して評価します。

学生は、授業のプロジェクトでこのツールを使用してハードウェア使用を最適化します。

製品特徴

モデルの訓練または推論に必要なVRAM量を推定する。

様々な深層学習モデルとフレームワークをサポートする。

詳細なVRAM使用状況レポートを提供し、ユーザーがVRAM消費を理解するのに役立つ。

オープンソースプロジェクトであり、コミュニティによる貢献と改善が可能。

ユーザーフレンドリーなインターフェースで、使いやすくなっている。

ローカルでの開発と実行に対応している。

使用チュートリアル

1. ターミナルを開き、プロジェクトの 'Frontend' フォルダに移動します。

2. 'npm install .' を実行して必要な依存関係をインストールします。

3. 'npm run dev' コマンドを実行してローカルサーバーを起動します。

4. プロンプトに従って、ブラウザで指定されたローカルホストポート(例: 'http://localhost:5173/')にアクセスします。

5. プロジェクトで提供されているインターフェースを使用して、モデルに関する情報を入力します。

6. VRAM推定結果を取得し、その結果に基づいてハードウェア構成を行います。

おすすめAI製品

Openui

UIコンポーネントの構築は、多くの場合退屈な作業です。OpenUIは、このプロセスを楽しく、迅速で、柔軟なものにすることを目指しています。これは、W&Bが次世代ツールのテストとプロトタイピングに使用しているツールであり、LLMを基盤とした強力なアプリケーションを構築するために使用されます。想像力でUIを記述し、リアルタイムでレンダリング結果を確認できます。変更を要求し、HTMLをReact、Svelte、Webコンポーネントなどに変換できます。V0のオープンソース版で、多少洗練されていないバージョンと考えてください。

AI開発助手

756.2K

Opendevin

OpenDevinは、複雑なエンジニアリングタスクを実行し、ソフトウェア開発プロジェクトにおいてユーザーと積極的に連携する自律型AIソフトウェアエンジニアであるDevinを複製、強化、そして革新することを目的としたオープンソースプロジェクトです。本プロジェクトはオープンソースコミュニティの力を活用し、Devinの能力を探求?拡張し、その強みと改善すべき点を特定することで、オープンソースコードモデルの進歩を導きます。

AI開発助手

598.4K