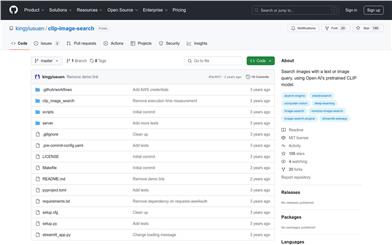

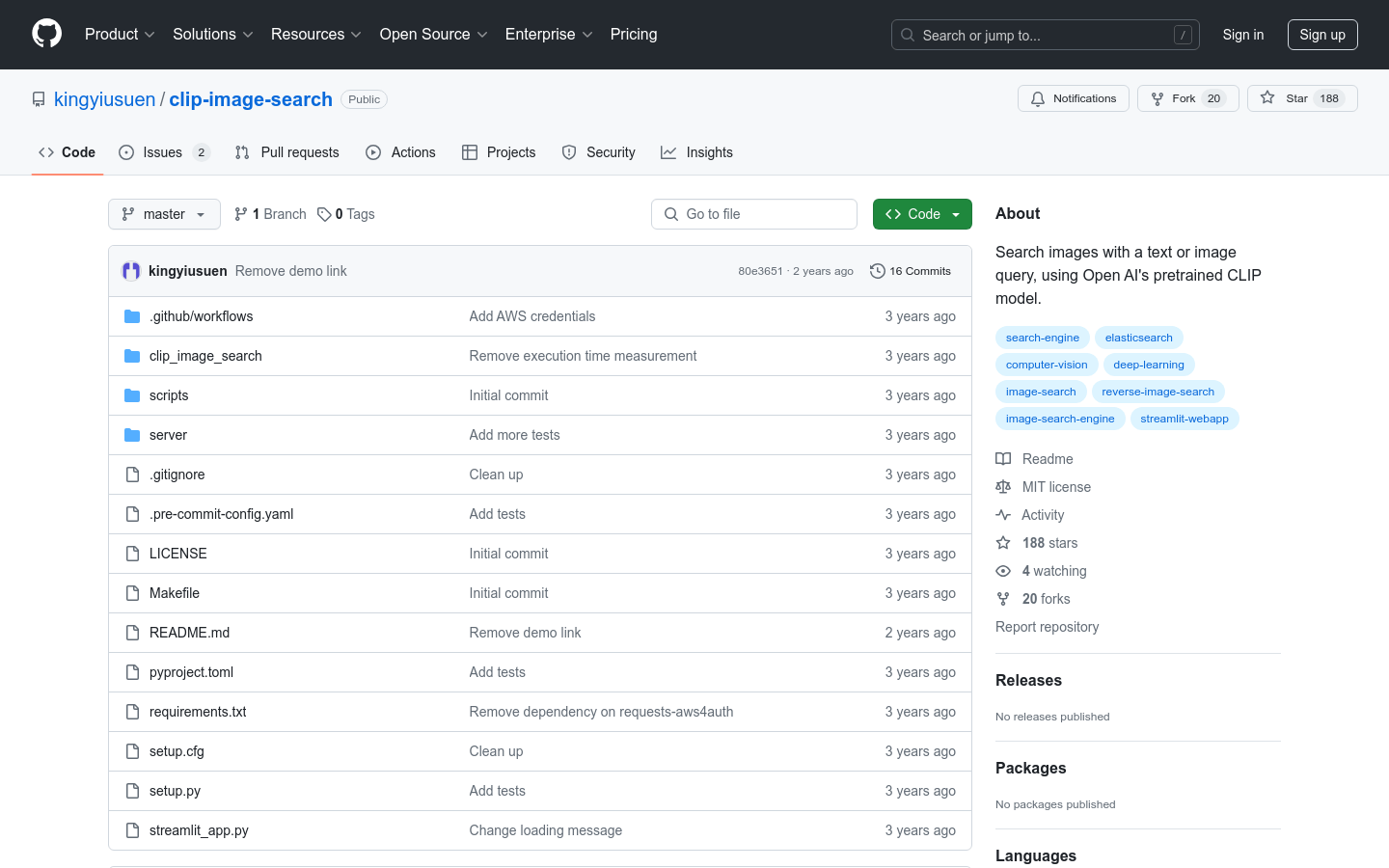

Clip Image Search

紹介 :

clip-image-searchは、Open AIの事前学習済みCLIPモデルに基づく画像検索ツールです。テキストまたは画像によるクエリで画像を検索できます。CLIPモデルは、画像とテキストを同じ潜在空間にマッピングするよう学習されており、類似度に基づいて比較が可能です。本ツールはUnsplashデータセットの画像を使用し、Amazon Elasticsearch Serviceを用いてk-最近傍検索を行い、AWS Lambda関数とAPI Gatewayでクエリサービスをデプロイしています。フロントエンドにはStreamlitを使用しています。

ターゲットユーザー :

本ツールは、画像検索を行う開発者や研究者、特に深層学習モデルに基づく画像検索に関心のあるユーザーを対象としています。シンプルで効率的な画像検索方法を提供し、既存のシステムに容易に統合できるため、これらのユーザーにとって最適なツールです。

使用シナリオ

研究者が本ツールを用いて、特定のテキスト記述に一致する画像を検索し、視覚認識の研究を行う

開発者が本ツールをアプリケーションに統合し、テキストベースの画像検索機能を提供する

教育者が本ツールを用いて、生徒が画像とテキスト間の関連性を理解するのを支援する

製品特徴

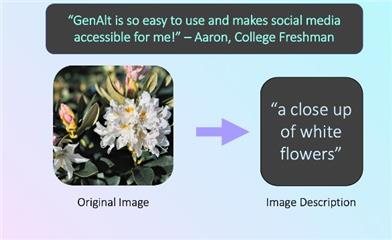

CLIPモデルの画像エンコーダーを用いて、データセット内の画像のフィーチャベクトルを計算する

画像を画像IDをインデックスとして、そのURLとフィーチャベクトルを保存する

クエリ(テキストまたは画像)に基づいて、そのフィーチャベクトルを計算する

クエリフィーチャベクトルとデータセット内の画像フィーチャベクトル間の余弦類似度を計算する

類似度が最も高いk枚の画像を返す

使用チュートリアル

依存関係のインストール

Unsplashデータセットのダウンロードとメタデータの抽出

インデックスの作成と画像フィーチャベクトルのElasticsearchへのアップロード

AWS Lambda用のDockerイメージの構築

Dockerイメージをコンテナとして実行し、POSTリクエストでテストする

Streamlitアプリケーションを実行してフロントエンドを表示する

おすすめAI製品

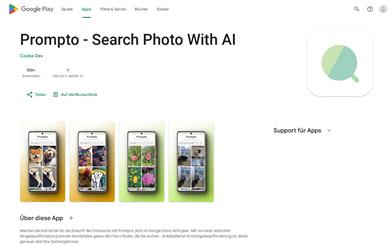

拾光

拾光は、AIを活用したスマートなアルバム検索ツールです。TensorFlowなどの最先端AI技術を用いて、ローカルアルバムの写真をインテリジェントにインデックス化し、ソートします。キーワードを入力するだけで、お好みの写真に素早くアクセスできます。人物、色、風景など、写真内の様々な視覚要素を認識し、効率的なアルバム検索を実現します。オフラインで使用でき、ユーザーデータのネットワーク転送は行われないため、プライバシーを効果的に保護します。シンプルでスムーズな操作性で生産性を向上させ、ローカルアルバム管理の優れたアシスタントとなります。

AI画像検査識別

163.7K

Creative Fabrica

Creative Fabricaは、高度な制作用フォント、グラフィック、クラフト素材などを提供するプラットフォームです。100万種類を超えるユニークで高度なデザイン素材(フォント、グラフィック、刺繍、クラフトなど)を提供しており、幅広い創作やデザインニーズに対応します。様々なライセンスオプションを用意し、毎日新しいデザイン素材を更新しています。

AI画像検索

110.7K