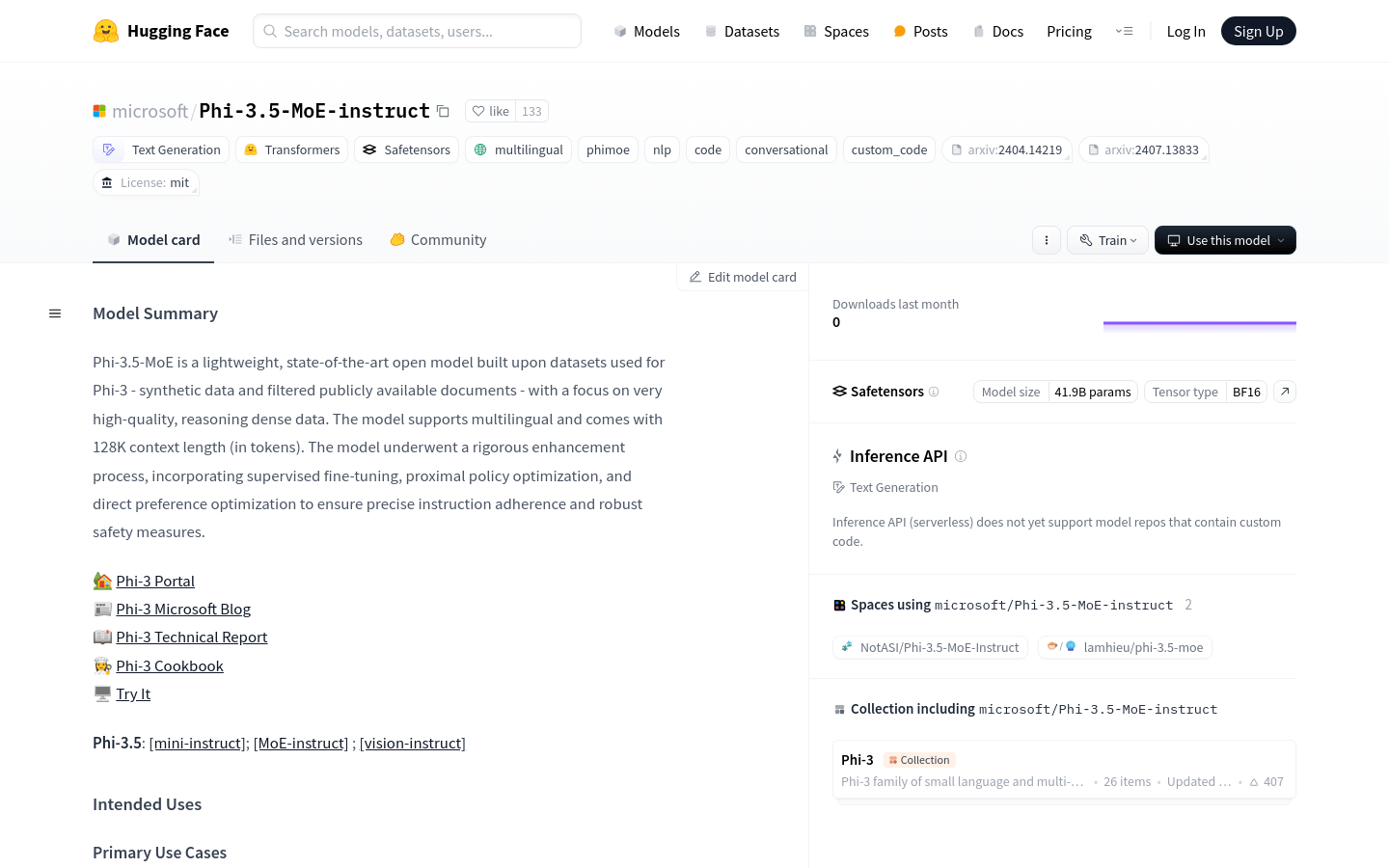

Phi 3.5 MoE Instruct

紹介 :

Phi-3.5-MoE-instructは、マイクロソフトが開発した軽量で多言語対応のAIモデルです。高品質で推論集約型のデータに基づいて構築されており、128Kのコンテキスト長をサポートします。このモデルは、教師あり微調整、近位政策最適化、直接選好最適化を含む厳格な強化プロセスを経ており、正確な指示への準拠と強力なセキュリティ対策が確保されています。生成AI機能の構成要素として、言語モデルとマルチモーダルモデルの研究を加速することを目的としています。

ターゲットユーザー :

多言語環境でのテキスト生成、推論、分析を必要とする研究者や開発者を対象としています。リソースが制限された環境で高性能なAIアプリケーションを実現したい企業や個人にも適しています。

使用シナリオ

研究者はPhi-3.5-MoE-instructを使用して、クロスリンガルのテキスト生成実験を行いました。

開発者はこのモデルを使用して、リソース制限のある計算環境でインテリジェントな対話システムを実現しました。

教育機関はこの技術をプログラミングや数学教育の補助に利用しています。

製品特徴

多言語テキスト生成をサポートし、商業利用と研究用途に適しています。

メモリ/計算リソースが制限された環境や、遅延に敏感なシナリオ向けに設計されています。

特にコード、数学、論理において強力な推論能力を備えています。

最大128Kのコンテキスト長をサポートし、長文タスクに適しています。

セキュリティ評価とレッドチームテストを実施し、モデルの安全性を確保しています。

教師あり微調整と直接選好最適化により、指示への準拠性を向上させています。

Flash-Attention技術を統合しており、特定のGPUハードウェアのサポートが必要です。

使用チュートリアル

1. サポートされているPython環境と、PyTorchやTransformersなどの必要な依存ライブラリがインストールされていることを確認します。

2. pipコマンドを使用してtransformersライブラリをインストールまたは更新します。

3. Hugging FaceモデルライブラリからPhi-3.5-MoE-instructモデルとトークナイザーをダウンロードします。

4. デバイスマッピングやリモートコードの信頼性など、モデルの読み込みパラメータを設定します。

5. 多言語テキストや特定形式のプロンプトなど、入力データを用意します。

6. モデルを使用して推論またはテキストを生成し、必要に応じて生成パラメータを調整します。

7. 生成されたテキストや推論結果を分析および評価し、具体的なアプリケーションのニーズを満たします。

おすすめAI製品

Deepmind Gemini

Geminiは、Google DeepMindが開発した次世代人工知能システムです。テキスト、画像、ビデオ、音声、コード間のシームレスな相互作用をサポートし、マルチモーダル推論を実行できます。言語理解、推論、数学、プログラミングなど、複数の分野において従来のシステムを凌駕し、現在までに開発された最も強力なAIシステムの一つとなっています。エッジコンピューティングからクラウドコンピューティングまで、様々なニーズに対応できる3つの異なる規模のバージョンがあります。Geminiは、クリエイティブデザイン、ライティングアシスタント、質問応答、コード生成など、幅広い分野で活用できます。

AIモデル

11.4M

中国語精選

Liblibai

LiblibAIは、中国をリードするAI創作プラットフォームです。強力なAI創作能力を提供し、クリエイターの創造性を支援します。プラットフォームは膨大な数の無料AI創作モデルを提供しており、ユーザーは検索してモデルを使用し、画像、テキスト、音声などの創作を行うことができます。また、ユーザーによる独自のAIモデルのトレーニングもサポートしています。幅広いクリエイターユーザーを対象としたプラットフォームとして、創作の機会を平等に提供し、クリエイティブ産業に貢献することで、誰もが創作の喜びを享受できるようにすることを目指しています。

AIモデル

6.9M