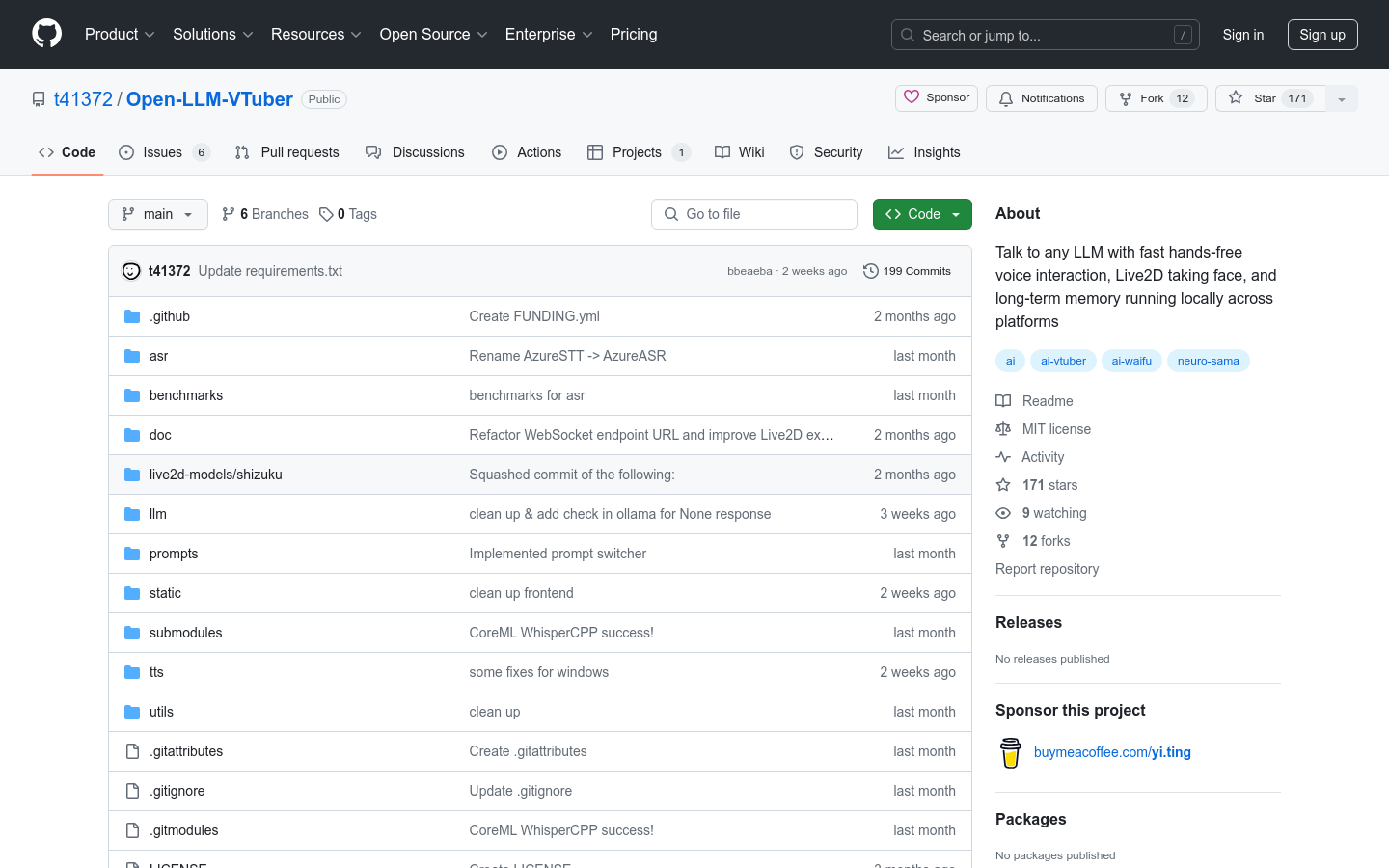

Open LLM VTuber

紹介 :

Open-LLM-VTuberは、音声を通じて大型言語モデル(LLM)とインタラクトすることを目的としたオープンソースプロジェクトです。リアルタイムのLive2D顔面キャプチャとクロスプラットフォームの長期記憶機能を備えています。macOS、Windows、Linuxをサポートし、様々な音声認識?音声合成バックエンドや、カスタマイズ可能な長期記憶ソリューションを選択できます。AIとの自然言語対話を様々なプラットフォームで実現したい開発者や愛好家に最適です。

ターゲットユーザー :

開発者、技術愛好家、AI研究者が対象ユーザーです。Open-LLM-VTuberを使って独自のバーチャルキャラクターを作成し、自然言語処理や機械学習の研究、あるいはAIとインタラクトするアプリケーション開発を行うことができます。

使用シナリオ

開発者がOpen-LLM-VTuberを使用して、多言語対応のバーチャルアシスタントを作成します。

教育機関が本プロジェクトを利用して、学生に自然言語処理の基礎を教えます。

技術愛好家がOpen-LLM-VTuberを使用して、パーソナライズされたAIチャットボットを開発します。

製品特徴

あらゆるOpenAI-API互換の大型言語モデルバックエンドとの音声インタラクションをサポートします。

音声認識とテキスト読み上げの提供プロバイダーを自由に選択できます。

MemGPTを統合し、長期記憶機能を実現することで、継続的なチャット体験を提供します。

Live2Dモデルを統合し、LLMのレスポンスに基づいて顔の表情を自動制御します。

macOSではGPUアクセラレーションを利用することで、遅延を大幅に削減します。

日本語を含む複数言語をサポートします。

完全オフラインでの動作が可能で、ユーザーのプライバシーを保護します。

使用チュートリアル

FFmpegやPython仮想環境などの必要な依存関係をインストールします。

Open-LLM-VTuberのコードリポジトリをローカルにクローンします。

必要に応じてプロジェクト内のconf.yamlファイルを構成し、音声認識とテキスト読み上げのバックエンドを選択します。

server.pyを実行してWebSocket通信サーバーを起動します。

index.htmlファイルを開いてフロントエンドインターフェースを起動します。

launch.pyまたはmain.pyを実行してバックエンド処理を起動します。

音声で大型言語モデルとインタラクトし、Live2Dモデルのリアルタイム反応を観察します。

おすすめAI製品

Ailice

AIliceは、JARVISのような自立型AIアシスタントを作成することを目指した、軽量のAIエージェントです。大規模言語モデル(LLM)を中核とした「テキストコンピュータ」を構築することで、この目標を達成します。AIliceは、テーマ調査、コーディング、システム管理、文献レビュー、そしてこれらの基本的な能力を超えた複雑な複合タスクにおいて優れた性能を発揮します。AIliceはGPT-4を活用することで日常生活におけるタスクでほぼ完璧な性能を達成しており、最新のオープンソースモデルを利用して実用化に向けて進化を続けています。

AIエージェント

454.6K

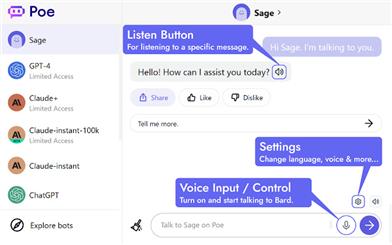

Poe AIと会話

Poe AIと会話は、Sage、GPT-4、Claude+を含むPoeのすべてのAIに対し、音声制御と朗読機能を提供するプラグインです。音声を使ってPoeのAIと会話し、様々な言語で回答を聞くことができます。また、AIの回答をクリアで自然な音声で朗読し、これも複数の言語に対応しています。簡単にインストールでき、キーボード入力は不要です。AIとのコミュニケーションをよりスムーズにします。

AI音声アシスタント

398.5K