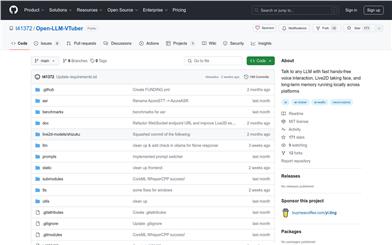

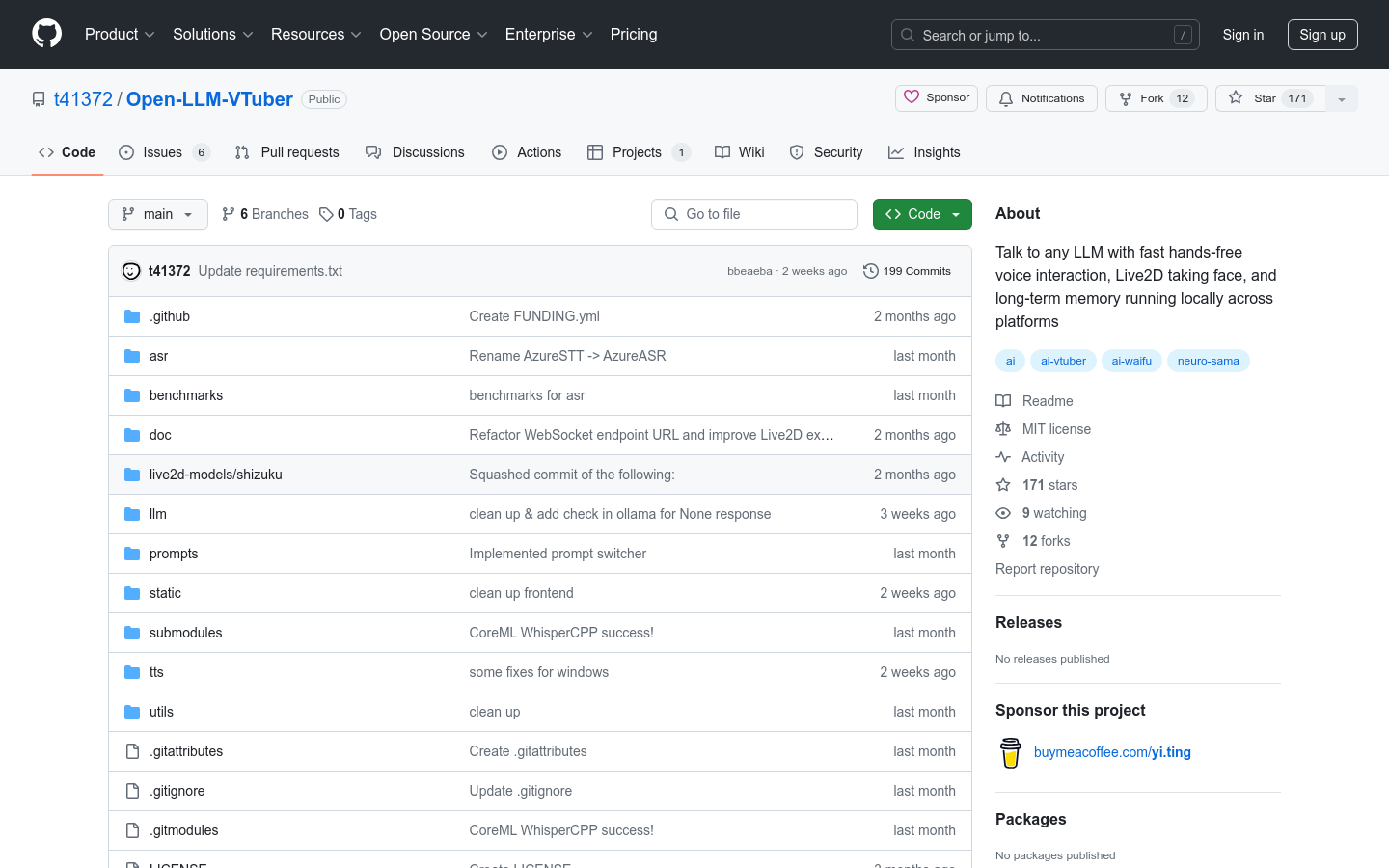

Open LLM VTuber

简介 :

Open-LLM-VTuber 是一个开源项目,旨在通过语音与大型语言模型(LLM)进行交互,具有实时的Live2D面部捕捉和跨平台的长期记忆功能。该项目支持macOS、Windows和Linux平台,允许用户选择不同的语音识别和语音合成后端,以及自定义的长期记忆解决方案。它特别适合希望在不同平台上实现与AI进行自然语言对话的开发者和爱好者。

需求人群 :

目标受众为开发者、技术爱好者和AI研究者,他们可以利用Open-LLM-VTuber来创建自己的虚拟角色,进行自然语言处理和机器学习的研究,或者开发与AI交互的应用程序。

使用场景

开发者使用Open-LLM-VTuber创建一个可以进行多语言对话的虚拟助手。

教育机构利用该项目来教授学生自然语言处理的基础知识。

技术爱好者使用Open-LLM-VTuber来开发个性化的AI聊天机器人。

产品特色

支持与任何OpenAI-API兼容的大型语言模型后端进行语音交互。

可以自定义选择语音识别和文本到语音合成的提供者。

集成MemGPT以实现长期记忆功能,提供持续的聊天体验。

支持Live2D模型,根据LLM响应自动控制面部表情。

能够在macOS上利用GPU加速,显著降低延迟。

支持多种语言,包括中文。

允许完全离线运行,保护用户隐私。

使用教程

安装必要的依赖项,如FFmpeg和Python虚拟环境。

克隆Open-LLM-VTuber的代码库到本地。

根据需要配置项目中的conf.yaml文件,选择语音识别和语音合成的后端。

运行server.py启动WebSocket通信服务器。

打开index.html文件以启动前端界面。

运行launch.py或main.py以启动后端处理。

通过语音与大型语言模型进行交互,观察Live2D模型的实时反应。

精选AI产品推荐

Ailice

AIlice是一个轻量级的AI代理,旨在创建一个类似于JARVIS的自包含人工智能助手。它通过构建一个以大型语言模型(LLM)为核心的“文本计算机”来实现这一目标。AIlice在主题研究、编码、系统管理、文献综述以及超越这些基本能力的复杂混合任务方面表现出色。AIlice利用GPT-4在日常生活中的任务中达到了近乎完美的性能,并正在利用最新的开源模型迈向实际应用。

AI Agents

466.2K

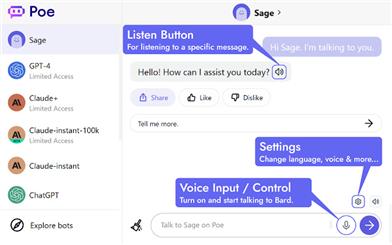

Talk To Poe AI

Talk to Poe AI是一个插件,为Poe的所有AI,包括Sage、GPT-4和Claude+,提供了语音控制和朗读功能。您可以使用语音与Poe的AI进行对话,并以多种语言听取其回复。该插件还可以将AI的回复以清晰自然的语音读出,支持多种语言。安装简便,无需键盘输入,让您更轻松地与AI交流。

AI语音助手

426.4K