Mimicmotion

紹介 :

MimicMotionは、テンセントと上海交通大学が共同開発した高品質な人体動作ビデオ生成モデルです。本モデルは、信頼度感知姿勢誘導によってビデオ生成プロセスの制御性を向上させ、ビデオの時間的滑らかさを高め、画像の歪みを低減します。高度な画像からビデオへの拡散モデルを採用し、時空間U-NetとPoseNetを組み合わせることで、姿勢シーケンス条件に基づき、任意の長さの高品質ビデオを生成できます。MimicMotionは、手の生成品質、参照姿勢への正確な追従性など、複数の点で従来の方法を大幅に上回っています。

ターゲットユーザー :

MimicMotionのターゲットユーザーは、ビデオ制作者、アニメーター、AI研究者です。本技術は、複雑な人体動作と時間的連続性を必要とするシーンにおいて、高品質なビデオコンテンツの生成を支援します。例えば、映画のポストプロダクション、仮想現実体験、ゲームアニメーション、AI研究などの分野で活用できます。

使用シナリオ

流れるような人体動作と表情を表現したダンスビデオを生成する。

リアルな動作と反応を備えたインタラクティブなキャラクターを仮想現実で作成する。

ゲーム開発において、キャラクターにダイナミックで反応性の高い動作をデザインする。

製品特徴

信頼度感知姿勢誘導による、姿勢推定の信頼度に応じた影響調整。

姿勢信頼度に基づく領域損失拡大により、画像歪みを大幅に低減。

漸進的潜在融合戦略により、時間的滑らかさを備えた長尺ビデオを生成。

オーバーラップ拡散技術により、任意の長さのビデオを生成。

ユーザー調査により、MimicMotionはTikTokデータセットのテストセットにおいて、ベースライン手法を上回ることが示されました。

アブレーションスタディにより、信頼度感知姿勢誘導と手部領域増強の有効性が実証されました。

使用チュートリアル

1. 入力参照画像と姿勢シーケンスを用意します。

2. MimicMotionモデルを使用してビデオを生成します。

3. 必要に応じて、信頼度感知姿勢誘導のパラメーターを調整します。

4. 領域損失拡大戦略を適用して、特定領域の画質を最適化します。

5. 漸進的潜在融合戦略を利用して長尺ビデオを生成します。

6. オーバーラップ拡散技術を使用して任意の長さのビデオを生成します。

7. ユーザー調査とアブレーションスタディを実施し、ビデオ生成効果を評価および改善します。

おすすめAI製品

Sora

Soraは、大規模データで学習されたテキスト制御型ビデオ生成拡散モデルです。1分間の高解像度ビデオ生成が可能で、幅広い視覚データの種類と解像度に対応します。ビデオと画像の圧縮潜在空間で学習することで、時空間的位置パッチに分解し、スケーラブルなビデオ生成を実現しています。また、三次元の一貫性やインタラクションなど、物理世界とデジタル世界の挙動をある程度シミュレートできる能力を示しており、高性能シミュレータの開発に向けて、ビデオ生成モデルの大規模化が有望であることを示唆しています。

AI動画生成

17.0M

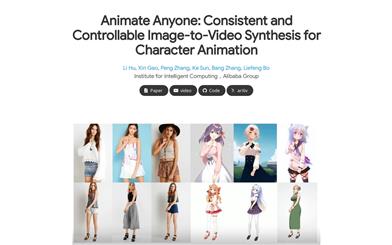

Animate Anyone

Animate Anyoneは、駆動信号から静止画像を基にキャラクタビデオを生成することを目指しています。拡散モデルの力を活用し、キャラクタアニメーション用に特化した新しいフレームワークを提案します。参照画像における複雑な外観特徴の一貫性を維持するため、空間的注意機構を用いて詳細な特徴を統合するReferenceNetを設計しました。制御可能性と連続性を確保するため、キャラクタの動作をガイドする効率的なポーズガイド機構を導入し、ビデオフレーム間の滑らかなクロスフェードを実現する効果的な時間モデリング手法を採用しています。トレーニングデータの拡張により、任意のキャラクタのアニメーション作成が可能になり、他の画像からビデオへの変換手法と比較して、キャラクタアニメーションにおいて優れた結果を得ています。さらに、ファッションビデオと人間のダンス合成のベンチマークにおいて最先端の結果を達成しました。

AI動画生成

11.4M