Mimicmotion

简介 :

MimicMotion是由腾讯公司和上海交通大学联合研发的高质量人体动作视频生成模型。该模型通过信心感知的姿态引导,实现了对视频生成过程的可控性,提高了视频的时序平滑性,并减少了图像失真。它采用了先进的图像到视频的扩散模型,结合了时空U-Net和PoseNet,能够根据姿势序列条件生成任意长度的高质量视频。MimicMotion在多个方面显著优于先前的方法,包括手部生成质量、对参考姿势的准确遵循等。

需求人群 :

MimicMotion的目标受众是视频制作者、动画师和AI研究人员。该技术能够帮助他们生成高质量的视频内容,特别是在需要复杂人体动作和时序连贯性的场景中。例如,它可用于电影后期制作、虚拟现实体验、游戏动画和AI研究等领域。

使用场景

生成舞蹈视频,展示流畅的人体动作和表情。

创建虚拟现实中的交互式角色,具有逼真的动作和反应。

在游戏开发中,为角色设计动态和响应性动作。

产品特色

信心感知姿态引导,根据姿势估计的置信度调整影响。

基于姿势置信度的区域损失放大,显著减少图像失真。

渐进式潜在融合策略,生成具有时序平滑性的长视频。

重叠扩散技术,用于生成任意长度的视频。

用户研究显示,MimicMotion在TikTok数据集测试集上优于基线方法。

消融研究证明了信心感知姿态引导和手部区域增强的有效性。

使用教程

1. 准备输入参考图像和姿势序列。

2. 使用MimicMotion模型进行视频生成。

3. 根据需要调整信心感知姿态引导的参数。

4. 应用区域损失放大策略,优化特定区域的图像质量。

5. 利用渐进式潜在融合策略生成长视频。

6. 通过重叠扩散技术生成任意长度的视频。

7. 进行用户研究和消融研究,评估和改进视频生成效果。

精选AI产品推荐

Sora

Sora是一个基于大规模训练的文本控制视频生成扩散模型。它能够生成长达1分钟的高清视频,涵盖广泛的视觉数据类型和分辨率。Sora通过在视频和图像的压缩潜在空间中训练,将其分解为时空位置补丁,实现了可扩展的视频生成。Sora还展现出一些模拟物理世界和数字世界的能力,如三维一致性和交互,揭示了继续扩大视频生成模型规模来发展高能力模拟器的前景。

AI视频生成

17.2M

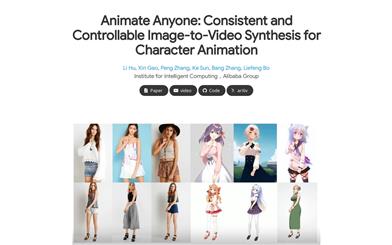

Animate Anyone

Animate Anyone旨在通过驱动信号从静态图像生成角色视频。我们利用扩散模型的力量,提出了一个专为角色动画量身定制的新框架。为了保持参考图像中复杂外观特征的一致性,我们设计了ReferenceNet来通过空间注意力合并详细特征。为了确保可控性和连续性,我们引入了一个高效的姿势指导器来指导角色的动作,并采用了一种有效的时间建模方法,以确保视频帧之间的平滑跨帧过渡。通过扩展训练数据,我们的方法可以为任意角色制作动画,与其他图像到视频方法相比,在角色动画方面取得了出色的结果。此外,我们在时尚视频和人类舞蹈合成的基准上评估了我们的方法,取得了最先进的结果。

AI视频生成

11.8M