Wan2.1 T2V 14B

简介 :

Wan2.1-T2V-14B 是一款先进的文本到视频生成模型,基于扩散变换器架构,结合了创新的时空变分自编码器(VAE)和大规模数据训练。它能够在多种分辨率下生成高质量的视频内容,支持中文和英文文本输入,并在性能和效率上超越现有的开源和商业模型。该模型适用于需要高效视频生成的场景,如内容创作、广告制作和视频编辑等。目前该模型在 Hugging Face 平台上免费提供,旨在推动视频生成技术的发展和应用。

需求人群 :

该模型适用于需要高效生成高质量视频内容的创作者、广告商、视频编辑人员以及研究人员。它能够快速将文本或图像转化为生动的视频,节省创作时间和成本,同时支持多种语言输入,拓宽了其在全球范围内的应用前景。

使用场景

根据输入的文本描述生成一段 5 秒的 480P 视频

将静态图像转化为具有动态效果的视频

结合文本提示生成包含中文或英文文字的视频内容

产品特色

支持文本到视频、图像到视频等多种视频生成任务

支持 480P 和 720P 分辨率的视频生成

具备强大的时空压缩能力,可高效处理 1080P 视频

支持中文和英文文本输入,拓展应用场景

提供单 GPU 和多 GPU 推理代码,适应不同硬件需求

使用教程

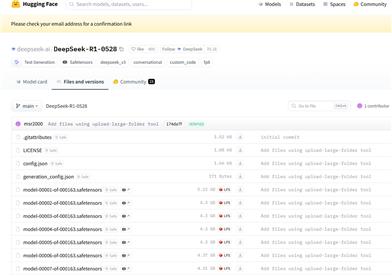

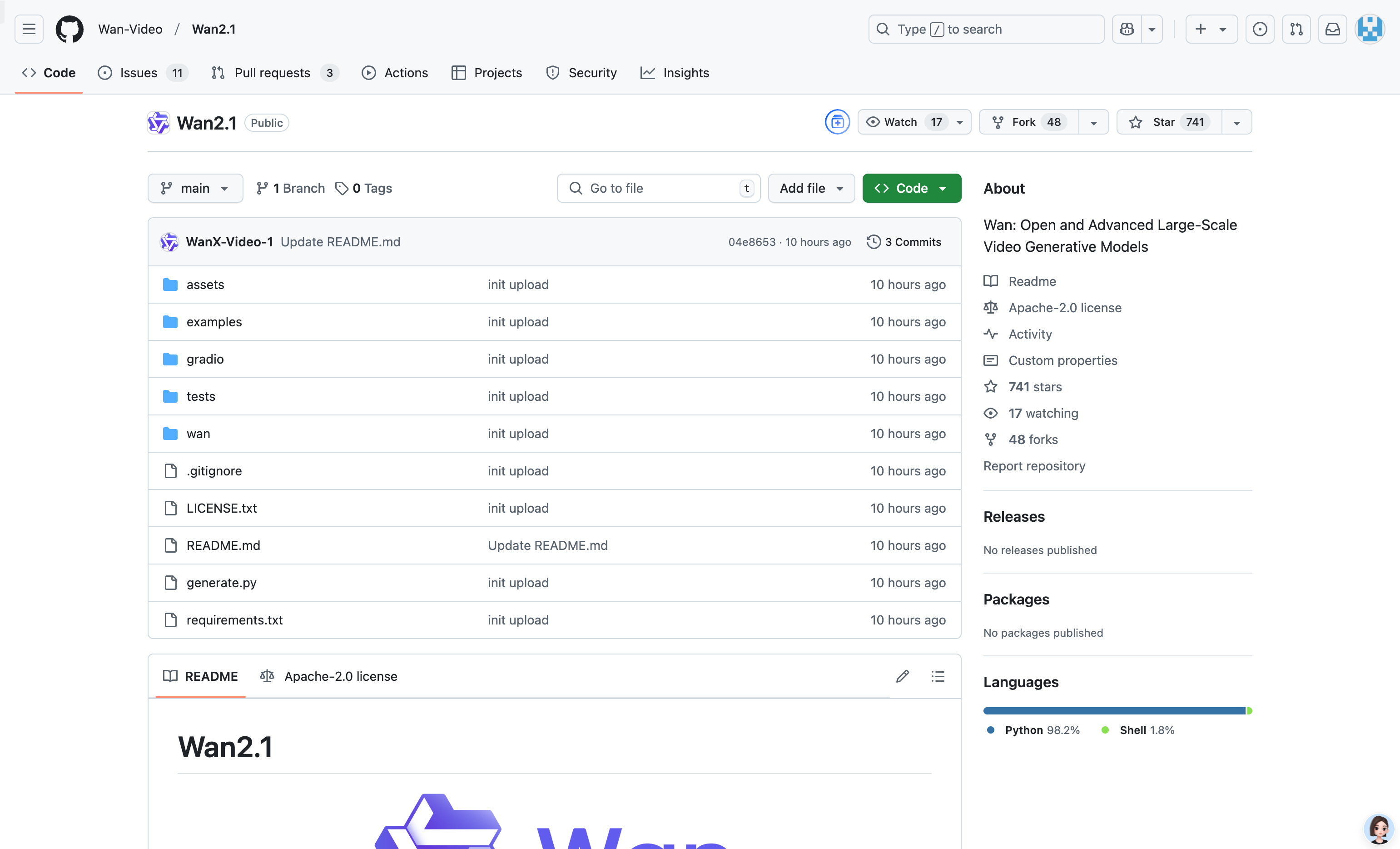

1. 克隆项目仓库:`git clone https://github.com/Wan-Video/Wan2.1.git`

2. 安装依赖:`pip install -r requirements.txt`

3. 下载模型权重:`huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir ./Wan2.1-T2V-14B`

4. 运行文本到视频生成:`python generate.py --task t2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-T2V-14B --prompt '描述文本'`

5. 根据需要调整参数,如分辨率、提示文本等

精选AI产品推荐

国外精选

Pika

Pika是一个视频制作平台,用户可以上传自己的创意想法,Pika会自动生成相关的视频。主要功能有:支持多种创意想法转视频,视频效果专业,操作简单易用。平台采用免费试用模式,定位面向创意者和视频爱好者。

视频生成

18.7M

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系统。它能够进行多模态推理,支持文本、图像、视频、音频和代码之间的无缝交互。Gemini在语言理解、推理、数学、编程等多个领域都超越了之前的状态,成为迄今为止最强大的AI系统之一。它有三个不同规模的版本,可满足从边缘计算到云计算的各种需求。Gemini可以广泛应用于创意设计、写作辅助、问题解答、代码生成等领域。

AI模型

11.4M