Internvl2 5 26B

简介 :

InternVL2_5-26B是一个先进的多模态大型语言模型(MLLM),在InternVL 2.0的基础上,通过引入显著的训练和测试策略增强以及数据质量提升,进一步发展而来。该模型保持了其前身的“ViT-MLP-LLM”核心模型架构,并集成了新增量预训练的InternViT与各种预训练的大型语言模型(LLMs),例如InternLM 2.5和Qwen 2.5,使用随机初始化的MLP投影器。InternVL 2.5系列模型在多模态任务中展现出卓越的性能,尤其在视觉感知和多模态能力方面。

需求人群 :

目标受众为研究人员、开发者和企业,特别是那些需要在多模态任务中结合视觉和语言信息以提升性能的用户。InternVL2_5-26B因其先进的模型架构和强大的多模态处理能力,适合于需要进行图像识别、视频理解和多语言交互的复杂应用场景。

使用场景

使用InternVL2_5-26B进行图像描述和理解,提升图像检索系统的准确性。

在视频内容分析中应用InternVL2_5-26B,实现视频内容的自动标注和分类。

通过InternVL2_5-26B进行多语言图像标注,增强跨语言的图像识别能力。

产品特色

• 模型架构:遵循'ViT-MLP-LLM'范式,集成了视觉Transformer和语言模型。

• 训练策略:包括动态高分辨率训练方法,以及分阶段训练以增强模型的视觉感知和多模态能力。

• 多模态理解:支持图像、视频和多语言数据,提供综合的多模态和幻觉评估。

• 数据组织:通过关键参数控制训练数据的组织,优化数据平衡和分布。

• 快速启动:提供示例代码,方便用户使用transformers库快速运行模型。

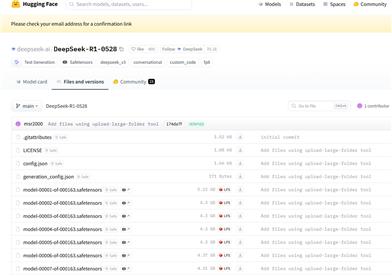

• 微调与部署:支持模型的微调和部署,使用LMDeploy工具包简化部署流程。

• 多轮对话:支持基于图像和视频的多轮对话,增强交互体验。

使用教程

1. 安装transformers库:确保已安装transformers库,版本需大于等于4.37.2。

2. 加载模型:使用AutoModel.from_pretrained方法加载InternVL2_5-26B模型。

3. 数据预处理:对输入的图像或视频数据进行必要的预处理,包括尺寸调整和归一化。

4. 模型推理:将预处理后的数据输入模型,进行推理以获取结果。

5. 结果分析:根据模型输出的结果进行分析,应用于具体的业务场景。

6. 微调模型:如有需要,可以在特定数据集上对模型进行微调,以适应特定的应用需求。

7. 部署模型:使用LMDeploy工具包将模型部署为服务,提供API接口供其他应用调用。

精选AI产品推荐

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系统。它能够进行多模态推理,支持文本、图像、视频、音频和代码之间的无缝交互。Gemini在语言理解、推理、数学、编程等多个领域都超越了之前的状态,成为迄今为止最强大的AI系统之一。它有三个不同规模的版本,可满足从边缘计算到云计算的各种需求。Gemini可以广泛应用于创意设计、写作辅助、问题解答、代码生成等领域。

AI模型

11.4M

中文精选

Liblibai

LiblibAI是一个中国领先的AI创作平台,提供强大的AI创作能力,帮助创作者实现创意。平台提供海量免费AI创作模型,用户可以搜索使用模型进行图像、文字、音频等创作。平台还支持用户训练自己的AI模型。平台定位于广大创作者用户,致力于创造条件普惠,服务创意产业,让每个人都享有创作的乐趣。

AI模型

8.0M