Llama 3.1 Nemotron 70B Instruct

简介 :

Llama-3.1-Nemotron-70B-Instruct是NVIDIA定制的大型语言模型,专注于提升大型语言模型(LLM)生成回答的帮助性。该模型在多个自动对齐基准测试中表现优异,例如Arena Hard、AlpacaEval 2 LC和GPT-4-Turbo MT-Bench。它通过使用RLHF(特别是REINFORCE算法)、Llama-3.1-Nemotron-70B-Reward和HelpSteer2-Preference提示在Llama-3.1-70B-Instruct模型上进行训练。此模型不仅展示了NVIDIA在提升通用领域指令遵循帮助性方面的技术,还提供了与HuggingFace Transformers代码库兼容的模型转换格式,并可通过NVIDIA的build平台进行免费托管推理。

需求人群 :

目标受众为需要利用先进大型语言模型进行文本生成和查询回答的研究人员、开发者和企业。由于模型在多个基准测试中表现出色,特别适合那些寻求提升文本生成准确性和帮助性的用户。此外,对于希望利用NVIDIA GPU优化其AI应用性能的用户,此模型也是一个理想选择。

使用场景

研究人员使用此模型在自然语言处理任务中生成更准确的回答。

开发者将模型集成到聊天机器人中,以提供更自然和有帮助的对话体验。

企业使用模型优化客户服务系统,通过自动回答常见问题来提升客户满意度。

产品特色

在Arena Hard、AlpacaEval 2 LC和MT-Bench基准测试中表现优异。

使用RLHF和REINFORCE算法进行训练,提高回答的准确性和帮助性。

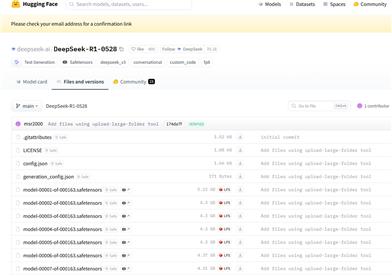

提供了与HuggingFace Transformers代码库兼容的模型转换格式。

可通过NVIDIA的build平台进行免费托管推理,具有OpenAI兼容的API接口。

模型在处理通用领域指令时表现出色,尽管未针对特定领域如数学进行优化。

支持通过NVIDIA NeMo Framework进行部署,该框架基于NVIDIA TRT-LLM提供高吞吐量和低延迟的推理解决方案。

需要至少4个40GB或2个80GB的NVIDIA GPU以及150GB的空闲磁盘空间。

使用教程

1. 注册并获取NVIDIA NeMo Framework容器的免费且立即访问权限。

2. 如果没有NVIDIA NGC API密钥,登录NVIDIA NGC生成API密钥。

3. 使用docker登录nvcr.io并拉取所需的容器。

4. 下载模型的checkpoint。

5. 运行Docker容器,并设置环境变量HF_HOME。

6. 在容器内启动服务器,进行模型转换和部署。

7. 服务器准备就绪后,使用客户端代码进行查询。

精选AI产品推荐

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系统。它能够进行多模态推理,支持文本、图像、视频、音频和代码之间的无缝交互。Gemini在语言理解、推理、数学、编程等多个领域都超越了之前的状态,成为迄今为止最强大的AI系统之一。它有三个不同规模的版本,可满足从边缘计算到云计算的各种需求。Gemini可以广泛应用于创意设计、写作辅助、问题解答、代码生成等领域。

AI模型

11.4M

中文精选

Liblibai

LiblibAI是一个中国领先的AI创作平台,提供强大的AI创作能力,帮助创作者实现创意。平台提供海量免费AI创作模型,用户可以搜索使用模型进行图像、文字、音频等创作。平台还支持用户训练自己的AI模型。平台定位于广大创作者用户,致力于创造条件普惠,服务创意产业,让每个人都享有创作的乐趣。

AI模型

8.0M