Llama 3.1 Nemotron 70B Instruct

簡介 :

Llama-3.1-Nemotron-70B-Instruct是NVIDIA定製的大型語言模型,專注於提升大型語言模型(LLM)生成回答的幫助性。該模型在多個自動對齊基準測試中表現優異,例如Arena Hard、AlpacaEval 2 LC和GPT-4-Turbo MT-Bench。它通過使用RLHF(特別是REINFORCE算法)、Llama-3.1-Nemotron-70B-Reward和HelpSteer2-Preference提示在Llama-3.1-70B-Instruct模型上進行訓練。此模型不僅展示了NVIDIA在提升通用領域指令遵循幫助性方面的技術,還提供了與HuggingFace Transformers代碼庫兼容的模型轉換格式,並可通過NVIDIA的build平臺進行免費託管推理。

需求人群 :

目標受眾為需要利用先進大型語言模型進行文本生成和查詢回答的研究人員、開發者和企業。由於模型在多個基準測試中表現出色,特別適合那些尋求提升文本生成準確性和幫助性的用戶。此外,對於希望利用NVIDIA GPU優化其AI應用性能的用戶,此模型也是一個理想選擇。

使用場景

研究人員使用此模型在自然語言處理任務中生成更準確的回答。

開發者將模型集成到聊天機器人中,以提供更自然和有幫助的對話體驗。

企業使用模型優化客戶服務系統,通過自動回答常見問題來提升客戶滿意度。

產品特色

在Arena Hard、AlpacaEval 2 LC和MT-Bench基準測試中表現優異。

使用RLHF和REINFORCE算法進行訓練,提高回答的準確性和幫助性。

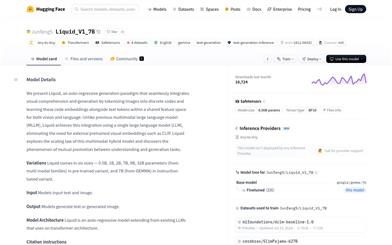

提供了與HuggingFace Transformers代碼庫兼容的模型轉換格式。

可通過NVIDIA的build平臺進行免費託管推理,具有OpenAI兼容的API接口。

模型在處理通用領域指令時表現出色,儘管未針對特定領域如數學進行優化。

支持通過NVIDIA NeMo Framework進行部署,該框架基於NVIDIA TRT-LLM提供高吞吐量和低延遲的推理解決方案。

需要至少4個40GB或2個80GB的NVIDIA GPU以及150GB的空閒磁盤空間。

使用教程

1. 註冊並獲取NVIDIA NeMo Framework容器的免費且立即訪問權限。

2. 如果沒有NVIDIA NGC API密鑰,登錄NVIDIA NGC生成API密鑰。

3. 使用docker登錄nvcr.io並拉取所需的容器。

4. 下載模型的checkpoint。

5. 運行Docker容器,並設置環境變量HF_HOME。

6. 在容器內啟動服務器,進行模型轉換和部署。

7. 服務器準備就緒後,使用客戶端代碼進行查詢。

精選AI產品推薦

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系統。它能夠進行多模態推理,支持文本、圖像、視頻、音頻和代碼之間的無縫交互。Gemini在語言理解、推理、數學、編程等多個領域都超越了之前的狀態,成為迄今為止最強大的AI系統之一。它有三個不同規模的版本,可滿足從邊緣計算到雲計算的各種需求。Gemini可以廣泛應用於創意設計、寫作輔助、問題解答、代碼生成等領域。

AI模型

11.4M

中文精選

Liblibai

LiblibAI是一箇中國領先的AI創作平臺,提供強大的AI創作能力,幫助創作者實現創意。平臺提供海量免費AI創作模型,用戶可以搜索使用模型進行圖像、文字、音頻等創作。平臺還支持用戶訓練自己的AI模型。平臺定位於廣大創作者用戶,致力於創造條件普惠,服務創意產業,讓每個人都享有創作的樂趣。

AI模型

8.0M