Segment Anything Model 2

简介 :

Segment Anything Model 2 (SAM 2)是Meta公司AI研究部门FAIR推出的一个视觉分割模型,它通过简单的变换器架构和流式内存设计,实现实时视频处理。该模型通过用户交互构建了一个模型循环数据引擎,收集了迄今为止最大的视频分割数据集SA-V。SAM 2在该数据集上训练,提供了在广泛任务和视觉领域中的强大性能。

需求人群 :

SAM 2适用于需要在图像和视频中进行视觉分割的研究者和开发者,特别是那些对实时视频处理有需求的用户。它的强大性能和易用性使其成为相关领域的优选工具。

使用场景

使用SAM 2进行图像分割的学术研究。

在视频编辑软件中集成SAM 2以实现自动对象分割。

利用SAM 2进行自动驾驶车辆的视觉数据处理。

产品特色

支持静态图像和视频的视觉分割。

提供简单的图像预测API接口。

支持自动在图像上生成遮罩。

支持视频预测,包括多对象分割和追踪。

支持在视频预测中添加提示并传播遮罩。

提供编译模型以提高速度。

提供了详细的安装和使用指南。

使用教程

1. 使用git克隆SAM 2的代码库到本地。

2. 安装必要的依赖并设置SAM 2环境。

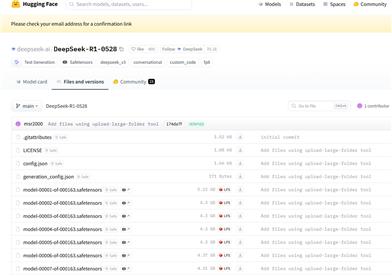

3. 下载并加载预训练的模型检查点。

4. 使用提供的API接口进行图像或视频的分割预测。

5. 根据需要调整模型配置以优化性能。

6. 通过Jupyter Notebook查看示例并进行实验。

精选AI产品推荐

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系统。它能够进行多模态推理,支持文本、图像、视频、音频和代码之间的无缝交互。Gemini在语言理解、推理、数学、编程等多个领域都超越了之前的状态,成为迄今为止最强大的AI系统之一。它有三个不同规模的版本,可满足从边缘计算到云计算的各种需求。Gemini可以广泛应用于创意设计、写作辅助、问题解答、代码生成等领域。

AI模型

11.4M

中文精选

Liblibai

LiblibAI是一个中国领先的AI创作平台,提供强大的AI创作能力,帮助创作者实现创意。平台提供海量免费AI创作模型,用户可以搜索使用模型进行图像、文字、音频等创作。平台还支持用户训练自己的AI模型。平台定位于广大创作者用户,致力于创造条件普惠,服务创意产业,让每个人都享有创作的乐趣。

AI模型

8.0M