使用场景

使用Mamba进行Temporal Action Localization以提高动作识别的准确性。

集成Video Temporal Grounding模型以增强视频内容的交互式分析。

利用Video Mamba Suite进行Long-form Video Question-Answer任务,提升视频问答系统的智能度。

产品特色

视频时间建模:用于时间动作定位、时间动作分割、视频密集字幕生成等任务。

跨模态交互:实现视频时间定位和高亮检测等交互式任务。

视频时间适配器:支持零样本/微调多实例检索和微调动作识别。

空间-时间建模:提供零样本/微调多实例检索和微调动作识别功能。

模型动物园:包含多种预训练模型,如TimeSformer-B、CLIP-400M、Ego4D-4M等。

使用教程

步骤1:克隆Video Mamba Suite的代码库到本地。

步骤2:创建并激活Python 3.9环境。

步骤3:安装PyTorch及相关依赖库。

步骤4:根据requirements.txt安装其他必要的Python库。

步骤5:进入causal-conv1d和mamba目录,分别运行setup.py进行开发环境设置。

步骤6:根据具体任务的文件夹中的安装指南进行操作。

步骤7:运行相关脚本或命令,开始使用Video Mamba Suite进行视频理解任务。

精选AI产品推荐

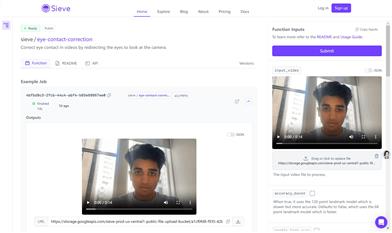

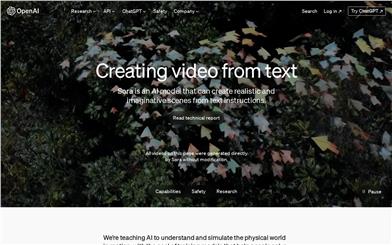

Sora

Sora是一个基于大规模训练的文本控制视频生成扩散模型。它能够生成长达1分钟的高清视频,涵盖广泛的视觉数据类型和分辨率。Sora通过在视频和图像的压缩潜在空间中训练,将其分解为时空位置补丁,实现了可扩展的视频生成。Sora还展现出一些模拟物理世界和数字世界的能力,如三维一致性和交互,揭示了继续扩大视频生成模型规模来发展高能力模拟器的前景。

AI视频生成

17.2M

Animate Anyone

Animate Anyone旨在通过驱动信号从静态图像生成角色视频。我们利用扩散模型的力量,提出了一个专为角色动画量身定制的新框架。为了保持参考图像中复杂外观特征的一致性,我们设计了ReferenceNet来通过空间注意力合并详细特征。为了确保可控性和连续性,我们引入了一个高效的姿势指导器来指导角色的动作,并采用了一种有效的时间建模方法,以确保视频帧之间的平滑跨帧过渡。通过扩展训练数据,我们的方法可以为任意角色制作动画,与其他图像到视频方法相比,在角色动画方面取得了出色的结果。此外,我们在时尚视频和人类舞蹈合成的基准上评估了我们的方法,取得了最先进的结果。

AI视频生成

11.8M