Videorag

VideoRAG 是一種創新的檢索增強型生成框架,專門用於理解和處理極長上下文視頻。它通過結合圖驅動的文本知識錨定和層次化多模態上下文編碼,實現了對無限制長度視頻的理解。該框架能夠動態構建知識圖譜,保持多視頻上下文的語義連貫性,並通過自適應多模態融合機制優化檢索效率。VideoRAG 的主要優點包括高效的極長上下文視頻處理能力、結構化的視頻知識索引以及多模態檢索能力,使其能夠為複雜查詢提供全面的回答。該框架在長視頻理解領域具有重要的技術價值和應用前景。

視頻編輯

54.6K

中文精選

Qwen2.5 VL

Qwen2.5-VL 是 Qwen 團隊推出的最新旗艦視覺語言模型,是視覺語言模型領域的重要進步。它不僅能夠識別常見物體,還能分析圖像中的文字、圖表、圖標等複雜內容,並支持對長視頻的理解和事件定位。該模型在多個基準測試中表現出色,尤其在文檔理解和視覺代理任務中具有顯著優勢,展現了強大的視覺理解和推理能力。其主要優點包括高效的多模態理解、強大的長視頻處理能力以及靈活的工具調用能力,適用於多種應用場景。

AI模型

119.2K

Tarsier

Tarsier 是由字節跳動研究團隊開發的一系列大規模視頻語言模型,旨在生成高質量的視頻描述,並具備強大的視頻理解能力。該模型通過兩階段訓練策略(多任務預訓練和多粒度指令微調)顯著提升了視頻描述的精度和細節。其主要優點包括高精度的視頻描述能力、對複雜視頻內容的理解能力以及在多個視頻理解基準測試中取得的 SOTA(State-of-the-Art)結果。Tarsier 的背景基於對現有視頻語言模型在描述細節和準確性上的不足進行改進,通過大規模高質量數據訓練和創新的訓練方法,使其在視頻描述領域達到了新的高度。該模型目前未明確定價,主要面向學術研究和商業應用,適合需要高質量視頻內容理解和生成的場景。

視頻生成

80.3K

Videollama3

VideoLLaMA3是由DAMO-NLP-SG團隊開發的前沿多模態基礎模型,專注於圖像和視頻理解。該模型基於Qwen2.5架構,結合了先進的視覺編碼器(如SigLip)和強大的語言生成能力,能夠處理複雜的視覺和語言任務。其主要優點包括高效的時空建模能力、強大的多模態融合能力以及對大規模數據的優化訓練。該模型適用於需要深度視頻理解的應用場景,如視頻內容分析、視覺問答等,具有廣泛的研究和商業應用潛力。

視頻生成

54.9K

Omagent.com

OmAgent是一個多模態原生代理框架,用於智能設備等。它採用分治算法高效解決複雜任務,能預處理長視頻並以類似人類的精度進行問答,還能基於用戶請求和可選天氣條件提供個性化服裝建議等。目前官網未明確顯示價格,但從功能來看,主要面向需要高效任務處理和智能交互的用戶群體,如開發者、企業等。

智能體

46.6K

Videoprompt.org

videoprompt.org是一個專注於AI視頻生成提示的網站,提供了一系列用於生成、編輯或理解視頻內容的指令集。它通過精選的高質量提示集合、社區驅動的方法和對實際應用的關注,幫助用戶解鎖AI模型在視頻處理中的全部潛力,提高視頻製作工作流程的效率,並實現一致的高質量結果。

視頻生成

61.0K

Apollo LMMs

Apollo是一個專注於視頻理解的先進大型多模態模型家族。它通過系統性地探索視頻-LMMs的設計空間,揭示了驅動性能的關鍵因素,提供了優化模型性能的實用見解。Apollo通過發現'Scaling Consistency',使得在較小模型和數據集上的設計決策能夠可靠地轉移到更大的模型上,大幅降低計算成本。Apollo的主要優點包括高效的設計決策、優化的訓練計劃和數據混合,以及一個新型的基準測試ApolloBench,用於高效評估。

視頻生成

51.3K

Qwen2 VL 7B

Qwen2-VL-7B是Qwen-VL模型的最新迭代,代表了近一年的創新成果。該模型在視覺理解基準測試中取得了最先進的性能,包括MathVista、DocVQA、RealWorldQA、MTVQA等。它能夠理解超過20分鐘的視頻,為基於視頻的問題回答、對話、內容創作等提供高質量的支持。此外,Qwen2-VL還支持多語言,除了英語和中文,還包括大多數歐洲語言、日語、韓語、阿拉伯語、越南語等。模型架構更新包括Naive Dynamic Resolution和Multimodal Rotary Position Embedding (M-ROPE),增強了其多模態處理能力。

AI模型

52.4K

Qwen2 VL 2B

Qwen2-VL-2B是Qwen-VL模型的最新迭代,代表了近一年的創新成果。該模型在視覺理解基準測試中取得了最先進的性能,包括MathVista、DocVQA、RealWorldQA、MTVQA等。它能夠理解超過20分鐘的視頻,為基於視頻的問題回答、對話、內容創作等提供高質量的支持。Qwen2-VL還支持多語言,除了英語和中文,還包括大多數歐洲語言、日語、韓語、阿拉伯語、越南語等。模型架構更新包括Naive Dynamic Resolution和Multimodal Rotary Position Embedding (M-ROPE),增強了其多模態處理能力。

AI模型

57.1K

Ppllava

PPLLaVA是一個高效的視頻大型語言模型,它結合了細粒度視覺提示對齊、用戶指令的卷積風格池化的視覺令牌壓縮以及CLIP上下文擴展。該模型在VideoMME、MVBench、VideoChatGPT Bench和VideoQA Bench等數據集上建立了新的最先進結果,僅使用1024個視覺令牌,吞吐量提高了8倍。

視頻生成

48.6K

Longvu

LongVU是一種創新的長視頻語言理解模型,通過時空自適應壓縮機制減少視頻標記的數量,同時保留長視頻中的視覺細節。這一技術的重要性在於它能夠處理大量視頻幀,且在有限的上下文長度內僅損失少量視覺信息,顯著提升了長視頻內容理解和分析的能力。LongVU在多種視頻理解基準測試中均超越了現有方法,尤其是在理解長達一小時的視頻任務上。此外,LongVU還能夠有效地擴展到更小的模型尺寸,同時保持最先進的視頻理解性能。

模型訓練與部署

50.0K

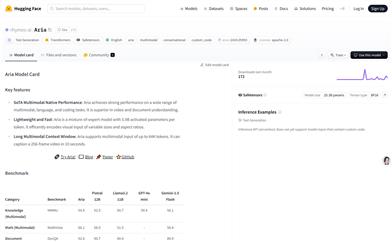

Aria

Aria是一個多模態原生混合專家模型,具有強大的多模態、語言和編碼任務性能。它在視頻和文檔理解方面表現出色,支持長達64K的多模態輸入,能夠在10秒內描述一個256幀的視頻。Aria模型的參數量為25.3B,能夠在單個A100(80GB)GPU上使用bfloat16精度進行加載。Aria的開發背景是滿足對多模態數據理解的需求,特別是在視頻和文檔處理方面。它是一個開源模型,旨在推動多模態人工智能的發展。

AI模型

55.8K

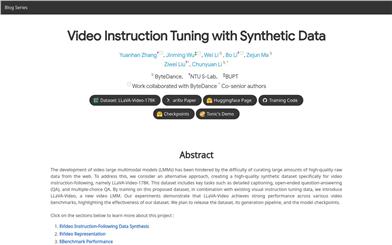

Llava Video

LLaVA-Video是一個專注於視頻指令調優的大型多模態模型(LMMs),通過創建高質量的合成數據集LLaVA-Video-178K來解決從網絡獲取大量高質量原始數據的難題。該數據集包括詳細的視頻描述、開放式問答和多項選擇問答等任務,旨在提高視頻語言模型的理解和推理能力。LLaVA-Video模型在多個視頻基準測試中表現出色,證明了其數據集的有效性。

AI模型

55.8K

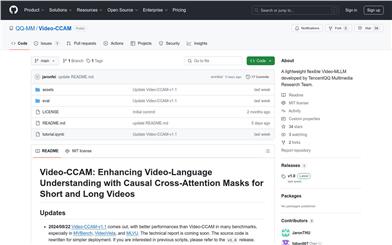

Video CCAM

Video-CCAM 是騰訊QQ多媒體研究團隊開發的一系列靈活的視頻多語言模型(Video-MLLM),致力於提升視頻-語言理解能力,特別適用於短視頻和長視頻的分析。它通過因果交叉注意力掩碼(Causal Cross-Attention Masks)來實現這一目標。Video-CCAM 在多個基準測試中表現優異,特別是在 MVBench、VideoVista 和 MLVU 上。模型的源代碼已經重寫,以簡化部署過程。

AI視頻生成

58.2K

Goldfish

Goldfish 是一種為理解任意長度視頻而設計的方法論。它通過高效的檢索機制,首先收集與指令相關的前k個視頻片段,然後提供所需的響應。這種設計使得Goldfish能夠有效處理任意長的視頻序列,適用於電影或電視劇等場景。為了促進檢索過程,開發了MiniGPT4-Video,該模型為視頻片段生成詳細的描述。Goldfish在長視頻基準測試中取得了41.78%的準確率,超過了之前的方法14.94%。此外,MiniGPT4-Video在短視頻理解中也表現出色,分別在MSVD、MSRVTT、TGIF和TVQA短視頻基準測試中超過了現有最佳方法3.23%、2.03%、16.5%和23.59%。這些結果表明,Goldfish模型在長視頻和短視頻理解方面都有顯著改進。

AI視頻搜索

54.9K

優質新品

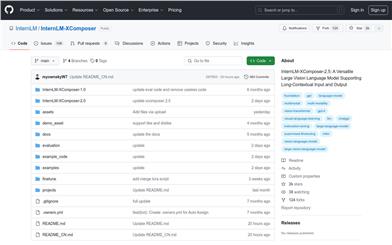

Internlm XComposer 2.5

InternLM-XComposer-2.5是一款支持長上下文輸入和輸出的多功能大型視覺語言模型。它在各種文本圖像理解和創作應用中表現出色,實現了與GPT-4V相當的水平,但僅使用了7B的LLM後端。該模型通過24K交錯圖像文本上下文進行訓練,能夠無縫擴展到96K長上下文,通過RoPE外推。這種長上下文能力使其在需要廣泛輸入和輸出上下文的任務中表現突出。此外,它還支持超高分辨率理解、細粒度視頻理解、多輪多圖像對話、網頁製作以及撰寫高質量圖文文章等功能。

AI模型

73.7K

Sharegpt4video

ShareGPT4Video系列旨在通過密集且精確的字幕來促進大型視頻-語言模型(LVLMs)的視頻理解以及文本到視頻模型(T2VMs)的視頻生成。該系列包括:1) ShareGPT4Video,40K GPT4V註釋的密集視頻字幕,通過精心設計的數據過濾和註釋策略開發而成。2) ShareCaptioner-Video,一個高效且功能強大的任意視頻字幕模型,由其註釋的4.8M高質量美學視頻。3) ShareGPT4Video-8B,一個簡單但卓越的LVLM,其在三個先進的視頻基準測試中達到了最佳性能。

AI視頻生成

74.5K

Videollama2 7B

VideoLLaMA2-7B是由DAMO-NLP-SG團隊開發的多模態大型語言模型,專注於視頻內容的理解和生成。該模型在視覺問答和視頻字幕生成方面具有顯著的性能,能夠處理複雜的視頻內容,並生成準確、自然的語言描述。它在空間-時間建模和音頻理解方面進行了優化,為視頻內容的智能分析和處理提供了強大的支持。

AI視頻生成

75.3K

優質新品

Lvbench

LVBench是一個專門設計用於長視頻理解的基準測試,旨在推動多模態大型語言模型在理解數小時長視頻方面的能力,這對於長期決策制定、深入電影評論和討論、現場體育解說等實際應用至關重要。

AI模型

55.8K

Videollama 2

VideoLLaMA 2 是一個針對視頻理解任務優化的大規模語言模型,它通過先進的空間-時間建模和音頻理解能力,提升了對視頻內容的解析和理解。該模型在多選視頻問答和視頻字幕生成等任務上展現了卓越的性能。

AI視頻理解

85.8K

VILA

VILA是一個預訓練的視覺語言模型(VLM),它通過大規模的交錯圖像-文本數據進行預訓練,從而實現視頻理解和多圖像理解能力。VILA通過AWQ 4bit量化和TinyChat框架在邊緣設備上可部署。主要優點包括:1) 交錯圖像-文本數據對於提升性能至關重要;2) 在交錯圖像-文本預訓練期間不凍結大型語言模型(LLM)可以促進上下文學習;3) 重新混合文本指令數據對於提升VLM和純文本性能至關重要;4) 標記壓縮可以擴展視頻幀數。VILA展示了包括視頻推理、上下文學習、視覺思維鏈和更好的世界知識等引人入勝的能力。

AI模型

91.4K

Video Mamba Suite

Video Mamba Suite 是一個用於視頻理解的新型狀態空間模型套件,旨在探索和評估Mamba在視頻建模中的潛力。該套件包含14個模型/模塊,覆蓋12個視頻理解任務,展示了在視頻和視頻-語言任務中的高效性能和優越性。

AI視頻生成

68.4K

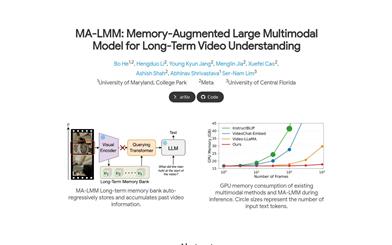

MA LMM

MA-LMM是一種基於大語言模型的大規模多模態模型,主要針對長期視頻理解進行設計。它採用在線處理視頻的方式,並使用記憶庫存儲過去的視頻信息,從而可以在不超過語言模型上下文長度限制或GPU內存限制的情況下,參考歷史視頻內容進行長期分析。MA-LMM可以無縫集成到當前的多模態語言模型中,並在長視頻理解、視頻問答和視頻字幕等任務上取得了領先的性能。

AI視頻生成

75.1K

Minigpt4 Video

MiniGPT4-Video是為視頻理解設計的多模態大模型,能處理時態視覺數據和文本數據,配標題、宣傳語,適用於視頻問答。基於MiniGPT-v2,結合視覺主幹EVA-CLIP,訓練多階段階段,包括大規模視頻-文本預訓練和視頻問題解答微調。在MSVD、MSRVTT、TGIF和TVQA基準上取得顯著提升。定價未知。

AI視頻生成

106.8K

Videoprism

VideoPrism是一個通用的視頻編碼模型,能夠在各種視頻理解任務上取得領先的性能,包括分類、定位、檢索、字幕生成和問答等。其創新點在於預訓練的數據集非常大且多樣,包含3600萬高質量的視頻-文本對,以及5.82億帶有嘈雜文本的視頻剪輯。預訓練採用兩階段策略,先利用對比學習匹配視頻和文本,然後預測遮蔽的視頻塊,充分利用不同的監督信號。一個固定的VideoPrism模型可以直接適配到下游任務,並在30個視頻理解基準上刷新狀態最優成績。

AI視頻生成

91.9K

精選AI產品推薦

中文精選

騰訊混元圖像 2.0

騰訊混元圖像 2.0 是騰訊最新發布的 AI 圖像生成模型,顯著提升了生成速度和畫質。通過超高壓縮倍率的編解碼器和全新擴散架構,使得圖像生成速度可達到毫秒級,避免了傳統生成的等待時間。同時,模型通過強化學習算法與人類美學知識的結合,提升了圖像的真實感和細節表現,適合設計師、創作者等專業用戶使用。

圖片生成

80.6K

國外精選

Lovart

Lovart 是一款革命性的 AI 設計代理,能夠將創意提示轉化為藝術作品,支持從故事板到品牌視覺的多種設計需求。其重要性在於打破傳統設計流程,節省時間並提升創意靈感。Lovart 當前處於測試階段,用戶可加入等候名單,隨時體驗設計的樂趣。

AI設計工具

63.8K

Fastvlm

FastVLM 是一種高效的視覺編碼模型,專為視覺語言模型設計。它通過創新的 FastViTHD 混合視覺編碼器,減少了高分辨率圖像的編碼時間和輸出的 token 數量,使得模型在速度和精度上表現出色。FastVLM 的主要定位是為開發者提供強大的視覺語言處理能力,適用於各種應用場景,尤其在需要快速響應的移動設備上表現優異。

AI模型

51.1K

Keysync

KeySync 是一個針對高分辨率視頻的無洩漏唇同步框架。它解決了傳統唇同步技術中的時間一致性問題,同時通過巧妙的遮罩策略處理表情洩漏和麵部遮擋。KeySync 的優越性體現在其在唇重建和跨同步方面的先進成果,適用於自動配音等實際應用場景。

視頻編輯

48.3K

Manus

Manus 是由 Monica.im 研發的全球首款真正自主的 AI 代理產品,能夠直接交付完整的任務成果,而不僅僅是提供建議或答案。它採用 Multiple Agent 架構,運行在獨立虛擬機中,能夠通過編寫和執行代碼、瀏覽網頁、操作應用等方式直接完成任務。Manus 在 GAIA 基準測試中取得了 SOTA 表現,展現了強大的任務執行能力。其目標是成為用戶在數字世界的‘代理人’,幫助用戶高效完成各種複雜任務。

個人助理

1.5M

Trae國內版

Trae是一款專為中文開發場景設計的AI原生IDE,將AI技術深度集成於開發環境中。它通過智能代碼補全、上下文理解等功能,顯著提升開發效率和代碼質量。Trae的出現填補了國內AI集成開發工具的空白,滿足了中文開發者對高效開發工具的需求。其定位為高端開發工具,旨在為專業開發者提供強大的技術支持,目前尚未明確公開價格,但預計會採用付費模式以匹配其高端定位。

開發與工具

137.7K

國外精選

Pika

Pika是一個視頻製作平臺,用戶可以上傳自己的創意想法,Pika會自動生成相關的視頻。主要功能有:支持多種創意想法轉視頻,視頻效果專業,操作簡單易用。平臺採用免費試用模式,定位面向創意者和視頻愛好者。

視頻生成

18.7M

中文精選

Liblibai

LiblibAI是一箇中國領先的AI創作平臺,提供強大的AI創作能力,幫助創作者實現創意。平臺提供海量免費AI創作模型,用戶可以搜索使用模型進行圖像、文字、音頻等創作。平臺還支持用戶訓練自己的AI模型。平臺定位於廣大創作者用戶,致力於創造條件普惠,服務創意產業,讓每個人都享有創作的樂趣。

AI模型

8.0M