Woolyai

簡介 :

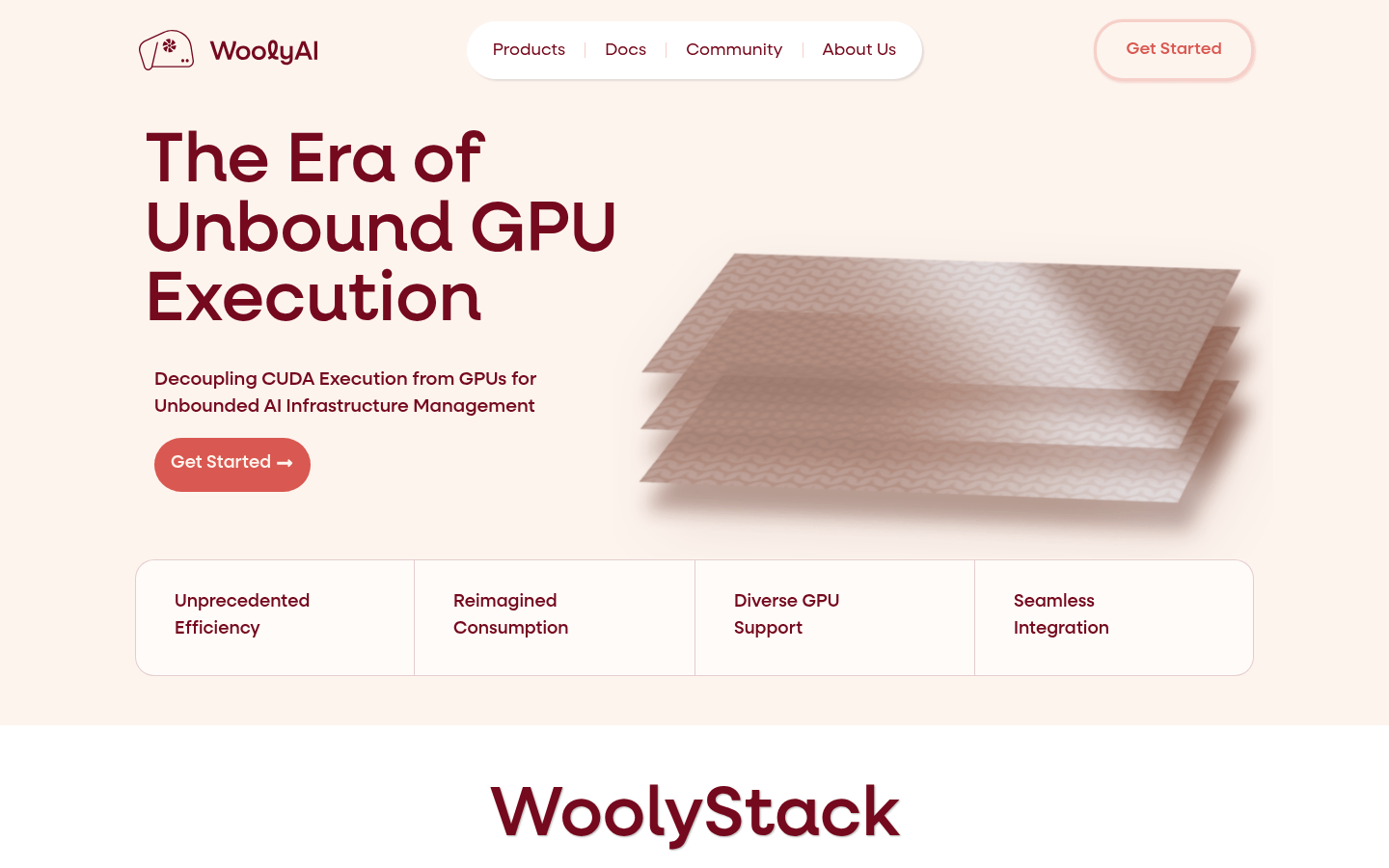

WoolyAI 是一種創新的 AI 基礎設施管理技術,通過其核心產品 WoolyStack,實現了將 CUDA 執行從 GPU 解耦,從而打破了傳統 GPU 資源管理的限制。該技術允許用戶在 CPU 基礎設施上運行 Pytorch 應用,並通過 Wooly 運行時庫將計算任務動態分配到遠程 GPU 資源。這種架構不僅提高了資源利用率,還降低了成本,並增強了隱私和安全性。其主要面向需要高效 GPU 資源管理的企業和開發者,尤其是在雲計算和 AI 開發場景中。

需求人群 :

該產品主要面向需要高效 GPU 資源管理的企業和開發者,尤其是那些在雲計算和 AI 開發場景中需要靈活、低成本且安全的 GPU 資源管理解決方案的用戶。通過 WoolyAI,用戶可以在不改變現有代碼的情況下,實現資源的高效利用和成本優化。

使用場景

一家 AI 初創公司通過 WoolyAI 在雲端高效運行其深度學習模型,無需購買昂貴的 GPU 設備。

某企業利用 WoolyAI 的按需計費模式,大幅降低了 GPU 資源的成本,同時提高了資源利用率。

開發者可以在本地 CPU 環境中開發 Pytorch 應用,通過 WoolyAI 無縫利用遠程 GPU 資源進行加速。

產品特色

支持在 CPU 基礎設施上運行 Pytorch 應用,無需本地 GPU。

通過 WoolyStack 技術實現 CUDA 的抽象化,將計算任務動態分配到遠程 GPU。

提供基於實際 GPU 資源使用量的計費模式,而非按時間計費。

支持多供應商 GPU 硬件,實現硬件無關性。

提供隔離執行環境,增強隱私和安全性。

動態資源分配與性能分析,優化資源利用率。

簡化管理流程,降低運維成本。

使用教程

1. 在 WoolyAI 官網註冊賬號並登錄。

2. 下載 Wooly Client 容器鏡像(如通過命令:docker pull woolyai/client:latest)。

3. 在本地 CPU 環境中運行 Wooly Client 容器,並將 Pytorch 應用部署其中。

4. 配置 Wooly Client 以連接到 WoolyAI 的遠程 GPU 服務。

5. 啟動 Pytorch 應用,WoolyAI 會自動將計算任務分配到遠程 GPU 資源。

6. 監控資源使用情況,並根據實際使用量支付費用。

精選AI產品推薦

Pseudoeditor

PseudoEditor是一款免費在線偽代碼編輯器。它具有語法高亮、自動完成等功能,幫助您更輕鬆地編寫偽代碼。您還可以使用我們的偽代碼編譯器功能進行測試。無需下載,即可立即使用。

開發與工具

4.5M

Erbuilder

Softbuilder的AI-powered ER diagrams generation是一款基於人工智能技術的數據建模工具,能夠根據自然語言的數據模型描述、用戶故事或需求自動生成ER圖。通過使用OpenAI GPT,它能夠快速生成精美的ER圖,大大提高了數據建模的效率。此外,它還提供數據模型文檔、驗證、探索等功能,可滿足各種數據建模需求。Softbuilder的AI-powered ER diagrams generation適用於各類企業和組織,幫助用戶輕鬆創建和管理數據模型。

開發與工具

4.1M