SWE Lancer

簡介 :

SWE-Lancer 是由 OpenAI 推出的一個基準測試,旨在評估前沿語言模型在真實世界中的自由軟件工程任務中的表現。該基準測試涵蓋了從 50 美元的漏洞修復到 32000 美元的功能實現等多種獨立工程任務,以及模型在技術實現方案之間的選擇等管理任務。通過模型將性能映射到貨幣價值,SWE-Lancer 為研究 AI 模型開發的經濟影響提供了新的視角,並推動了相關研究的發展。

需求人群 :

該產品主要面向研究人員、開發者和企業,幫助他們評估和研究 AI 模型在軟件工程領域的實際應用能力和經濟價值。通過 SWE-Lancer,他們可以更好地瞭解模型在解決真實世界軟件工程任務中的表現,從而推動技術的改進和創新,同時也為探索 AI 在軟件開發行業的經濟影響提供了有力工具。

使用場景

研究人員可以使用 SWE-Lancer 來評估不同 AI 模型在解決軟件工程任務中的性能差異,從而為模型的優化和改進提供依據。

開發者可以通過該基準測試瞭解 AI 模型在實際軟件開發任務中的表現,探索如何將 AI 技術更好地融入到開發流程中。

企業可以利用 SWE-Lancer 來評估 AI 模型在軟件工程任務中的經濟價值,判斷是否適合引入 AI 技術來提高開發效率和降低成本。

產品特色

提供超過 1400 個真實世界的自由軟件工程任務,涵蓋多種難度和價值範圍

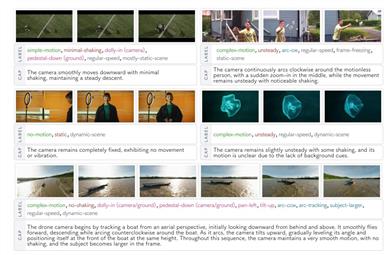

包含獨立工程任務和管理決策任務,全面評估模型能力

獨立任務通過經驗豐富的軟件工程師三重驗證的端到端測試進行評分

管理決策任務與原始僱傭的工程經理的選擇進行對比評估

開源統一的 Docker 鏡像和公共評估分割,便於未來研究

通過任務價值映射模型性能,直觀呈現 AI 模型的經濟潛力

支持對前沿模型在實際軟件工程任務中的表現進行量化分析

為研究人員提供標準化的測試環境和數據集,促進技術發展

使用教程

訪問 SWE-Lancer 的開源倉庫,獲取相關的 Docker 鏡像和測試數據集。

根據需要設置本地開發環境,確保 Docker 環境正常運行。

將待評估的 AI 模型接入到 SWE-Lancer 的測試框架中。

運行測試任務,模型將依次處理各個軟件工程任務。

查看測試結果,包括任務完成情況、評分以及與真實世界價值的映射。

根據測試結果分析模型的優勢和不足,為進一步的研究和開發提供參考。

精選AI產品推薦

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系統。它能夠進行多模態推理,支持文本、圖像、視頻、音頻和代碼之間的無縫交互。Gemini在語言理解、推理、數學、編程等多個領域都超越了之前的狀態,成為迄今為止最強大的AI系統之一。它有三個不同規模的版本,可滿足從邊緣計算到雲計算的各種需求。Gemini可以廣泛應用於創意設計、寫作輔助、問題解答、代碼生成等領域。

AI模型

11.4M

中文精選

Liblibai

LiblibAI是一箇中國領先的AI創作平臺,提供強大的AI創作能力,幫助創作者實現創意。平臺提供海量免費AI創作模型,用戶可以搜索使用模型進行圖像、文字、音頻等創作。平臺還支持用戶訓練自己的AI模型。平臺定位於廣大創作者用戶,致力於創造條件普惠,服務創意產業,讓每個人都享有創作的樂趣。

AI模型

8.0M