Trillium TPU

簡介 :

Trillium TPU是Google Cloud的第六代Tensor Processing Unit(TPU),專為AI工作負載設計,提供增強的性能和成本效益。它作為Google Cloud AI Hypercomputer的關鍵組件,通過集成的硬件系統、開放軟件、領先的機器學習框架和靈活的消費模型,支持大規模AI模型的訓練、微調和推理。Trillium TPU在性能、成本效率和可持續性方面都有顯著提升,是AI領域的重要進步。

需求人群 :

Trillium TPU的目標受眾是AI研究者、開發者和企業,特別是那些需要處理大規模AI模型訓練和推理的組織。它的強大性能和成本效益使其成為需要高效、可擴展AI解決方案的企業和研究者的理想選擇。

使用場景

AI21 Labs使用Trillium TPU加速其Mamba和Jamba語言模型的開發,提供更強大的AI解決方案。

Google使用Trillium TPUs訓練了最新的Gemini 2.0 AI模型,展示了其在AI模型訓練中的高性能。

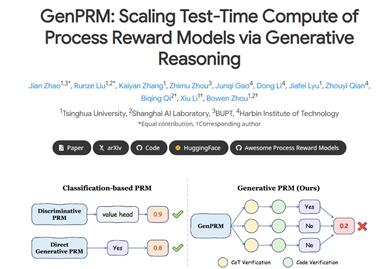

Trillium TPU在多步驟推理任務中表現出色,為圖像擴散和大型語言模型提供了顯著的推理性能提升。

產品特色

超過前一代4倍的訓練性能提升。

高達3倍的推理吞吐量增加。

能效提升67%。

每芯片峰值計算性能提升4.7倍。

高帶寬內存(HBM)容量翻倍。

芯片間互連(ICI)帶寬翻倍。

單個Jupiter網絡結構中可部署100K Trillium芯片。

訓練性能每美元提升高達2.5倍,推理性能每美元提升高達1.4倍。

使用教程

1. 登錄Google Cloud平臺並訪問Trillium TPU服務。

2. 創建或選擇一個項目,並確保項目具備使用Trillium TPU的權限。

3. 根據需要配置Trillium TPU資源,包括芯片數量和網絡結構。

4. 部署AI模型到Trillium TPU上,並開始訓練或推理任務。

5. 監控任務性能,利用Google Cloud提供的工具優化模型和資源使用。

6. 根據業務需求調整Trillium TPU資源配置,以實現成本和性能的最佳平衡。

7. 完成AI任務後,釋放不再需要的Trillium TPU資源以節省成本。

精選AI產品推薦

中文精選

Kimi K1.5

Kimi k1.5 是由 MoonshotAI 開發的多模態語言模型,通過強化學習和長上下文擴展技術,顯著提升了模型在複雜推理任務中的表現。該模型在多個基準測試中達到了行業領先水平,例如在 AIME 和 MATH-500 等數學推理任務中超越了 GPT-4o 和 Claude Sonnet 3.5。其主要優點包括高效的訓練框架、強大的多模態推理能力以及對長上下文的支持。Kimi k1.5 主要面向需要複雜推理和邏輯分析的應用場景,如編程輔助、數學解題和代碼生成等。

模型訓練與部署

285.7K

國外精選

Ollama

Ollama是一款本地大語言模型工具,讓用戶能夠快速運行Llama 2、Code Llama和其他模型。用戶可以自定義和創建他們自己的模型。Ollama目前支持macOS和Linux,Windows版本即將推出。該產品定位於為用戶提供本地化的大語言模型運行環境,以滿足用戶個性化的需求。

模型訓練與部署

274.6K