Dressrecon

簡介 :

DressRecon是一個用於從單目視頻重建時間一致的4D人體模型的方法,專注於處理非常寬鬆的服裝或手持物體交互。該技術結合了通用的人體先驗知識(從大規模訓練數據中學習得到)和針對單個視頻的特定“骨骼袋”變形(通過測試時優化進行擬合)。DressRecon通過學習一個神經隱式模型來分離身體與服裝變形,作為單獨的運動模型層。為了捕捉服裝的微妙幾何形狀,它利用基於圖像的先驗知識,如人體姿勢、表面法線和光流,在優化過程中進行調整。生成的神經場可以提取成時間一致的網格,或者進一步優化為顯式的3D高斯,以提高渲染質量和實現交互式可視化。DressRecon在包含高度挑戰性服裝變形和物體交互的數據集上,提供了比以往技術更高的3D重建保真度。

需求人群 :

DressRecon的目標受眾是計算機視覺和圖形學領域的研究人員和開發者,特別是那些對4D人體模型重建、動作捕捉、虛擬現實和增強現實應用感興趣的人。該技術提供了一種高質量的人體模型重建方法,對於需要精確人體動作和服裝變形模擬的應用場景非常有價值。

使用場景

在虛擬現實遊戲中,使用DressRecon技術為玩家角色提供逼真的動作捕捉。

在電影和動畫製作中,利用DressRecon重建演員的動作和服裝,以創建更加真實的CG角色。

在時尚設計領域,通過DressRecon技術模擬不同體型和服裝的穿著效果。

產品特色

時間一致的人體模型重建:能夠處理非常寬鬆的服裝或手持物體交互。

分層變形:通過身體和服裝高斯模型捕捉肢體動作和服裝的細微變形。

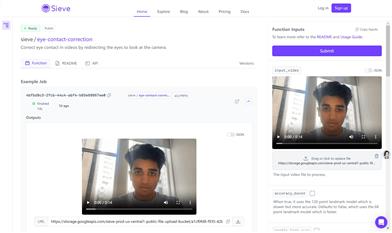

基於圖像的先驗知識:使用表面法線、光流等圖像基礎先驗知識作為優化的監督信號。

3D高斯優化:將隱式SDF提取成時間一致的網格,或進一步優化為顯式的3D高斯以提高渲染質量。

高保真度3D重建:即使在具有挑戰性的服裝變形和物體交互的場景中也能實現高保真度的3D重建。

極端視角合成:重建的化身可以從任何視角渲染。

運動分解:通過空間中均勻分佈的身體和服裝變形層,分別負責不同類型的運動。

使用教程

1. 準備一段單目視頻,視頻中包含需要重建的人體動作。

2. 確保視頻質量足夠高,以便捕捉到人體動作和服裝的細微變化。

3. 使用DressRecon提供的代碼和工具對視頻進行處理。

4. 根據需要調整模型參數,以優化重建結果。

5. 利用DressRecon的分層變形功能,分別處理身體和服裝的變形。

6. 使用基於圖像的先驗知識,如表面法線和光流,來提高重建的準確性。

7. 通過3D高斯優化步驟,進一步提升渲染質量和交互性。

8. 最終,查看並使用重建的4D人體模型進行進一步的應用或分析。