Hellomeme

簡介 :

HelloMeme是一個集成了空間編織注意力的擴散模型,旨在將高保真和豐富的條件嵌入到圖像生成過程中。該技術通過提取驅動視頻中的每一幀特徵,並將其作為輸入到HMControlModule,從而生成視頻。通過進一步優化Animatediff模塊,提高了生成視頻的連續性和保真度。此外,HelloMeme還支持通過ARKit面部混合形狀控制生成的面部表情,以及基於SD1.5的Lora或Checkpoint,實現了框架的熱插拔適配器,不會影響T2I模型的泛化能力。

需求人群 :

HelloMeme的目標受眾是圖像生成領域的研究人員和開發者,特別是那些對高保真度和豐富條件嵌入有需求的用戶。該技術可以幫助他們生成更自然、更連續的圖像和視頻,同時減少採樣步驟,提高效率。

使用場景

生成具有逼真面部表情的虛擬角色視頻。

製作連續性高且細節豐富的動畫視頻。

在遊戲或電影製作中生成高質量的動態圖像。

產品特色

網絡結構:構建了一種新的網絡結構,用於生成連續性和保真度更高的視頻。

圖像生成:能夠從驅動視頻中提取特徵並生成視頻。

運動模塊:通過Animatediff模塊優化,提高視頻幀之間的連續性。

表情編輯:使用ARKit面部混合形狀控制生成的面部表情。

與SD1.5兼容:基於SD1.5構建的框架,可以無縫集成任何在SD1.5基礎上開發的樣式化模型。

與LCM兼容:通過HMReferenceModule引入的高保真條件,可以在更少的採樣步驟中實現高保真結果。

與其他方法的比較:提供了與其他圖像生成方法的比較,展示了HelloMeme的優勢。

使用教程

步驟1:準備驅動視頻,確保視頻幀清晰且連貫。

步驟2:提取驅動視頻的每一幀特徵。

步驟3:將提取的特徵作為輸入到HMControlModule。

步驟4:通過Animatediff模塊優化視頻幀之間的連續性。

步驟5:如果需要編輯面部表情,使用ARKit面部混合形狀進行控制。

步驟6:根據需要,將HelloMeme與SD1.5或其他模型進行集成。

步驟7:調整參數,優化生成的圖像或視頻的質量。

步驟8:生成最終的圖像或視頻,並根據需要進行後期處理。

精選AI產品推薦

Sora

Sora是一個基於大規模訓練的文本控制視頻生成擴散模型。它能夠生成長達1分鐘的高清視頻,涵蓋廣泛的視覺數據類型和分辨率。Sora通過在視頻和圖像的壓縮潛在空間中訓練,將其分解為時空位置補丁,實現了可擴展的視頻生成。Sora還展現出一些模擬物理世界和數字世界的能力,如三維一致性和交互,揭示了繼續擴大視頻生成模型規模來發展高能力模擬器的前景。

AI視頻生成

17.2M

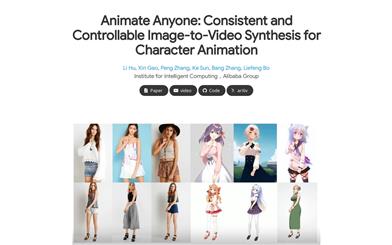

Animate Anyone

Animate Anyone旨在通過驅動信號從靜態圖像生成角色視頻。我們利用擴散模型的力量,提出了一個專為角色動畫量身定製的新框架。為了保持參考圖像中複雜外觀特徵的一致性,我們設計了ReferenceNet來通過空間注意力合併詳細特徵。為了確保可控性和連續性,我們引入了一個高效的姿勢指導器來指導角色的動作,並採用了一種有效的時間建模方法,以確保視頻幀之間的平滑跨幀過渡。通過擴展訓練數據,我們的方法可以為任意角色製作動畫,與其他圖像到視頻方法相比,在角色動畫方面取得了出色的結果。此外,我們在時尚視頻和人類舞蹈合成的基準上評估了我們的方法,取得了最先進的結果。

AI視頻生成

11.8M