Yuan2.0 M32

簡介 :

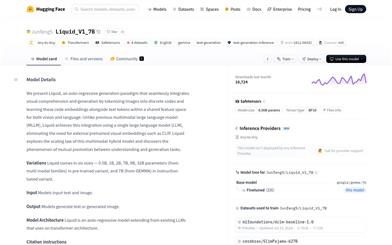

Yuan2.0-M32是一個具有32個專家的混合專家(MoE)語言模型,其中2個是活躍的。提出了一種新的路由網絡——注意力路由,用於更高效的專家選擇,提高了3.8%的準確性。該模型從零開始訓練,使用了2000B個token,其訓練計算量僅為同等參數規模的密集模型所需計算量的9.25%。在編碼、數學和各種專業領域表現出競爭力,僅使用3.7B個活躍參數,每個token的前向計算量僅為7.4 GFLOPS,僅為Llama3-70B需求的1/19。在MATH和ARC-Challenge基準測試中超越了Llama3-70B,準確率分別達到了55.9%和95.8%。

需求人群 :

Yuan2.0-M32適合需要在編碼、數學和專業領域進行高效計算和推理的開發者和研究人員。其低計算量和高準確性使其成為大規模語言模型應用的理想選擇。

使用場景

用於開發自然語言理解的應用程序

在數學問題解決中提供精確的計算支持

作為專業領域知識獲取和推理的輔助工具

產品特色

混合專家(MoE)模型,擁有32個專家,其中2個活躍

採用新的注意力路由網絡,提高模型選擇專家的效率

從零開始訓練,使用了2000B個token,訓練計算量低

在編碼、數學和專業領域表現出色,具有競爭力

在MATH和ARC-Challenge基準測試中超越其他模型

模型操作僅使用3.7B個活躍參數,計算效率高

使用教程

1. 配置環境,推薦使用Yuan2.0-M32的最新docker鏡像

2. 根據提供的腳本進行數據預處理

3. 使用示例腳本進行模型預訓練

4. 參考vllm的詳細部署計劃進行推理服務部署

5. 查看GitHub倉庫以獲取更多信息和文檔

精選AI產品推薦

Deepmind Gemini

Gemini是谷歌DeepMind推出的新一代人工智能系統。它能夠進行多模態推理,支持文本、圖像、視頻、音頻和代碼之間的無縫交互。Gemini在語言理解、推理、數學、編程等多個領域都超越了之前的狀態,成為迄今為止最強大的AI系統之一。它有三個不同規模的版本,可滿足從邊緣計算到雲計算的各種需求。Gemini可以廣泛應用於創意設計、寫作輔助、問題解答、代碼生成等領域。

AI模型

11.4M

中文精選

Liblibai

LiblibAI是一箇中國領先的AI創作平臺,提供強大的AI創作能力,幫助創作者實現創意。平臺提供海量免費AI創作模型,用戶可以搜索使用模型進行圖像、文字、音頻等創作。平臺還支持用戶訓練自己的AI模型。平臺定位於廣大創作者用戶,致力於創造條件普惠,服務創意產業,讓每個人都享有創作的樂趣。

AI模型

8.0M