使用場景

使用MInference在單個A100 GPU上實現1M上下文的快速推理。

結合Hugging Face的模型和MInference進行高效的文本生成任務。

在ICML'24會議上展示MInference 1.0的性能和應用案例。

產品特色

動態稀疏注意力模式識別:通過分析確定每個注意力頭屬於的稀疏模式。

在線稀疏索引近似:動態計算注意力,使用最優的自定義內核。

支持多種解碼型大型語言模型:包括LLaMA風格模型和Phi模型。

簡化安裝過程:通過pip命令快速安裝MInference。

提供豐富的文檔和示例:幫助用戶快速上手和應用MInference。

持續更新和社區支持:適應更多模型,不斷優化性能。

使用教程

1. 安裝必要的依賴,包括Torch和FlashAttention-2。

2. 使用pip安裝MInference。

3. 根據所使用的模型框架(如Hugging Face的transformers或vLLM),導入MInference模塊並應用到模型上。

4. 通過MInference模塊對模型進行patch,以利用動態稀疏注意力特性。

5. 運行推理任務,享受加速帶來的性能提升。

6. 參考MInference提供的示例和實驗,進一步探索和優化使用方式。

精選AI產品推薦

Openui

構建UI組件通常是一項乏味的工作。OpenUI旨在使這一過程變得有趣、快捷和靈活。這也是我們在W&B用於測試和原型化下一代工具的工具,用於在LLM的基礎上構建強大的應用程序。您可以使用想象力描述UI,然後即時查看渲染效果。您可以要求進行更改,並將HTML轉換為React、Svelte、Web組件等。就像是V0的開源和不太精緻的版本。

AI開發助手

785.5K

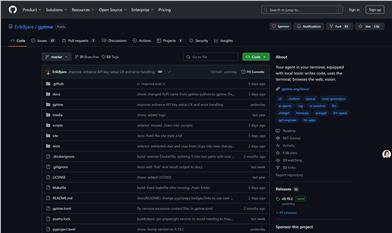

Opendevin

OpenDevin是一個開源項目,目標是複製、增強和創新Devin——一個能夠執行復雜工程任務並與用戶在軟件開發項目上積極協作的自主AI軟件工程師。該項目通過開源社區的力量,探索和擴展Devin的能力,識別其優勢和改進空間,以指導開源代碼模型的進展。

AI開發助手

613.8K