使用场景

使用MInference在单个A100 GPU上实现1M上下文的快速推理。

结合Hugging Face的模型和MInference进行高效的文本生成任务。

在ICML'24会议上展示MInference 1.0的性能和应用案例。

产品特色

动态稀疏注意力模式识别:通过分析确定每个注意力头属于的稀疏模式。

在线稀疏索引近似:动态计算注意力,使用最优的自定义内核。

支持多种解码型大型语言模型:包括LLaMA风格模型和Phi模型。

简化安装过程:通过pip命令快速安装MInference。

提供丰富的文档和示例:帮助用户快速上手和应用MInference。

持续更新和社区支持:适应更多模型,不断优化性能。

使用教程

1. 安装必要的依赖,包括Torch和FlashAttention-2。

2. 使用pip安装MInference。

3. 根据所使用的模型框架(如Hugging Face的transformers或vLLM),导入MInference模块并应用到模型上。

4. 通过MInference模块对模型进行patch,以利用动态稀疏注意力特性。

5. 运行推理任务,享受加速带来的性能提升。

6. 参考MInference提供的示例和实验,进一步探索和优化使用方式。

精选AI产品推荐

Openui

构建UI组件通常是一项乏味的工作。OpenUI旨在使这一过程变得有趣、快捷和灵活。这也是我们在W&B用于测试和原型化下一代工具的工具,用于在LLM的基础上构建强大的应用程序。您可以使用想象力描述UI,然后实时查看渲染效果。您可以要求进行更改,并将HTML转换为React、Svelte、Web组件等。就像是V0的开源和不太精致的版本。

AI开发助手

790.2K

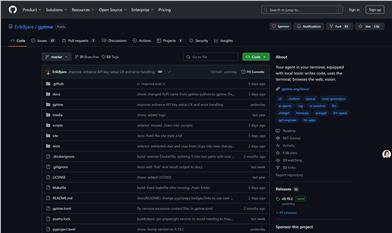

Opendevin

OpenDevin是一个开源项目,目标是复制、增强和创新Devin——一个能够执行复杂工程任务并与用户在软件开发项目上积极协作的自主AI软件工程师。该项目通过开源社区的力量,探索和扩展Devin的能力,识别其优势和改进空间,以指导开源代码模型的进展。

AI开发助手

618.8K