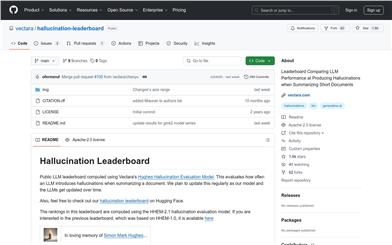

幻覚リーダーボード

紹介 :

Vectara社が開発したオープンソースプロジェクトで、大型言語モデル(LLM)が短い文書を要約する際の幻覚発生率を評価します。Vectara社のHughes幻覚評価モデル(HHEM-2.1)を用いて、モデルの出力における幻覚を検出することでランキングを算出します。より信頼性の高いLLMの研究開発に重要なツールであり、開発者はモデルの精度を理解し改善することができます。

ターゲットユーザー :

この製品は、自然言語処理分野の研究者、開発者、そしてLLMのパフォーマンス評価に関心のあるユーザーを主な対象としています。異なるLLMがコンテンツ生成における正確性と信頼性を理解し、特定のタスクに最適なモデルを選択するのに役立ちます。

使用シナリオ

研究者はこのランキングを使用して、異なるLLMモデルが要約を生成する際の幻覚率を比較し、より信頼性の高いモデルを選択できます。

開発者はこのツールを使用して、開発したLLMモデルのパフォーマンスを評価し、幻覚の発生を減らすためにモデルを最適化できます。

企業はこのランキングを参照して、コンテンツ生成、カスタマーサービスなどのシナリオで使用するために、ビジネスニーズに適したLLMモデルを選択できます。

製品特徴

HHEM-2.1モデルに基づくLLM幻覚評価を提供

複数のLLMの比較とランキングをサポート

CNN/Daily Mailコーパスを用いた文書要約テストの実施

API呼び出しによる様々なLLMモデルの評価

幻覚率、事実の一致率、回答率などの主要指標を提供

多言語モデルの評価をサポート(現時点では主に英語をサポート)

モデルのパフォーマンスの変化を反映するために定期的に更新

使用チュートリアル

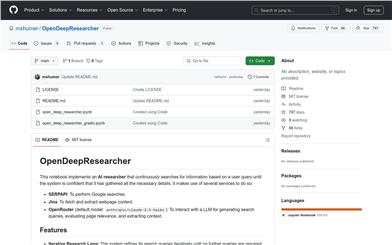

1. プロジェクトのホームページ(https://github.com/vectara/hallucination-leaderboard)にアクセスし、プロジェクトの背景と使用方法を確認します。

2. READMEファイルを参照し、HHEM-2.1モデルを使用した評価方法を確認します。

3. 評価対象のLLMモデルとそのAPIインターフェースを用意します。

4. プロジェクトで提供されているスクリプトまたはコードを使用して、LLMモデルを呼び出して要約を生成します。

5. HHEM-2.1モデルを使用して生成された要約を評価し、幻覚率などの指標を取得します。

6. 評価結果を分析し、異なるモデルのパフォーマンスを比較します。

7. 必要に応じてモデルを調整するか、より優れたモデルを選択して適用します。

おすすめAI製品

Elicit

Elicitは、研究論文を驚くべき速度で分析できるAIアシスタントです。論文要約、データ抽出、研究結果の統合など、煩雑なリサーチ作業を自動化します。関連論文の検索、1文要約の取得、論文からの詳細情報の抽出と整理、主題や概念の特定などが可能です。高い精度と使いやすさで、多くの研究者から信頼と好評を得ています。

研究機器

599.2K

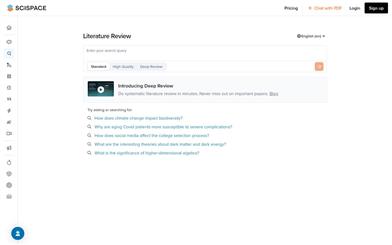

Scireviewhub

SciReviewHubは、人工知能を活用して科学論文の執筆と文献レビューを加速するツールです。AI技術を用いて、研究目的に関連する論文を迅速に絞り込み、最も関連性の高い情報を分かりやすく、すぐに使える文献レビューにまとめます。当プラットフォームを使用することで、研究効率の向上、出版時間の短縮、そして研究分野における飛躍的な進歩を実現できます。SciReviewHubに参加して、科学論文執筆の未来を再構築しましょう!

研究機器

285.7K