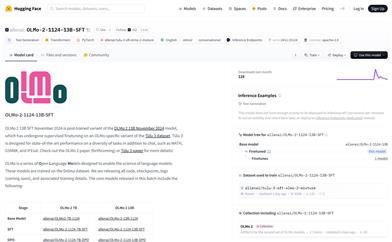

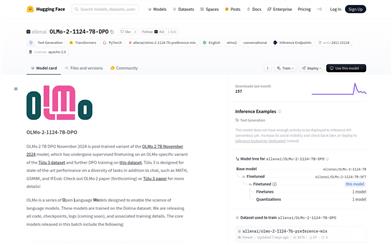

Olmo 2 1124 7B DPO

紹介 :

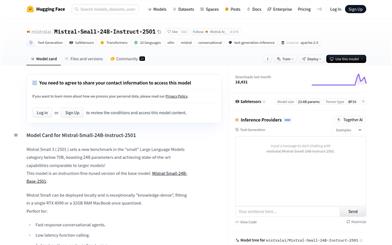

OLMo-2-1124-7B-DPOは、Allen Institute for AIによって開発された大規模言語モデルです。特定のデータセットを用いた教師ありファインチューニングと、DPOトレーニングが施されています。チャット、数学問題解答、テキスト生成など、様々なタスクにおいて高性能な結果を提供することを目指しています。Transformersライブラリを基盤として構築され、PyTorchに対応し、Apache 2.0ライセンスで公開されています。

ターゲットユーザー :

複雑な言語タスクに対応できる高性能モデルが必要な研究者、開発者、教育関係者を対象としています。OLMo-2-1124-7B-DPOは、強力なテキスト生成能力とマルチタスク処理能力を備えており、自然言語処理や機械学習の研究に携わるユーザーにとって特に適しています。

使用シナリオ

事例1:研究者はOLMo-2-1124-7B-DPOモデルを使用して、より自然で正確な会話を実現するチャットボットを開発しています。

事例2:教育機関は、このモデルを使用して、数学の問題と解答などの教材を生成し、教育を支援しています。

事例3:開発者は、このモデルをアプリケーションに統合して、自動コンテンツ生成機能を提供し、ユーザーエクスペリエンスを向上させています。

製品特徴

- テキスト生成に対応:流暢で関連性の高いテキストコンテンツを生成できます。

- 多様なタスク処理:チャット以外にも、数学問題、GSM8K、IFEvalなどのタスクに対応できます。

- ファインチューニング済み:特定のデータセットでファインチューニングされており、特定タスクでの性能が向上しています。

- PyTorchに対応:既存のPyTorchプロジェクトとの統合が容易です。

- Apache 2.0ライセンス準拠:研究および教育目的での自由な使用が許可されています。

- モデル性能データ:様々なタスクにおけるモデルの性能に関する詳細なデータを提供します。

- 配備が容易:Hugging Faceプラットフォームで簡単にモデルを読み込んで使用できます。

使用チュートリアル

1. Transformersライブラリのインストール:pipコマンドを使用して、最新バージョンのTransformersライブラリをインストールします。

2. モデルの読み込み:Hugging Faceが提供するコードスニペットを使用して、OLMo-2-1124-7B-DPOモデルを読み込みます。

3. チャットテンプレートの使用:提供されているチャットテンプレートの形式に従って、ユーザーとアシスタント間の会話を入力します。

4. システムプロンプトの設定:必要に応じて、システムプロンプトを設定してモデルの動作を指示します。

5. テキストの生成:モデルのテキスト生成能力を利用して、プロンプトを入力し、生成されたテキストを取得します。

6. パフォーマンスの評価:様々なタスクにおけるモデルのパフォーマンスデータを参照して、モデルの性能を評価します。

7. モデルのファインチューニング:必要に応じて、特定のデータセットでモデルをさらにファインチューニングできます。

おすすめAI製品

中国語精選

豆包(doubao)

豆包(Doubao)は、自然言語処理を用いたインテリジェントなチャットボットです。天気、ニュース、ジョーク、音楽など、様々な話題でユーザーと自然な会話を楽しむことができます。さらに、ユーザーの好みや習慣に基づいて、関連性の高いコンテンツやサービスをレコメンドします。豆包はあなた専属のチャットアシスタントとして、寂しさを解消します。

会話型AI

17.0M

中国語精選

Kimiスマートアシスタント

Kimi Chatは、月之暗面科技が開発した、スマートなチャットボットアプリです。大容量の知識ベースを備え、インテリジェントな雑談、質問への回答、生活支援サービスの提供など、高度なインテリジェントなインタラクション能力を備えています。いつでもどこでもKimiとチャットして楽しみを見つけることができ、その返答は多様で、会話をより楽しくします。Kimi Chatは完全に無料で、QRコードをスキャンするか、携帯電話で検索して直接使用できます。

会話型AI

15.9M