Olmo 2 1124 13B DPO

紹介 :

OLMo-2-1124-13B-DPOは、130億パラメータの大規模言語モデルであり、教師あり微調整とDPOトレーニングにより、チャット、数学、GSM8K、IFEvalなど様々なタスクにおいて優れた性能を発揮するように設計されています。英語を主にターゲットとしています。このモデルはOLMoシリーズの一部であり、言語モデルの科学研究を促進することを目的としています。Dolmaデータセットに基づいてトレーニングされており、コード、チェックポイント、ログ、トレーニングの詳細を公開しています。

ターゲットユーザー :

本モデルのターゲットユーザーは、自然言語処理の研究、チャットボットの構築、機械翻訳ツールの開発、その他のテキスト生成アプリケーションなどに活用したい研究者、開発者、教育機関です。高性能と多様なタスクへの対応能力から、大量の英語テキストデータを扱う必要がある場合に特に適しています。

使用シナリオ

事例1:研究者がOLMo-2-1124-13B-DPOモデルを使用して感情分析研究を行いました。

事例2:開発者がこのモデルをQ&Aシステムに統合し、リアルタイムの自然言語インタラクションを提供しました。

事例3:教育機関が本モデルを利用して、生徒が複雑な言語構造を理解し学習するための教育支援ツールを開発しました。

製品特徴

? テキスト生成に対応:一貫性があり関連性のあるテキストコンテンツを生成できます。

? 多様なタスクへの対応:チャット、数学問題解決、GSM8K、IFEvalなど、様々なタスクで優れた性能を発揮します。

? ファインチューニング機能:特定のデータセットによるファインチューニングを行い、特定のタスクのパフォーマンスを向上させることができます。

? 簡単な統合:Hugging Faceプラットフォームで簡単にロードして使用できます。

? Apache 2.0ライセンスに準拠:研究および教育目的での自由な使用を許可します。

? モデルシリーズの一部:他のモデルとコアアーキテクチャとトレーニング手法を共有しています。

? 科学研究の促進:言語モデルの科学研究と技術革新を促進することを目的としています。

使用チュートリアル

1. Transformersライブラリのインストール:pipコマンドを使用して、最新バージョンのTransformersライブラリをインストールします。

2. モデルの読み込み:Hugging Faceが提供するAPIを使用して、OLMo-2-1124-13B-DPOモデルを読み込みます。

3. データの前処理:入力テキストを、チャットテンプレートなど、モデルに必要な形式に変換します。

4. モデル推論:前処理されたデータを入力して、モデルの出力結果を取得します。

5. 結果の分析:モデルの出力結果に基づいて、さらなる分析を行うか、実際の場面に直接適用します。

6. モデルのファインチューニング:必要に応じて、特定のデータセットでモデルをファインチューニングして性能を最適化できます。

7. モデルのデプロイ:トレーニング済みのモデルを本番環境にデプロイしてサービスを提供します。

おすすめAI製品

中国語精選

文心一言

文心一言は、百度が開発した最新世代の知識増強型大規模言語モデルです。人間と対話したり、質問に答えたり、創作を支援したりすることで、人々が効率的かつ簡単に情報、知識、そしてインスピレーションを得られるよう支援します。飛槳(PaddlePaddle)深層学習プラットフォームと文心知識増強大規模言語モデルをベースに、膨大なデータと大規模な知識から継続的に学習しており、知識増強、検索増強、対話増強といった技術的特徴を備えています。皆様からのフィードバックをお待ちしております。文心一言の更なる進化にご協力ください。

チャットボット

5.4M

海外精選

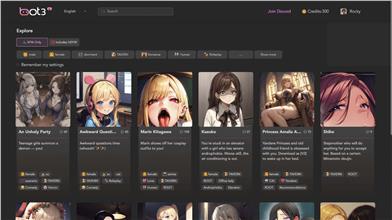

Bot3 AI

BOT3 AIは、究極のAI会話ロボットです。かつてないほどスマートな会話を実現し、AIキャラクターとの交流をお楽しみいただけます。

チャットボット

2.7M