Animate3d

紹介 :

Animate3Dは、任意の静止3Dモデルにアニメーションを生成するための革新的なフレームワークです。その中核となる概念は2つの主要な部分から構成されます。1) 静止3Dオブジェクトの多視点レンダリングに基づき、大規模な多視点ビデオデータセット(MV-Video)を用いてトレーニングされた、新しい多視点ビデオ拡散モデル(MV-VDM)を提案します。2) MV-VDMに基づき、再構成と4Dスコア蒸留サンプリング(4D-SDS)を組み合わせたフレームワークを導入し、多視点ビデオ拡散事前情報を利用して3Dオブジェクトのアニメーションを生成します。Animate3Dは、新しい時空間注意機構モジュールを設計することで空間的および時間的一貫性を強化し、多視点レンダリングによって静止3Dモデルのアイデンティティを維持します。さらに、Animate3Dは、3Dモデルにアニメーションを生成するための効率的な2段階のプロセスを提案します。まず、生成された多視点ビデオから直接モーションを再構成し、次に導入された4D-SDSを用いて外観とモーションを洗練します。

ターゲットユーザー :

Animate3Dのターゲットユーザーは、3Dアニメーション制作者、ゲーム開発者、映画制作者、そして3Dモデルにアニメーションを生成する必要があるあらゆる専門家です。彼らはAnimate3Dを使用して、高品質なアニメーションを迅速に生成し、時間とコストを節約しながら、アニメーションの自然な流れと一貫性を維持できます。

使用シナリオ

アニメーション制作者は、Animate3Dを使用して映画の3Dキャラクターにリアルなアニメーション効果を生成します。

ゲーム開発者は、Animate3Dを使用してゲームの仮想キャラクターにスムーズな動きを生成します。

教育分野では、教師がAnimate3Dを使用して教材の3Dモデルにアニメーションを生成し、教育のインタラクティブ性と面白さを高めます。

製品特徴

多視点ビデオ拡散モデル(MV-VDM):静止3Dオブジェクトの多視点レンダリングに基づき、大規模な多視点ビデオデータセットでトレーニングされます。

時空間注意機構モジュール:空間的および時間的一貫性を強化し、3Dおよびビデオ拡散モデルを統合します。

4Dスコア蒸留サンプリング(4D-SDS):再構成とサンプリングを組み合わせ、外観とモーションを洗練します。

大規模多視点ビデオデータセット(MV-Video):115,000件のアニメーションを含み、53,000件のアニメーション3Dオブジェクトをカバーし、180万件以上の多視点ビデオにレンダリングされています。

アニメーション再構成:生成された多視点ビデオからモーションを直接再構成します。

アニメーション洗練:4D-SDSを用いて外観とモーションをさらに最適化します。

データ、コード、およびモデルのオープンリリース:さらなる研究と応用のためのリソースを提供します。

使用チュートリアル

1. Animate3Dの公式サイトにアクセスし、関連するデータセットとコードをダウンロードします。

2. 静止3Dモデルファイルを用意し、多視点レンダリングに対応していることを確認します。

3. Animate3Dの多視点ビデオ拡散モデル(MV-VDM)を使用してモデルをトレーニングします。

4. MV-VDMを使用して多視点ビデオを生成し、アニメーションを再構成します。

5. 4Dスコア蒸留サンプリング(4D-SDS)を使用して、アニメーションの外観とモーションをさらに洗練します。

6. 生成されたアニメーションの効果を確認し、期待するアニメーション効果に合致していることを確認します。

7. 生成されたアニメーションを映画、ゲーム、教育資料などの必要なプロジェクトに適用します。

おすすめAI製品

Sora

Soraは、大規模データで学習されたテキスト制御型ビデオ生成拡散モデルです。1分間の高解像度ビデオ生成が可能で、幅広い視覚データの種類と解像度に対応します。ビデオと画像の圧縮潜在空間で学習することで、時空間的位置パッチに分解し、スケーラブルなビデオ生成を実現しています。また、三次元の一貫性やインタラクションなど、物理世界とデジタル世界の挙動をある程度シミュレートできる能力を示しており、高性能シミュレータの開発に向けて、ビデオ生成モデルの大規模化が有望であることを示唆しています。

AI動画生成

17.0M

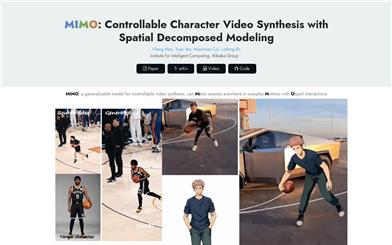

Animate Anyone

Animate Anyoneは、駆動信号から静止画像を基にキャラクタビデオを生成することを目指しています。拡散モデルの力を活用し、キャラクタアニメーション用に特化した新しいフレームワークを提案します。参照画像における複雑な外観特徴の一貫性を維持するため、空間的注意機構を用いて詳細な特徴を統合するReferenceNetを設計しました。制御可能性と連続性を確保するため、キャラクタの動作をガイドする効率的なポーズガイド機構を導入し、ビデオフレーム間の滑らかなクロスフェードを実現する効果的な時間モデリング手法を採用しています。トレーニングデータの拡張により、任意のキャラクタのアニメーション作成が可能になり、他の画像からビデオへの変換手法と比較して、キャラクタアニメーションにおいて優れた結果を得ています。さらに、ファッションビデオと人間のダンス合成のベンチマークにおいて最先端の結果を達成しました。

AI動画生成

11.4M