Vta Ldm

紹介 :

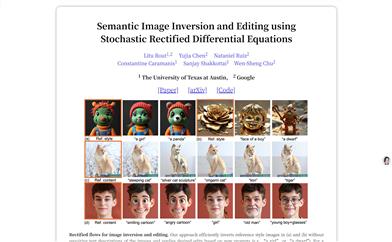

vta-ldmは、動画の内容に基づいて、意味的にも時間的にも動画入力と整合性の取れた音声コンテンツを生成することに特化した深層学習モデルです。テキストから動画を生成する技術が著しい進歩を遂げた後に生まれた、動画生成分野における新たなブレイクスルーと言えるでしょう。テンセントAIラボのManjie Xu氏らによって開発され、動画の内容と高度に一致した音声を生成できる能力を備えています。動画制作、音声後処理などの分野において重要な応用価値を有しています。

ターゲットユーザー :

本製品は、動画制作者、音響エンジニア、動画の内容に基づいて音声を生成する必要があるあらゆる専門家に適しています。動画の内容に合わせた音声を迅速に生成し、作業効率を向上させると同時に、動画により豊かで魅力的な聴覚体験を加えることができます。

使用シナリオ

無音動画に背景音や会話を追加する動画制作

動画シーンに基づいて環境音を生成する音声後処理

教育分野における、講義動画への解説音声を自動生成

製品特徴

動画の内容に基づいて、意味的かつ時間的に整合した音声を生成する

condaを用いたPython依存関係のインストールをサポートする

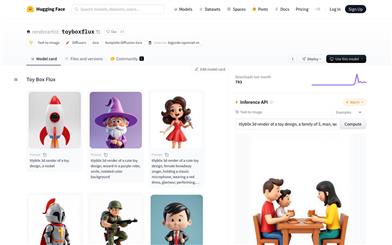

Hugging Faceからのチェックポイントダウンロードを推奨する方法を提供する

VTA_LDM+IB/LB/CAVP/VIVITなど、複数のモデルバリエーションを提供する

ユーザーが個々のニーズに合わせてハイパーパラメータをカスタマイズすることを許可する

生成された音声を元の動画とマージするためのスクリプトを提供する

ffmpegベースの音声?動画マージ機能を提供する

使用チュートリアル

1. Python環境をインストールし、condaを使用して必要な依存パッケージをインストールします。

2. Hugging Faceからモデルのチェックポイントをダウンロードします。

3. 動画ファイルを指定のデータディレクトリに配置します。

4. 提供されている推論スクリプトを実行し、入力動画から音声コンテンツの生成を開始します。

5. 必要に応じて、スクリプト内のハイパーパラメータを調整します。

6. 提供されているスクリプトを使用して、生成された音声を元の動画とマージします。

おすすめAI製品

中国語精選

剪映dreamina

剪映DreaminaはTikTok(抖音)が提供するAIGCツールです。テキストを入力すると、AIが自動的にクリエイティブな画像を生成します。画像サイズやアスペクト比、テンプレートの種類も調整可能です。将来的には、TikTokの画像投稿やショート動画のコンテンツ制作にも活用され、TikTokのAIによるコンテンツ制作の充実を図ります。

AI画像生成

9.0M

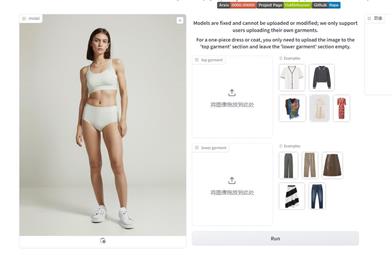

Outfit Anyone

Outfit Anyoneは、衣類を実際に試着することなく様々なファッションスタイルを試せる、超高品質のバーチャル試着製品です。2つの流れを持つ条件付き拡散モデルを採用することで、衣類の変形を柔軟に処理し、よりリアルな効果を生み出します。拡張性が高く、ポーズや体型などの要素を調整でき、アニメキャラクターから実写の人物まで幅広い画像に対応可能です。様々なシーンでの優れたパフォーマンスは、その実用性と実用化への準備が整っていることを示しています。

AI画像生成

5.2M